Aktualizace ChatGPT umožňuje jeho AI „vidět, slyšet a mluvit“ podle OpenAI

V pondělí OpenAI oznámila významnou aktualizaci ChatGPT, která umožňuje jejím modelům GPT-3.5 a GPT-4 AI analyzovat obrázky a reagovat na ně v rámci textové konverzace. Mobilní aplikace ChatGPT také přidá možnosti syntézy řeči, které po spárování se stávajícími funkcemi rozpoznávání řeči umožní plně verbální konverzace s asistentem AI, říká OpenAI.

OpenAI plánuje zavést tyto funkce v ChatGPT pro předplatitele Plus a Enterprise „během příštích dvou týdnů.“ Také poznamenává, že syntéza řeči přichází pouze pro iOS a Android a rozpoznávání obrázků bude dostupné jak na webovém rozhraní, tak na mobilní aplikace.

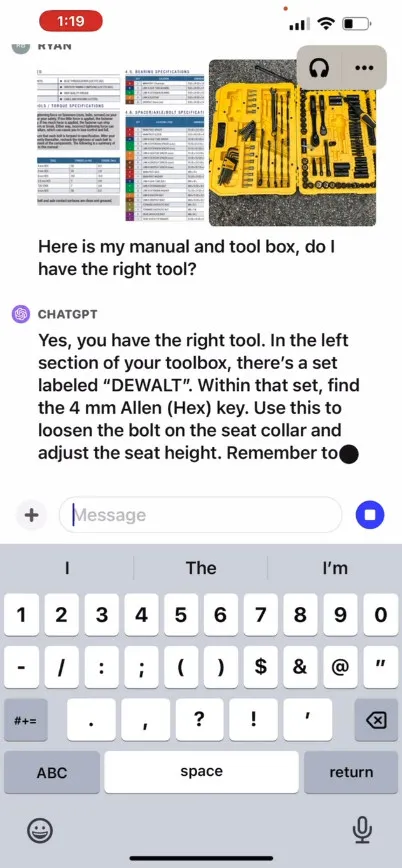

OpenAI říká, že nová funkce rozpoznávání obrázků v ChatGPT umožňuje uživatelům nahrávat jeden nebo více obrázků pro konverzaci pomocí modelů GPT-3.5 nebo GPT-4. Ve svém propagačním příspěvku na blogu společnost tvrdí, že tuto funkci lze použít pro různé každodenní aplikace: od zjišťování, co je k večeři fotografováním lednice a spíže, až po řešení problémů, proč se váš gril nespustí. Uvádí také, že uživatelé mohou pomocí dotykové obrazovky svého zařízení zakroužkovat části obrazu, na které by se ChatGPT chtěl soustředit.

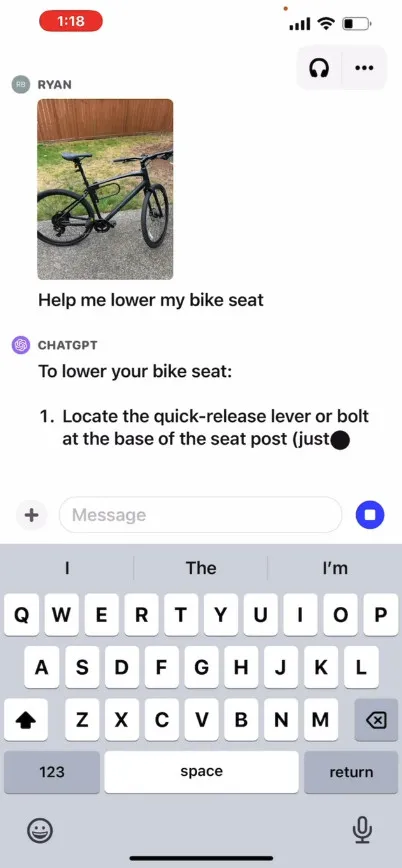

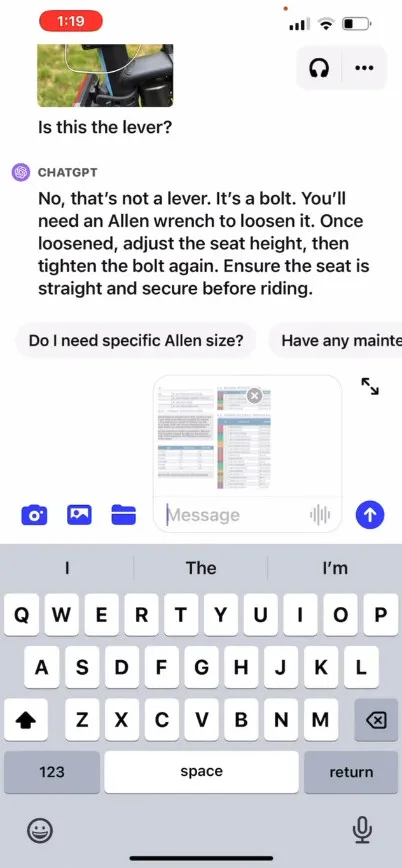

OpenAI na svých stránkách poskytuje propagační video , které ilustruje hypotetickou výměnu názorů s ChatGPT, kde se uživatel ptá, jak zvednout sedadlo na kole, poskytuje fotografie, stejně jako návod k použití a obrázek uživatelské sady nástrojů. ChatGPT reaguje a radí uživateli, jak proces dokončit. Sami jsme tuto funkci netestovali, takže její účinnost v reálném světě není známa.

Jak to tedy funguje? OpenAI nezveřejnila technické podrobnosti o tom, jak GPT-4 nebo jeho multimodální verze GPT-4V fungují pod kapotou, ale na základě známého výzkumu umělé inteligence od ostatních (včetně partnera OpenAI Microsoft ), multimodální modely umělé inteligence obvykle transformují text a obrázky na sdílený kódovací prostor, který jim umožňuje zpracovávat různé typy dat prostřednictvím stejné neuronové sítě. OpenAI může použít CLIP k překlenutí mezery mezi vizuálními a textovými daty způsobem, který zarovná obrazové a textové reprezentace do stejného latentního prostoru , což je druh vektorizované sítě datových vztahů. Tato technika by mohla umožnit ChatGPT provádět kontextové dedukce napříč textem a obrázky, i když je to z naší strany spekulativní.

Mezitím v oblasti zvuku nová funkce hlasové syntézy ChatGPT údajně umožňuje mluvenou konverzaci tam a zpět s ChatGPT, řízenou tím, co OpenAI nazývá „novým modelem převodu textu na řeč“, i když převod textu na řeč již byl vyřešen. dlouho. Jakmile bude funkce spuštěna, společnost říká, že uživatelé mohou tuto funkci zapojit tak, že se přihlásí k hlasovým konverzacím v nastavení aplikace a poté si vyberou z pěti různých syntetických hlasů s názvy jako „Juniper“, „Sky“, „Cove“, „Ember “a “Breeze.” OpenAI říká, že tyto hlasy byly vytvořeny ve spolupráci s profesionálními hlasovými herci.

OpenAI Whisper, open source systém pro rozpoznávání řeči, kterým jsme se zabývali v září loňského roku, bude i nadále zpracovávat přepis uživatelského hlasového vstupu. Whisper je integrován s aplikací ChatGPT pro iOS od jejího spuštění v květnu. OpenAI vydala podobně schopnou aplikaci ChatGPT pro Android v červenci.

Napsat komentář