Alexa vil deepfake de levendes og de dødes stemmer i featureudvikling

Amazon er ved at finde ud af, hvordan man får Alexas stemmeassistent til at forfalske stemmen til enhver, død eller levende, med kun en kort optagelse. Virksomheden fremviste indslaget på sin re:Mars- konference i Las Vegas onsdag, ved at bruge det følelsesmæssige traume fra den igangværende pandemi og sorg til at skabe interesse.

Amazons Re:Mars fokuserer på kunstig intelligens, maskinlæring, robotteknologi og andre nye teknologier, med tekniske eksperter og industriledere på scenen. Under anden dags keynote viste Rohit Prasad, Senior Vice President og Chief Scientist for Alexa AI hos Amazon, en funktion, der i øjeblikket udvikles til Alexa.

I demonstrationen spørger et barn Alexa: “Kan bedstemor læse The Wizard of Oz for mig?” Alexa svarer: “Okay,” med sin typiske feminine robotstemme. Men så høres barnets bedstemors stemme fra taleren, som læser et eventyr af L. Frank Baum.

Du kan se en demo nedenfor:

Prasad sagde kun, at Amazon “arbejder” på Alexa-kapaciteten og uddybede ikke, hvilket arbejde der er tilbage, og hvornår eller om det vil være tilgængeligt.

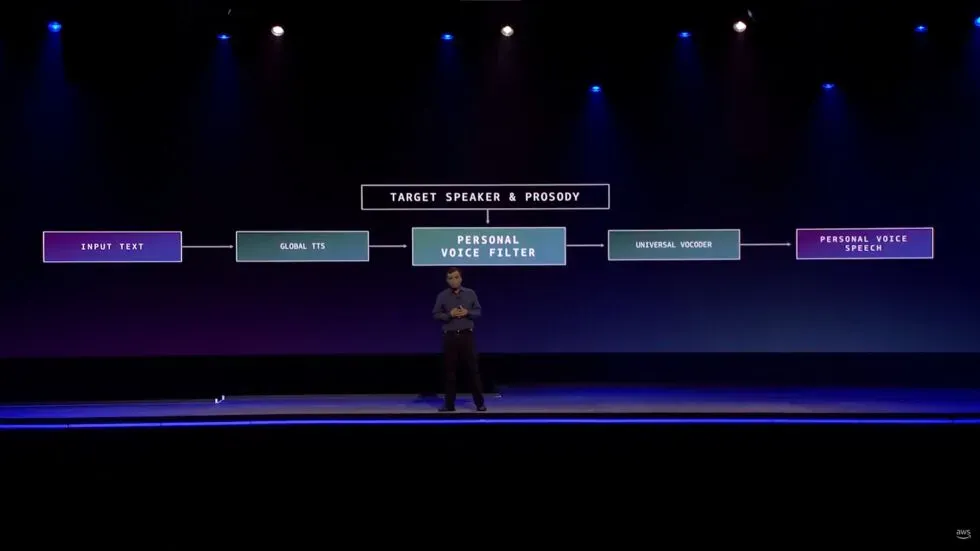

Han leverede dog de mindste tekniske detaljer.

“Det krævede opfindelse, da vi skulle lære at gengive stemme af høj kvalitet på mindre end et minuts optagelse sammenlignet med timers optagelse i studiet,” sagde han. “Vi gjorde dette muligt ved at fremstille problemet som et stemmekonverteringsproblem snarere end et talegenereringsproblem.”

Selvfølgelig har deepfakes af alle typer generelt et blandet ry. Der er dog gjort nogle forsøg på at bruge teknologien som et værktøj snarere end et redskab til uhygge.

Især lyddeepfakes, som The Verge bemærker, er blevet brugt i medierne til at kompensere for, når f.eks. en podcaster forkludrede en linje, eller når et projekts stjerne pludselig døde, som det skete med Anthony Bourdains Roadrunner- dokumentar .

Publikationen bemærker, at der endda er tilfælde af mennesker, der bruger AI til at skabe chatbots , der kommunikerer, som om de var mistede kære.

Alexa vil ikke engang være det første forbrugerprodukt, der bruger deepfake-lyd til at erstatte et familiemedlem, der ikke kan være til stede personligt. Smart højttaler Takara Tomy , som Gi z modo påpeger, bruger kunstig intelligens til at læse godnathistorier for børn i en forælders stemme. Forældre rapporteres at uploade deres stemmer ved at læse manuskriptet i omkring 15 minutter, så at sige. Selvom dette adskiller sig markant fra Amazons demo, idet produktejeren vælger at give deres egen vokal frem for produktet ved at bruge stemmen fra en person, der sandsynligvis ikke kan give deres tilladelse.

Bortset fra bekymringer om deepfakes, der bliver brugt til svindel, røverier og andre uhyggelige aktiviteter, er der allerede nogle foruroligende ting om, hvordan Amazon bygger denne funktion, som ikke engang har en udgivelsesdato endnu.

Før han viste demoen, talte Prasad om, hvordan Alexa giver brugerne et “kammeratskabsforhold.”

“I denne kammeratskabsrolle er de menneskelige egenskaber empati og affekt nøglen til at opbygge tillid,” sagde administrerende direktør. “Disse egenskaber er blevet endnu vigtigere under den igangværende pandemi, hvor mange af os har mistet en, vi elsker. Selvom AI’en ikke kan eliminere denne smerte ved tab, kan den helt sikkert udvide deres hukommelse.”

Prasad tilføjede, at funktionen “giver et varigt personligt forhold.”

Det er rigtigt, at utallige mennesker seriøst søger menneskelig “empati og affekt” som reaktion på den følelsesmæssige stress forårsaget af COVID-19-pandemien. Amazons stemmeassistent med kunstig intelligens er dog ikke op til opgaven med at opfylde disse menneskelige behov. Alexa kan heller ikke give “langsigtede personlige relationer” med mennesker, der ikke længere er hos os.

Det er ikke svært at tro, at der er gode intentioner bag denne udviklende funktion, og at det kan være en stor trøst at høre stemmen til den person, du savner. Teoretisk set kunne vi endda have det sjovt med sådan en funktion. At få Alexa til at få en ven til at lyde, som om de sagde noget dumt, er harmløst. Og som vi sagde ovenfor, er der andre virksomheder, der bruger deepfake-teknologi på måder, der ligner det, Amazon demonstrerede.

Men at præsentere Alexas udviklende evne som en måde at genoprette forbindelsen til afdøde familiemedlemmer er et kæmpe, urealistisk og problematisk spring. I mellemtiden ser det ud til at være nyttesløst at røre ved hjertets strenge, hvilket forårsager sorg og ensomhed forbundet med pandemien. Der er steder, hvor Amazon ikke hører hjemme, og sorgrådgivning er en af dem.

Skriv et svar