Laut OpenAI ermöglicht das ChatGPT-Update seiner KI das „Sehen, Hören und Sprechen“.

Am Montag kündigte OpenAI ein bedeutendes Update für ChatGPT an, das es seinen GPT-3.5- und GPT-4-KI-Modellen ermöglicht, Bilder zu analysieren und im Rahmen einer Textkonversation darauf zu reagieren. Außerdem wird die mobile ChatGPT-App Sprachsyntheseoptionen hinzufügen, die in Kombination mit den vorhandenen Spracherkennungsfunktionen vollständig verbale Gespräche mit dem KI-Assistenten ermöglichen, sagt OpenAI.

OpenAI plant, diese Funktionen „in den nächsten zwei Wochen“ in ChatGPT für Plus- und Enterprise-Abonnenten einzuführen. Außerdem wird darauf hingewiesen, dass die Sprachsynthese nur für iOS und Android verfügbar sein wird und die Bilderkennung sowohl auf der Weboberfläche als auch auf dem verfügbar sein wird mobile Apps.

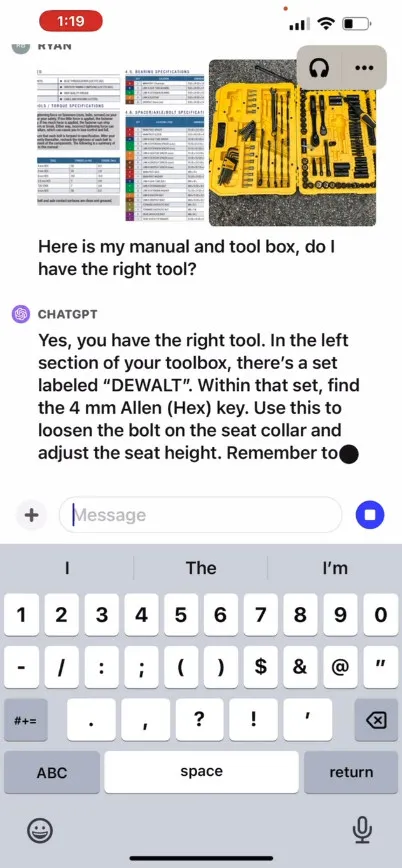

Laut OpenAI können Benutzer mit der neuen Bilderkennungsfunktion in ChatGPT ein oder mehrere Bilder zur Konversation hochladen, indem sie entweder die Modelle GPT-3.5 oder GPT-4 verwenden. In seinem Werbe-Blogbeitrag behauptet das Unternehmen, dass die Funktion für eine Vielzahl alltäglicher Anwendungen genutzt werden kann: von der Ermittlung, was es zum Abendessen gibt, indem Sie Fotos vom Kühlschrank und der Speisekammer machen, bis hin zur Fehlerbehebung, warum Ihr Grill nicht startet. Außerdem heißt es, dass Benutzer den Touchscreen ihres Geräts verwenden können, um Teile des Bildes einzukreisen, auf die sich ChatGPT konzentrieren soll.

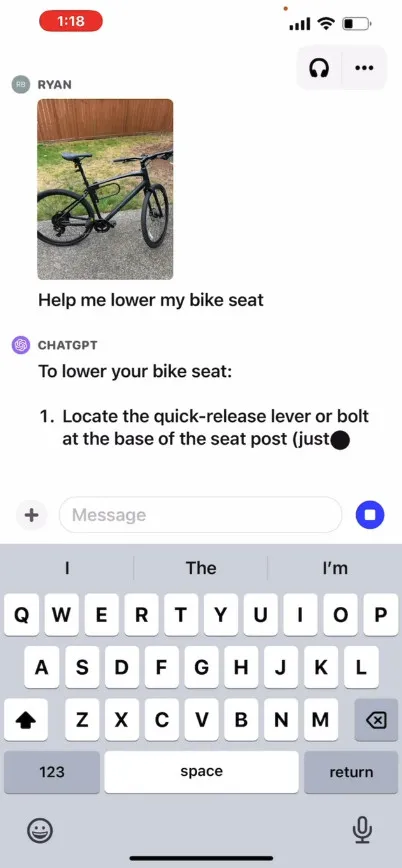

OpenAI stellt auf seiner Website ein Werbevideo zur Verfügung, das einen hypothetischen Austausch mit ChatGPT veranschaulicht, bei dem ein Benutzer fragt, wie man einen Fahrradsitz anhebt, und stellt Fotos sowie eine Bedienungsanleitung und ein Bild des Werkzeugkastens des Benutzers bereit. ChatGPT reagiert und weist den Benutzer darauf hin, wie er den Vorgang abschließen kann. Wir haben diese Funktion nicht selbst getestet, daher ist ihre tatsächliche Wirksamkeit nicht bekannt.

Wie funktioniert es also? OpenAI hat keine technischen Details darüber veröffentlicht, wie GPT-4 oder seine multimodale Version, GPT-4V , unter der Haube funktionieren, aber basierend auf bekannten KI-Forschungen von anderen (einschließlich des OpenAI-Partners Microsoft ) wandeln multimodale KI-Modelle typischerweise Text und Bilder in a um Gemeinsamer Codierungsraum, der es ihnen ermöglicht, verschiedene Arten von Daten über dasselbe neuronale Netzwerk zu verarbeiten. OpenAI kann CLIP verwenden , um die Lücke zwischen visuellen und Textdaten auf eine Weise zu schließen, die Bild- und Textdarstellungen im selben latenten Raum ausrichtet , einer Art vektorisiertes Netz von Datenbeziehungen. Diese Technik könnte es ChatGPT ermöglichen, kontextbezogene Schlussfolgerungen aus Text und Bildern zu ziehen, obwohl dies unsererseits spekulativ ist.

Unterdessen ermöglicht die neue Sprachsynthesefunktion von ChatGPT im Audiobereich Berichten zufolge eine hin- und hergehende gesprochene Konversation mit ChatGPT, angetrieben durch das, was OpenAI ein „neues Text-to-Speech-Modell“ nennt, obwohl Text-to-Speech schon seit einiger Zeit gelöst ist lange Zeit. Sobald die Funktion eingeführt wird, können Benutzer die Funktion nach Angaben des Unternehmens nutzen, indem sie sich in den Einstellungen der App für Sprachgespräche entscheiden und dann aus fünf verschiedenen synthetischen Stimmen mit Namen wie „Juniper“, „Sky“, „Cove“ oder „Ember“ auswählen „“ und „Breeze“. Laut OpenAI wurden diese Stimmen in Zusammenarbeit mit professionellen Synchronsprechern erstellt.

Whisper von OpenAI, ein Open-Source-Spracherkennungssystem, über das wir im September letzten Jahres berichtet haben, wird weiterhin die Transkription der Spracheingaben des Benutzers übernehmen. Whisper ist seit seiner Einführung im Mai in die ChatGPT-iOS-App integriert . OpenAI veröffentlichte im Juli die ähnlich leistungsfähige ChatGPT-Android-App .

Schreibe einen Kommentar