Alexa wird in der Feature-Entwicklung die Stimmen der Lebenden und der Toten per Deepfake fälschen

Amazon findet heraus, wie man Alexas Sprachassistenten mit nur einer kurzen Aufnahme dazu bringen kann, die Stimme eines jeden toten oder lebendigen Menschen zu fälschen. Das Unternehmen stellte das Feature am Mittwoch auf seiner re:Mars- Konferenz in Las Vegas vor und nutzte dabei das emotionale Trauma der anhaltenden Pandemie und die Trauer, um Interesse zu wecken.

Amazons Re:Mars konzentriert sich auf künstliche Intelligenz, maschinelles Lernen, Robotik und andere neue Technologien, wobei Technologieexperten und Branchenführer die Bühne betreten. Während der Keynote des zweiten Tages stellte Rohit Prasad, Senior Vice President und Chefwissenschaftler von Alexa AI bei Amazon, eine Funktion vor, die derzeit für Alexa entwickelt wird.

In der Demonstration fragt ein Kind Alexa: „Kann Oma den Zauberer von Oz für mich zu Ende vorlesen?“ Alexa antwortet mit ihrer typischen weiblichen Roboterstimme: „Okay.“ Doch dann ertönt aus dem Sprecher die Stimme der Großmutter des Kindes, die ein Märchen von L. Frank Baum vorliest.

Unten können Sie sich eine Demo ansehen:

Prasad sagte lediglich, dass Amazon an der Alexa-Fähigkeit „arbeitet“, und ging nicht näher darauf ein, welche Arbeiten noch zu erledigen sind und wann oder ob sie verfügbar sein werden.

Er lieferte jedoch die kleinsten technischen Details.

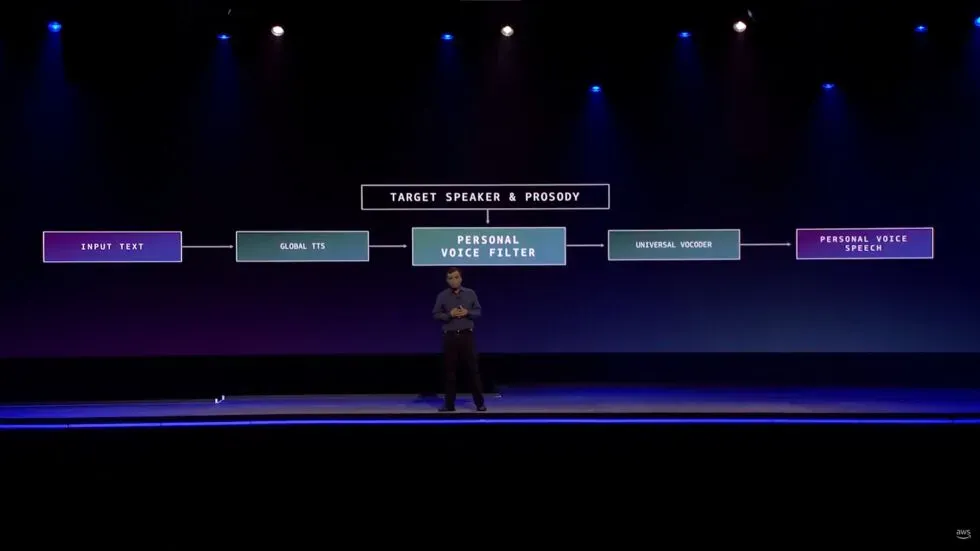

„Es erforderte Erfindungsreichtum, als wir lernen mussten, wie wir eine qualitativ hochwertige Stimme in weniger als einer Minute Aufnahme reproduzieren konnten, verglichen mit stundenlangen Aufnahmen im Studio“, sagte er. „Wir haben dies ermöglicht, indem wir das Problem als Sprachkonvertierungsproblem und nicht als Spracherzeugungsproblem definiert haben.“

Natürlich haben Deepfakes aller Art im Allgemeinen einen gemischten Ruf. Es wurden jedoch einige Versuche unternommen, die Technologie eher als Werkzeug denn als Vehikel für Unheimlichkeiten zu nutzen.

Insbesondere Audio-Deepfakes wurden, wie The Verge anmerkt, in den Medien eingesetzt, um auszugleichen, wenn beispielsweise ein Podcaster eine Zeile vermasselt hatte oder der Star eines Projekts plötzlich starb, wie es bei der Roadrunner- Dokumentation von Anthony Bourdain der Fall war.

In der Veröffentlichung heißt es, dass es sogar Fälle gibt, in denen Menschen KI verwenden, um Chatbots zu erstellen , die kommunizieren, als wären sie verlorene geliebte Menschen.

Alexa wird nicht einmal das erste Verbraucherprodukt sein, das Deepfake-Audio verwendet, um ein Familienmitglied zu ersetzen, das nicht persönlich anwesend sein kann. Der intelligente Sprecher Takara Tomy nutzt künstliche Intelligenz, um Kindern mit der Stimme eines Elternteils Gute-Nacht-Geschichten vorzulesen , wie Giz Modo betont . Berichten zufolge laden Eltern ihre Stimmen hoch, indem sie das Drehbuch sozusagen etwa 15 Minuten lang lesen. Dies unterscheidet sich jedoch deutlich von der Amazon-Demo darin, dass der Produktbesitzer sich dafür entscheidet, seinen eigenen Gesang bereitzustellen, anstatt das Produkt mit der Stimme von jemandem zu versehen, der wahrscheinlich nicht seine Erlaubnis geben kann.

Abgesehen von der Sorge, dass Deepfakes für Betrug, Raubüberfälle und andere schändliche Aktivitäten verwendet werden könnten, gibt es bereits einige beunruhigende Dinge darüber, wie Amazon diese Funktion aufbaut, für die es noch nicht einmal ein Veröffentlichungsdatum gibt.

Bevor er die Demo zeigte, sprach Prasad darüber, wie Alexa den Benutzern eine „kameradschaftliche Beziehung“ ermöglicht.

„In dieser Kameradschaftsrolle sind die menschlichen Qualitäten Empathie und Affekt der Schlüssel zum Aufbau von Vertrauen“, sagte der CEO. „Diese Eigenschaften sind während der anhaltenden Pandemie, in der viele von uns jemanden verloren haben, den wir lieben, noch wichtiger geworden. Auch wenn die KI diesen Verlustschmerz nicht beseitigen kann, kann sie ihr Gedächtnis auf jeden Fall erweitern.“

Prasad fügte hinzu, dass die Funktion „eine dauerhafte persönliche Beziehung schafft“.

Es ist wahr, dass unzählige Menschen als Reaktion auf den emotionalen Stress, der durch die COVID-19-Pandemie verursacht wird, ernsthaft nach menschlicher „Empathie und Zuneigung“ suchen. Der Sprachassistent mit künstlicher Intelligenz von Amazon ist jedoch nicht in der Lage, diese menschlichen Bedürfnisse zu erfüllen. Alexa kann auch keine „langfristigen persönlichen Beziehungen“ zu Menschen herstellen, die nicht mehr bei uns sind.

Es ist nicht schwer zu glauben, dass hinter dieser Weiterentwicklung gute Absichten stecken und dass es ein großer Trost sein kann, die Stimme der Person zu hören, die man vermisst. Theoretisch könnten wir mit so einem Feature sogar Spaß haben. Es ist harmlos, Alexa dazu zu bringen, einen Freund so klingen zu lassen, als hätte er etwas Dummes gesagt. Und wie bereits erwähnt, gibt es andere Unternehmen, die Deepfake-Technologie auf ähnliche Weise nutzen wie Amazon.

Aber die sich weiterentwickelnden Fähigkeiten von Alexa als eine Möglichkeit darzustellen, wieder mit verstorbenen Familienmitgliedern in Kontakt zu treten, ist ein riesiger, unrealistischer und problematischer Schritt. In der Zwischenzeit scheint es zwecklos zu sein, die Saiten des Herzens zu berühren, was zu Kummer und Einsamkeit im Zusammenhang mit der Pandemie führt. Es gibt Orte, an die Amazon nicht gehört, und Trauerberatung ist einer davon.

Schreibe einen Kommentar