Generative KI ist cool, aber vergessen wir nicht ihre menschlichen und ökologischen Kosten.

In den letzten Monaten verzeichnete der Bereich der künstlichen Intelligenz ein rasantes Wachstum, wobei eine Welle nach der anderen neue Modelle wie Dall-E und GPT-4 auf den Markt kamen. Jede Woche werden spannende neue Modelle, Produkte und Werkzeuge versprochen. Es ist leicht, sich von Hype-Wellen mitreißen zu lassen, aber diese großartigen Möglichkeiten haben ihren Preis für die Gesellschaft und den Planeten.

Zu den Nachteilen gehören die Umweltkosten für den Abbau seltener Mineralien, die menschlichen Kosten für den zeitaufwändigen Datenannotationsprozess und die wachsenden finanziellen Investitionen, die für das Training von KI-Modellen erforderlich sind, da diese mehr Parameter umfassen.

Werfen wir einen Blick auf die Innovationen, die zu den neuesten Generationen dieser Modelle geführt und die damit verbundenen Kosten in die Höhe getrieben haben.

Große Modelle

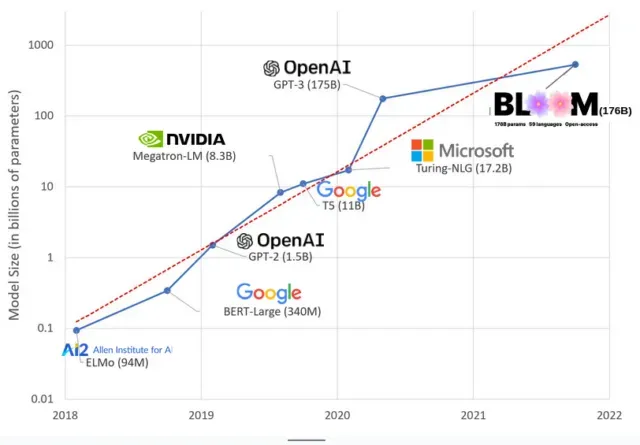

KI-Modelle sind in den letzten Jahren immer größer geworden, und Forscher messen ihre Größe mittlerweile anhand von Hunderten Milliarden Parametern. „Parameter“ sind interne Beziehungen, die in Modellen verwendet werden, um Muster basierend auf Trainingsdaten zu lernen.

Für große Sprachmodelle (LLMs) wie ChatGPT haben wir dank des PaLM-Modells von Google die Anzahl der Parameter von 100 Millionen im Jahr 2018 auf 500 Milliarden im Jahr 2023 erhöht. Die Theorie hinter diesem Wachstum besagt, dass Modelle mit mehr Parametern auch bei Aufgaben, für die sie ursprünglich nicht trainiert wurden, eine bessere Leistung erbringen sollten, obwohl diese Hypothese noch unbewiesen ist .

Das Training großer Modelle dauert in der Regel länger, was bedeutet, dass sie auch mehr GPUs benötigen, was mehr Geld kostet, sodass nur wenige Organisationen sie trainieren können. Die Kosten für das Training von GPT-3, das über 175 Milliarden Parameter verfügt, werden auf 4,6 Millionen US-Dollar geschätzt, was für die meisten Unternehmen und Organisationen unerschwinglich ist. (Es ist erwähnenswert, dass die Kosten für das Training von Modellen in einigen Fällen reduziert werden , beispielsweise im Fall von LLaMA, einem kürzlich von Meta trainierten Modell.)

Dies führt zu einer digitalen Kluft in der KI-Community zwischen denen, die die modernsten LLMs unterrichten können (hauptsächlich große Technologieunternehmen und wohlhabende Institutionen im globalen Norden) und denen, die das nicht können (gemeinnützige Organisationen, Start-ups). , und jeder, der keinen Zugang zu einem Supercomputer hat). oder Millionen in Cloud-Credits). Der Bau und Einsatz dieser Giganten erfordert eine Menge planetarischer Ressourcen: seltene Metalle zur Herstellung von GPUs, Wasser zum Kühlen riesiger Rechenzentren, Energie, um diese Rechenzentren rund um die Uhr auf globaler Ebene in Betrieb zu halten … all das wird oft übersehen, um sich darauf zu konzentrieren Aufmerksamkeit. über das zukünftige Potenzial der resultierenden Modelle.

Planeteneinflüsse

Eine Studie der Carnegie Mellon University-Professorin Emma Strubell zum CO2-Fußabdruck der LLM-Ausbildung ergab, dass das Training eines 2019er Modells namens BERT, das nur 213 Millionen Parameter hat, 280 Tonnen CO2-Emissionen ausstößt, was ungefähr dem Äquivalent von fünf Autos entspricht. Leben. Seitdem sind die Modelle gewachsen und die Ausrüstung effizienter geworden. Wo stehen wir also jetzt?

In einer aktuellen wissenschaftlichen Arbeit, die ich geschrieben habe, um die CO2-Emissionen zu untersuchen, die durch das Training von BLOOM, einem Sprachmodell mit 176 Milliarden Parametern, verursacht werden, haben wir den Energieverbrauch und die daraus resultierenden CO2-Emissionen mehrerer LLMs verglichen, die alle in den letzten Jahren herausgekommen sind. Der Zweck des Vergleichs bestand darin, eine Vorstellung vom Ausmaß der LLM-Emissionen unterschiedlicher Größe und deren Einfluss zu bekommen.

Schreibe einen Kommentar