Microsoft explica el extraño comportamiento de su chatbot en Bing

Microsoft se explica para justificar el comportamiento a veces extraño del chatbot de Bing. La razón de esto, según el equipo responsable, son las largas sesiones de intercambio con AI.

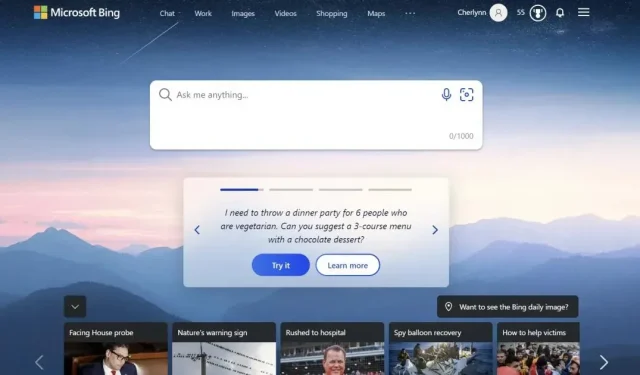

La semana pasada, Microsoft lanzó su chatbot basado en IA para Bing en su navegador Edge, que ha estado en las noticias desde entonces. Pero no siempre por las razones correctas . Las primeras impresiones fueron buenas, muy buenas, pero los usuarios empezaron a notar que el bot de Bing daba información incorrecta, regañaba a los usuarios por perder el tiempo e incluso mostraba un comportamiento bastante “desequilibrado”. En una extraña conversación, se negó a publicar las cintas de Avatar 2: Waterway, insistiendo en que la película aún no se ha estrenado porque todavía estamos en 2022. El bot incluso llamó al usuario «poco inteligente y terco», por cierto, cuando trató de decirle a Bing que estaba equivocado.

Microsoft se explica para justificar el comportamiento a veces extraño del chatbot de Bing

Microsoft publicó una publicación de blog hoy que explica lo que sucedió y cómo está lidiando con estos problemas. Primero, la compañía con sede en Redmond admitió que no planeaba usar la IA de Bing para «descubrir el mundo en general y entretenimiento social».

Estas “largas sesiones de chat de 15 o más preguntas” pueden hacer que el sistema se caiga. “Bing puede ser repetitivo o rápido/empujador para brindar respuestas que no son necesariamente útiles o están en línea con el tono que queremos”, explica la compañía. Aparentemente, esto se debe a que el bot puede «olvidar» una pregunta tras otra que originalmente estaba tratando de responder. Para solucionar esto, Microsoft puede agregar una herramienta para restablecer el contexto de búsqueda o comenzar desde cero.

Otro tema es más complejo e interesante: “El modelo a veces intenta responder o pensar en el mismo tono en que se le hicieron las preguntas, lo que a veces puede conducir a un estilo no deseado”, escribe Microsoft. Esto requiere mucha interacción, pero los ingenieros creen que pueden solucionarlo dando a los usuarios más control.

La razón de esto, según el equipo responsable, son las largas sesiones de intercambio con AI.

A pesar de estas preocupaciones, los evaluadores generalmente están muy satisfechos con los resultados de búsqueda de IA de Bing, según Microsoft. Sin embargo, es posible obtener mejores resultados con «datos muy limitados en el tiempo, como los resultados deportivos en tiempo real». El gigante estadounidense también busca mejorar las respuestas objetivas, por ejemplo, para los estados financieros al multiplicar los datos por un factor de cuatro. . Finalmente, la compañía también «agregará un botón para darle más control para fomentar la precisión o la creatividad en la respuesta, según su solicitud».

Bing Support quisiera agradecer a los usuarios por todas las pruebas que han realizado, que «ayudan a mejorar el producto para todos». Al mismo tiempo, los ingenieros dicen que están sorprendidos de que los usuarios se queden hasta dos horas para interactuar con el robot. Sin duda, los internautas tendrán que probar cada nueva iteración del chatbot todo el día, todo puede resultar muy interesante.

El subreddit de Bing tiene bastantes ejemplos de cómo el nuevo chat de Bing se sale de control.

¡Abrir el chat en la búsqueda ahora podría ser una mala idea!

Tomado aquí como un recordatorio de que hubo un tiempo en que un importante motor de búsqueda mostró esto en sus resultados. pic.twitter.com/LiE2HJCV2z

— Vlad (@vladquant) 13 de febrero de 2023

Deja una respuesta