La actualización de ChatGPT permite a su IA «ver, oír y hablar», según OpenAI

El lunes, OpenAI anunció una actualización importante de ChatGPT que permite a sus modelos de IA GPT-3.5 y GPT-4 analizar imágenes y reaccionar ante ellas como parte de una conversación de texto. Además, la aplicación móvil ChatGPT agregará opciones de síntesis de voz que, cuando se combinen con sus funciones de reconocimiento de voz existentes, permitirán conversaciones totalmente verbales con el asistente de IA, dice OpenAI.

OpenAI planea implementar estas funciones en ChatGPT para suscriptores Plus y Enterprise «durante las próximas dos semanas». También señala que la síntesis de voz llegará solo a iOS y Android, y el reconocimiento de imágenes estará disponible tanto en la interfaz web como en la plataforma. aplicaciones móviles.

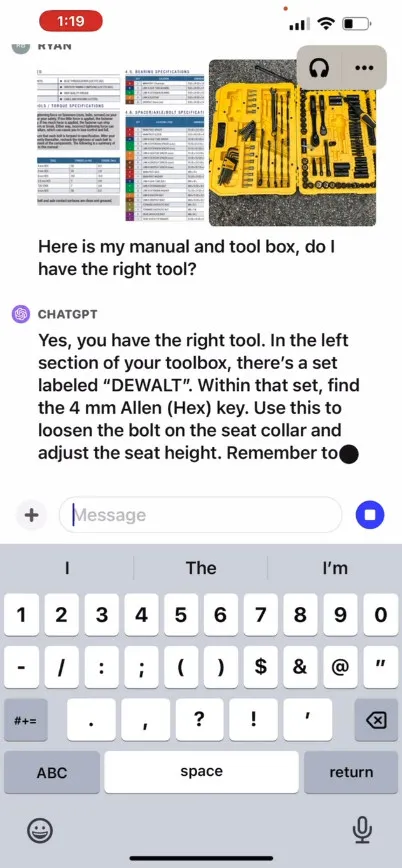

OpenAI dice que la nueva función de reconocimiento de imágenes en ChatGPT permite a los usuarios cargar una o más imágenes para conversar, utilizando los modelos GPT-3.5 o GPT-4. En su publicación de blog promocional , la compañía afirma que la función se puede utilizar para una variedad de aplicaciones cotidianas: desde averiguar qué hay para cenar tomando fotografías del refrigerador y la despensa, hasta solucionar problemas por qué la parrilla no arranca. También dice que los usuarios pueden usar la pantalla táctil de su dispositivo para rodear partes de la imagen en las que les gustaría que ChatGPT se concentrara.

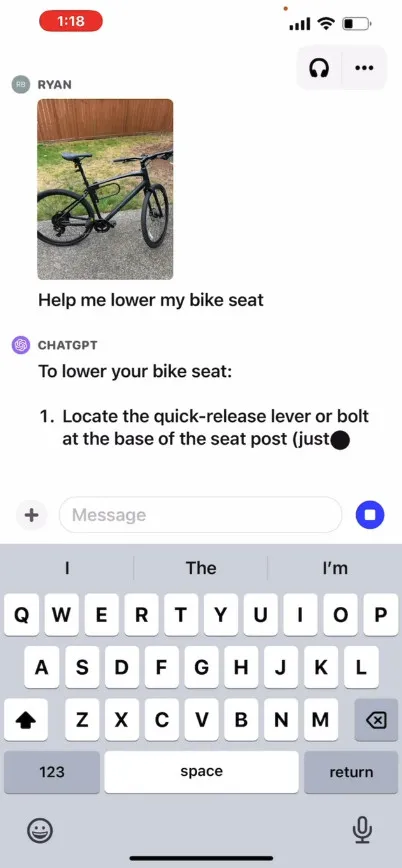

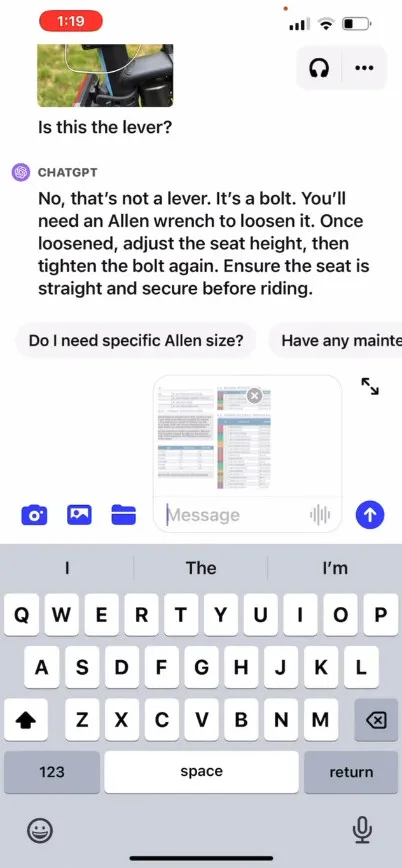

En su sitio, OpenAI ofrece un vídeo promocional que ilustra un intercambio hipotético con ChatGPT donde un usuario pregunta cómo levantar el asiento de una bicicleta, proporcionando fotografías, así como un manual de instrucciones y una imagen de la caja de herramientas del usuario. ChatGPT reacciona y aconseja al usuario cómo completar el proceso. No hemos probado esta característica nosotros mismos, por lo que se desconoce su efectividad en el mundo real.

¿Entonces, cómo funciona? OpenAI no ha publicado detalles técnicos sobre cómo funcionan internamente GPT-4 o su versión multimodal, GPT-4V , pero según investigaciones de inteligencia artificial conocidas de otros (incluido el socio de OpenAI, Microsoft ), los modelos de inteligencia artificial multimodal generalmente transforman texto e imágenes en un espacio de codificación compartido, que les permite procesar varios tipos de datos a través de la misma red neuronal. OpenAI puede usar CLIP para cerrar la brecha entre datos visuales y de texto de una manera que alinee las representaciones de imágenes y texto en el mismo espacio latente , una especie de red vectorizada de relaciones de datos. Esa técnica podría permitir a ChatGPT hacer deducciones contextuales a través de texto e imágenes, aunque esto es especulativo de nuestra parte.

Mientras tanto, en el terreno del audio, la nueva función de síntesis de voz de ChatGPT permite una conversación hablada de ida y vuelta con ChatGPT, impulsada por lo que OpenAI llama un «nuevo modelo de texto a voz», aunque el texto a voz se ha resuelto por un tiempo. largo tiempo. Una vez que se implementa la función, la compañía dice que los usuarios pueden activarla al optar por conversaciones de voz en la configuración de la aplicación y luego seleccionar entre cinco voces sintéticas diferentes con nombres como «Juniper», «Sky», «Cove», «Ember». ”y “Breeze”. OpenAI dice que estas voces han sido creadas en colaboración con actores de doblaje profesionales.

Whisper de OpenAI, un sistema de reconocimiento de voz de código abierto que cubrimos en septiembre del año pasado, continuará manejando la transcripción de la entrada de voz del usuario. Whisper se ha integrado con la aplicación ChatGPT para iOS desde su lanzamiento en mayo. OpenAI lanzó la aplicación ChatGPT para Android con capacidades similares en julio.

Deja una respuesta