Alexa falsificará las voces de los vivos y los muertos en el desarrollo de funciones

Amazon está descubriendo cómo hacer que el asistente de voz de Alexa simule profundamente la voz de cualquier persona, viva o muerta, con solo una breve grabación. La compañía presentó la función en su conferencia re:Mars en Las Vegas el miércoles, utilizando el trauma emocional de la pandemia en curso y el dolor para generar interés.

Re:Mars de Amazon se centra en la inteligencia artificial, el aprendizaje automático, la robótica y otras tecnologías emergentes, con expertos en tecnología y líderes de la industria en el escenario. Durante el discurso de apertura del segundo día, Rohit Prasad, vicepresidente sénior y científico jefe de Alexa AI en Amazon, mostró una función que se está desarrollando actualmente para Alexa.

En la demostración, un niño le pregunta a Alexa: «¿Puede la abuela terminar de leerme El mago de Oz?». Alexa responde: «Está bien», con su típica voz robótica afeminada. Pero luego se escucha la voz de la abuela del niño del hablante, que está leyendo un cuento de hadas de L. Frank Baum.

Puedes ver una demostración a continuación:

Prasad solo dijo que Amazon está «trabajando» en la capacidad de Alexa, y no dio más detalles sobre qué trabajo queda y cuándo o si estará disponible.

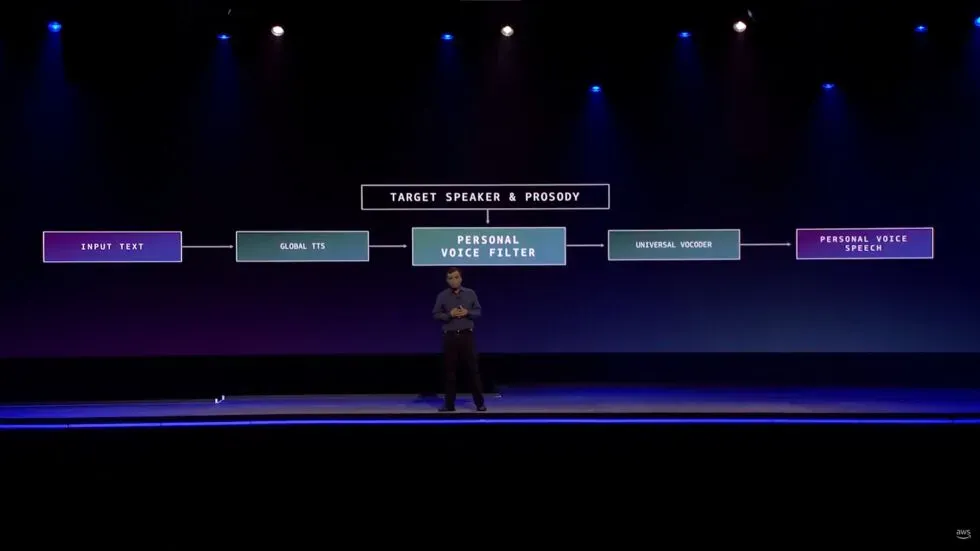

Sin embargo, proporcionó los detalles técnicos más pequeños.

“Requirió inventiva cuando tuvimos que aprender a reproducir voz de alta calidad en menos de un minuto de grabación en comparación con las horas de grabación en el estudio”, dijo. “Lo hicimos posible al enmarcar el problema como un problema de conversión de voz en lugar de un problema de generación de voz”.

Por supuesto, los deepfakes de todo tipo generalmente tienen una reputación mixta. Sin embargo, se han hecho algunos intentos de utilizar la tecnología como una herramienta en lugar de un vehículo para la espeluznante.

Las falsificaciones de audio, en particular, como señala The Verge, se han utilizado en los medios de comunicación para compensar cuando, por ejemplo, un podcaster se equivocó en una línea o cuando la estrella de un proyecto murió repentinamente, como sucedió con el documental Roadrunner de Anthony Bourdain .

La publicación señala que incluso hay casos de personas que usan IA para crear chatbots que se comunican como si fueran seres queridos perdidos.

Alexa ni siquiera será el primer producto de consumo en usar audio falso para reemplazar a un miembro de la familia que no puede estar presente en persona. El altavoz inteligente Takara Tomy , como señala Gi z modo , utiliza inteligencia artificial para leer cuentos a los niños antes de dormir con la voz de un padre. Se informa que los padres suben sus voces leyendo el guión durante unos 15 minutos, por así decirlo. Aunque esto difiere notablemente de la demostración de Amazon en que el propietario del producto elige proporcionar su propia voz en lugar de que el producto use la voz de alguien que probablemente no pueda dar su permiso.

Además de las preocupaciones sobre el uso de deepfakes para estafas, robos y otras actividades nefastas, ya hay algunas cosas inquietantes sobre cómo Amazon está construyendo esta función, que aún no tiene una fecha de lanzamiento.

Antes de mostrar la demostración, Prasad habló sobre cómo Alexa brinda a los usuarios una «relación de camaradería».

“En este rol de camaradería, las cualidades humanas de empatía y afecto son clave para generar confianza”, dijo el CEO. “Estos atributos se han vuelto aún más importantes durante la pandemia en curso, cuando muchos de nosotros hemos perdido a alguien que amamos. Si bien la IA no puede eliminar este dolor de pérdida, definitivamente puede extender su memoria”.

Prasad agregó que la función «brinda una relación personal duradera».

Es cierto que innumerables personas están buscando seriamente “empatía y afecto” humano en respuesta al estrés emocional causado por la pandemia de COVID-19. Sin embargo, el asistente de voz de inteligencia artificial de Amazon no está a la altura de estas necesidades humanas. Alexa tampoco puede proporcionar «relaciones personales a largo plazo» con personas que ya no están con nosotros.

No es difícil creer que hay buenas intenciones detrás de esta función en evolución y que escuchar la voz de la persona que extrañas puede ser un gran consuelo. Teóricamente, incluso podríamos divertirnos con esa función. Hacer que Alexa haga que un amigo suene como si dijera algo estúpido es inofensivo. Y, como dijimos anteriormente, hay otras empresas que utilizan tecnología deepfake de manera similar a lo que demostró Amazon.

Pero presentar la capacidad evolutiva de Alexa como una forma de reconectarse con familiares fallecidos es un salto gigante, poco realista y problemático. Mientras tanto, tocar las cuerdas del corazón, provocando el dolor y la soledad asociados a la pandemia, parece inútil. Hay lugares a los que Amazon no pertenece, y la consejería de duelo es uno de ellos.

Deja una respuesta