China sigue comprando tarjetas Nvidia dañadas para entrenar sus modelos de IA

Estados Unidos actuó agresivamente el año pasado para limitar la capacidad de China para desarrollar inteligencia artificial con fines militares, bloqueando la venta allí de los chips estadounidenses más avanzados utilizados para entrenar sistemas de IA.

Los grandes avances en los chips utilizados para desarrollar la IA generativa significaron que la última tecnología estadounidense a la venta en China es más poderosa que cualquier cosa disponible antes. Eso es a pesar del hecho de que los chips han sido manipulados deliberadamente para que el mercado chino limite sus capacidades, haciéndolos menos efectivos que los productos disponibles en otras partes del mundo.

El resultado ha sido un aumento vertiginoso de los pedidos chinos de los últimos procesadores estadounidenses avanzados. Las principales empresas de Internet de China han realizado pedidos de chips por valor de 5.000 millones de dólares a Nvidia, cuyas unidades de procesamiento gráfico se han convertido en el caballo de batalla para entrenar grandes modelos de IA.

Es probable que el impacto de la creciente demanda mundial de los productos de Nvidia respalde los resultados financieros del segundo trimestre del fabricante de chips que se anunciarán el miércoles.

Además de reflejar la demanda de chips mejorados para entrenar los últimos modelos de lenguaje grande de las empresas de Internet, la fiebre también ha sido provocada por la preocupación de que EE. UU. pueda endurecer aún más sus controles de exportación, haciendo que incluso estos productos limitados no estén disponibles en el futuro.

Sin embargo, Bill Dally, científico jefe de Nvidia, sugirió que los controles de exportación de EE. UU. tendrían un mayor impacto en el futuro.

“A medida que los requisitos de capacitación [para los sistemas de IA más avanzados] continúan duplicándose cada seis a 12 meses”, la brecha entre los chips vendidos en China y los disponibles en el resto del mundo “crecerá rápidamente”, dijo.

Limitación de las velocidades de procesamiento

Los controles de exportación de chips de EE. UU. del año pasado fueron parte de un paquete que incluía evitar que los clientes chinos compraran el equipo necesario para fabricar chips avanzados.

Washington fijó un límite a la velocidad máxima de procesamiento de los chips que podrían venderse en China, así como a la velocidad a la que los chips pueden transferir datos, un factor crítico cuando se trata de entrenar grandes modelos de IA, un trabajo intensivo en datos que requiere conectando un gran número de chips juntos.

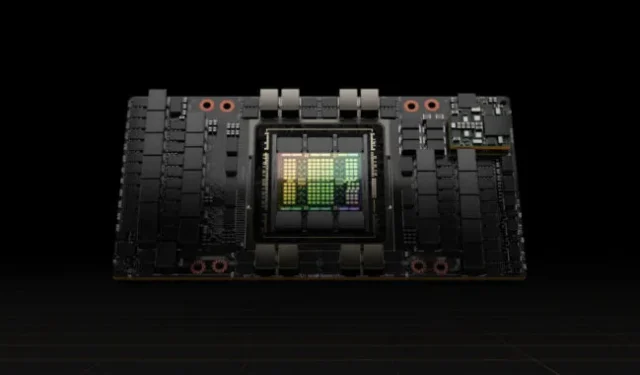

Nvidia respondió reduciendo la tasa de transferencia de datos en sus procesadores A100, en ese momento sus GPU de primera línea, creando un nuevo producto para China llamado A800 que cumplió con los controles de exportación.

Este año, siguió con los límites de transferencia de datos en su H100, un procesador nuevo y mucho más potente que fue especialmente diseñado para entrenar modelos de lenguaje grandes, creando una versión llamada H800 para el mercado chino.

El fabricante de chips no ha revelado las capacidades técnicas de los procesadores hechos para China, pero los fabricantes de computadoras han sido abiertos sobre los detalles. Lenovo, por ejemplo, anuncia servidores que contienen chips H800 que, según dice, son idénticos en todos los sentidos a los H100 vendidos en otras partes del mundo, excepto que tienen una tasa de transferencia de solo 400 gigabytes por segundo.

Eso está por debajo del límite de 600 GB/s que Estados Unidos ha establecido para las exportaciones de chips a China. En comparación, Nvidia ha dicho que su H100, que comenzó a enviar a los clientes a principios de este año, tiene una tasa de transferencia de 900 GB/s.

La tasa de transferencia más baja en China significa que los usuarios de los chips allí enfrentan tiempos de capacitación más prolongados para sus sistemas de inteligencia artificial que los clientes de Nvidia en otras partes del mundo, una limitación importante ya que los modelos han crecido en tamaño.

Los tiempos de entrenamiento más largos aumentan los costos, ya que los chips necesitarán consumir más energía, uno de los mayores gastos con los modelos grandes.

Sin embargo, incluso con estos límites, los chips H800 a la venta en China son más potentes que cualquier otro disponible en cualquier otro lugar antes de este año, lo que genera una gran demanda.

Los chips H800 son cinco veces más rápidos que los chips A100 que habían sido las GPU más potentes de Nvidia, según Patrick Moorhead, analista de chips estadounidense de Moor Insights & Strategy.

Eso significa que las empresas chinas de Internet que entrenaron sus modelos de IA utilizando chips de primera línea comprados antes de los controles de exportación de EE. UU. aún pueden esperar grandes mejoras al comprar los últimos semiconductores, dijo.

“Parece que el gobierno de EE. UU. quiere no cerrar el esfuerzo de IA de China, sino hacerlo más difícil”, dijo Moorhead.

Coste-beneficio

Muchas empresas tecnológicas chinas aún se encuentran en la etapa de preentrenamiento de modelos de lenguaje grande, lo que consume mucho rendimiento de los chips de GPU individuales y exige un alto grado de capacidad de transferencia de datos.

Solo los chips de Nvidia pueden proporcionar la eficiencia necesaria para el entrenamiento previo, dicen los ingenieros chinos de IA. El rendimiento de los chips individuales de la serie 800, a pesar de las velocidades de transferencia debilitadas, aún está por delante de otros en el mercado.

“Las GPU de Nvidia pueden parecer caras pero, de hecho, son la opción más rentable”, dijo un ingeniero de IA de una empresa china líder en Internet.

Otros proveedores de GPU cotizaron precios más bajos con un servicio más oportuno, dijo el ingeniero, pero la compañía consideró que los costos de capacitación y desarrollo se acumularían y que tendría la carga adicional de la incertidumbre.

La oferta de Nvidia incluye el ecosistema de software, con su plataforma informática Compute Unified Device Architecture, o Cuda, que creó en 2006 y que se ha convertido en parte de la infraestructura de IA.

Los analistas de la industria creen que las empresas chinas pronto podrían enfrentar limitaciones en la velocidad de las interconexiones entre los chips de la serie 800. Esto podría dificultar su capacidad para manejar la creciente cantidad de datos necesarios para el entrenamiento de IA, y se verán obstaculizados a medida que profundicen en la investigación y el desarrollo de grandes modelos de lenguaje.

Charlie Chai, analista de 86Research con sede en Shanghái, comparó la situación con la construcción de muchas fábricas con autopistas congestionadas entre ellas. Incluso las empresas que pueden acomodar los chips debilitados podrían enfrentar problemas en los próximos dos o tres años, agregó.

© 2023 The Financial Times Ltd. Todos los derechos reservados. No copie y pegue artículos de FT y redistribuya por correo electrónico o publique en la web.

Deja una respuesta