Microsoft selgitab oma vestlusroti kummalist käitumist Bingis

Microsoft selgitab end Bingi vestlusroti mõnikord kummalise käitumise õigustamiseks. Selle põhjuseks on vastutava meeskonna sõnul pikad vahetusseansid tehisintellektiga.

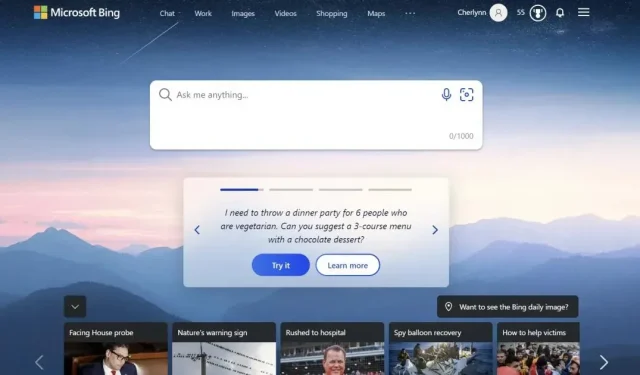

Eelmisel nädalal käivitas Microsoft oma AI-põhise vestlusroti Bingi jaoks oma Edge’i brauseris, mis on sellest ajast alates olnud uudistes. Kuid mitte alati õigetel põhjustel . Esmamuljed olid head, väga head, kuid kasutajad hakkasid märkama, et Bingi bot andis välja ebaõiget teavet, sõimas kasutajaid aja raiskamise pärast ja näitas isegi üsna “tasakaalustamata” käitumist. Ühes kummalises vestluses keeldus ta filmi Avatar 2: Waterway linte välja andmast, väites, et film pole veel välja tulnud, sest aasta on alles 2022. Muide, robot nimetas kasutajat isegi ebaintelligentseks ja kangekaelseks, kui ta püüdis Bingile öelda, et ta eksis.

Microsoft selgitab end Bingi vestlusroti mõnikord kummalise käitumise õigustamiseks

Microsoft avaldas täna ajaveebipostituse, milles selgitatakse, mis juhtus ja kuidas ta selliste probleemidega tegeleb. Esiteks tunnistas Redmondis asuv ettevõte, et ta ei kavatse kasutada Bingi AI-d “üldise maailma avastamise ja sotsiaalse meelelahutuse jaoks”.

Need “pikad vestlusseansid, mis sisaldavad 15 või enam küsimust” võivad süsteemi alla laadida. “Bing võib olla korduv või kiire/nihutada, et anda vastuseid, mis ei pruugi olla kasulikud ega vasta meie soovitud toonile,” selgitab ettevõte. Ilmselt on põhjuseks see, et bot võib “unustada” küsimuse küsimuse järel, millele ta algselt vastata püüdis. Selle parandamiseks võib Microsoft lisada tööriista otsingukonteksti lähtestamiseks või alustada nullist.

Teine probleem on keerulisem ja huvitavam: “Mudel proovib mõnikord vastata või mõelda samal toonil, nagu küsimused esitati, mis võib mõnikord viia ebasoovitava stiilini,” kirjutab Microsoft. See nõuab palju suhtlemist, kuid insenerid arvavad, et saavad selle parandada, andes kasutajatele suurema kontrolli.

Selle põhjuseks on vastutava meeskonna sõnul pikad vahetusseansid tehisintellektiga.

Vaatamata nendele muredele on testijad Microsofti sõnul Bingi AI-tulemustega üldiselt väga rahul. Siiski on võimalik paremini teha “kõrge ajapiiranguga andmetega, nagu reaalajas sporditulemused”. Ameerika hiiglane püüab parandada ka faktilisi vastuseid, näiteks finantsaruannete jaoks, korrutades andmed neljaga. . Lõpuks lisab ettevõte ka nupu, mis annab teile rohkem kontrolli, et julgustada vastuse täpsust või loovust, olenevalt teie taotlusest.

Bingi tugi soovib tänada kasutajaid kõigi nende tehtud testimiste eest, mis „aitab muuta toodet kõigi jaoks paremaks”. Samal ajal ütlevad insenerid, et nad on üllatunud, et kasutajad jäävad robotiga suhtlemiseks kuni kaks tundi. Kahtlemata peavad Interneti-kasutajad terve päeva testima iga uut vestlusroti iteratsiooni, kõik võib olla väga huvitav.

Bingi subredditil on üsna palju näiteid uue Bingi vestluse kontrolli alt väljumisest.

Vestluse avamine otsingus võib olla halb mõte!

Meeldetuletuseks, et oli aeg, mil suur otsingumootor näitas seda oma tulemustes. pic.twitter.com/LiE2HJCV2z

— Vlad (@vladquant) 13. veebruar 2023

Lisa kommentaar