La Chine continue d’acheter des cartes Nvidia entravées pour former ses modèles d’IA

Les États-Unis ont agi de manière agressive l’année dernière pour limiter la capacité de la Chine à développer l’intelligence artificielle à des fins militaires, bloquant la vente là-bas des puces américaines les plus avancées utilisées pour entraîner les systèmes d’IA.

De grandes avancées dans les puces utilisées pour développer l’IA générative signifient que la dernière technologie américaine en vente en Chine est plus puissante que tout ce qui était disponible auparavant. Et ce malgré le fait que les puces ont été délibérément entravées pour le marché chinois afin de limiter leurs capacités, les rendant moins efficaces que les produits disponibles ailleurs dans le monde.

Le résultat a été une montée en flèche des commandes chinoises pour les derniers processeurs américains avancés. Les principales sociétés Internet chinoises ont passé des commandes pour 5 milliards de dollars de puces à Nvidia, dont les unités de traitement graphique sont devenues la bête de somme pour la formation de grands modèles d’IA.

L’impact de la montée en flèche de la demande mondiale pour les produits Nvidia devrait étayer les résultats financiers du deuxième trimestre du fabricant de puces qui doivent être annoncés mercredi.

En plus de refléter la demande de puces améliorées pour former les derniers grands modèles linguistiques des sociétés Internet, la ruée a également été provoquée par la crainte que les États-Unis ne resserrent davantage leurs contrôles à l’exportation, rendant même ces produits limités indisponibles à l’avenir.

Cependant, Bill Dally, scientifique en chef de Nvidia, a suggéré que les contrôles des exportations américaines auraient un plus grand impact à l’avenir.

« Alors que les besoins en formation [pour les systèmes d’IA les plus avancés] continuent de doubler tous les six à 12 mois », l’écart entre les puces vendues en Chine et celles disponibles dans le reste du monde « va augmenter rapidement », a-t-il déclaré.

Limitation des vitesses de traitement

Les contrôles américains des exportations de puces de l’année dernière faisaient partie d’un ensemble qui empêchait les clients chinois d’acheter l’équipement nécessaire à la fabrication de puces avancées.

Washington a fixé un plafond à la vitesse de traitement maximale des puces pouvant être vendues en Chine, ainsi qu’à la vitesse à laquelle les puces peuvent transférer des données – un facteur critique lorsqu’il s’agit de former de grands modèles d’IA, un travail gourmand en données qui nécessite connecter un grand nombre de puces ensemble.

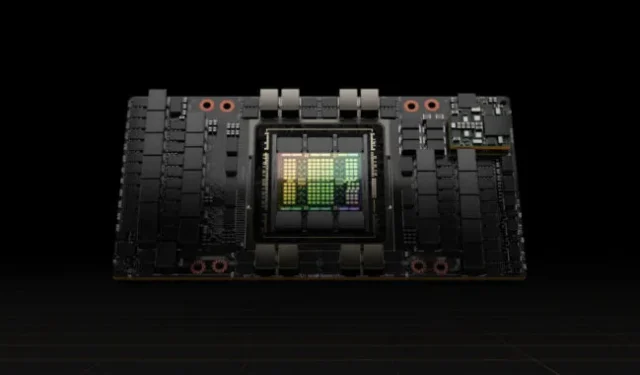

Nvidia a répondu en réduisant le taux de transfert de données sur ses processeurs A100, à l’époque ses GPU haut de gamme, créant un nouveau produit pour la Chine appelé A800 qui satisfaisait les contrôles à l’exportation.

Cette année, il a suivi avec des limites de transfert de données sur son H100, un nouveau processeur beaucoup plus puissant spécialement conçu pour entraîner de grands modèles de langage, créant une version appelée H800 pour le marché chinois.

Le fabricant de puces n’a pas divulgué les capacités techniques des processeurs fabriqués pour la Chine, mais les fabricants d’ordinateurs ont été ouverts sur les détails. Lenovo, par exemple, annonce des serveurs contenant des puces H800 qui, selon lui, sont identiques en tout point aux H100 vendus ailleurs dans le monde, sauf qu’ils ont un taux de transfert de seulement 400 gigaoctets par seconde.

C’est en dessous de la limite de 600 Go/s que les États-Unis ont fixée pour les exportations de puces vers la Chine. En comparaison, Nvidia a déclaré que son H100, qu’il a commencé à expédier aux clients plus tôt cette année, a un taux de transfert de 900 Go/s.

Le taux de transfert plus faible en Chine signifie que les utilisateurs des puces y sont confrontés à des temps de formation plus longs pour leurs systèmes d’IA que les clients de Nvidia ailleurs dans le monde, une limitation importante car les modèles ont pris de l’ampleur.

Les temps de formation plus longs augmentent les coûts car les puces devront consommer plus d’énergie, l’une des dépenses les plus importantes avec les grands modèles.

Cependant, même avec ces limites, les puces H800 en vente en Chine sont plus puissantes que tout ce qui était disponible ailleurs avant cette année, ce qui entraîne une énorme demande.

Les puces H800 sont cinq fois plus rapides que les puces A100 qui étaient les GPU les plus puissants de Nvidia, selon Patrick Moorhead, analyste de puces américain chez Moor Insights & Strategy.

Cela signifie que les sociétés Internet chinoises qui ont formé leurs modèles d’IA à l’aide de puces haut de gamme achetées avant les contrôles américains à l’exportation peuvent toujours s’attendre à de grandes améliorations en achetant les derniers semi-conducteurs, a-t-il déclaré.

« Il semble que le gouvernement américain ne veuille pas arrêter l’effort d’IA de la Chine, mais le rendre plus difficile », a déclaré Moorhead.

Coût-bénéfice

De nombreuses entreprises technologiques chinoises en sont encore au stade de la pré-formation de grands modèles de langage, ce qui consomme beaucoup de performances des puces GPU individuelles et exige un degré élevé de capacité de transfert de données.

Seules les puces de Nvidia peuvent fournir l’efficacité nécessaire à la pré-formation, affirment les ingénieurs chinois en intelligence artificielle. Les performances des puces individuelles de la série 800, malgré les vitesses de transfert affaiblies, sont toujours en avance sur les autres sur le marché.

« Les GPU de Nvidia peuvent sembler chers mais sont, en fait, l’option la plus rentable », a déclaré un ingénieur en intelligence artificielle d’une grande société Internet chinoise.

D’autres fournisseurs de GPU ont proposé des prix plus bas avec un service plus rapide, a déclaré l’ingénieur, mais la société a estimé que les coûts de formation et de développement augmenteraient et qu’elle aurait le fardeau supplémentaire de l’incertitude.

L’offre de Nvidia comprend l’écosystème logiciel, avec sa plate-forme informatique Compute Unified Device Architecture, ou Cuda, qu’elle a mis en place en 2006 et qui est devenue partie intégrante de l’infrastructure d’IA.

Les analystes du secteur estiment que les entreprises chinoises pourraient bientôt être confrontées à des limitations de la vitesse des interconnexions entre les puces de la série 800. Cela pourrait entraver leur capacité à gérer la quantité croissante de données requises pour la formation à l’IA, et ils seront gênés à mesure qu’ils approfondiront la recherche et le développement de grands modèles de langage.

Charlie Chai, un analyste basé à Shanghai chez 86Research, a comparé la situation avec la construction de nombreuses usines avec des autoroutes encombrées entre elles. Même les entreprises qui peuvent accueillir les puces affaiblies pourraient rencontrer des problèmes dans les deux ou trois prochaines années, a-t-il ajouté.

© 2023 Financial Times Ltd. Tous droits réservés. Veuillez ne pas copier et coller les articles de FT et les redistribuer par e-mail ou par la poste sur le Web.

Laisser un commentaire