Secondo OpenAI, l’aggiornamento ChatGPT consente alla sua intelligenza artificiale di “vedere, ascoltare e parlare”.

Lunedì, OpenAI ha annunciato un aggiornamento significativo a ChatGPT che consente ai suoi modelli AI GPT-3.5 e GPT-4 di analizzare le immagini e reagire ad esse come parte di una conversazione testuale. Inoltre, l’app mobile ChatGPT aggiungerà opzioni di sintesi vocale che, se abbinate alle funzionalità di riconoscimento vocale esistenti, consentiranno conversazioni completamente verbali con l’assistente AI, afferma OpenAI.

OpenAI prevede di implementare queste funzionalità in ChatGPT per gli abbonati Plus ed Enterprise “nelle prossime due settimane”. Si nota inoltre che la sintesi vocale arriverà solo su iOS e Android e il riconoscimento delle immagini sarà disponibile sia sull’interfaccia web che sul sito. app mobili.

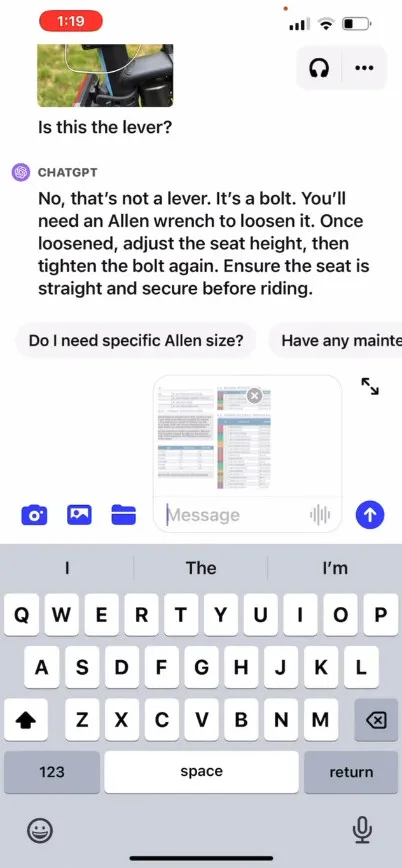

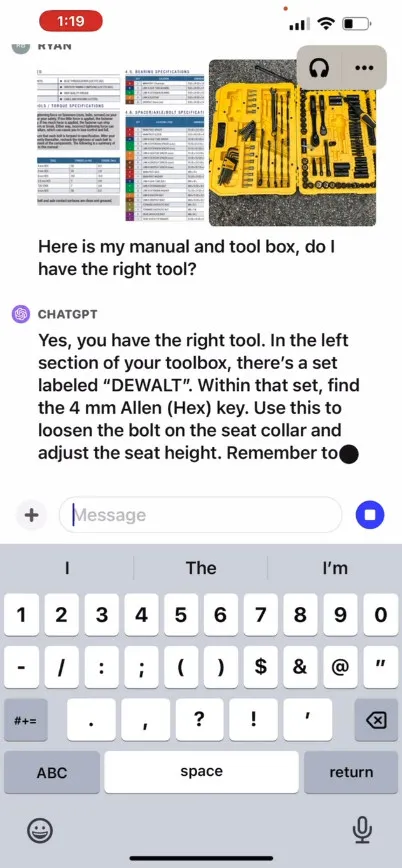

OpenAI afferma che la nuova funzionalità di riconoscimento delle immagini in ChatGPT consente agli utenti di caricare una o più immagini per la conversazione, utilizzando i modelli GPT-3.5 o GPT-4. Nel suo post promozionale sul blog , l’azienda afferma che la funzione può essere utilizzata per una varietà di applicazioni quotidiane: dal capire cosa c’è per cena scattando foto del frigorifero e della dispensa, alla risoluzione dei problemi relativi al motivo per cui la griglia non si avvia. Dice anche che gli utenti possono utilizzare il touch screen del proprio dispositivo per circondare le parti dell’immagine su cui desiderano che ChatGPT si concentri.

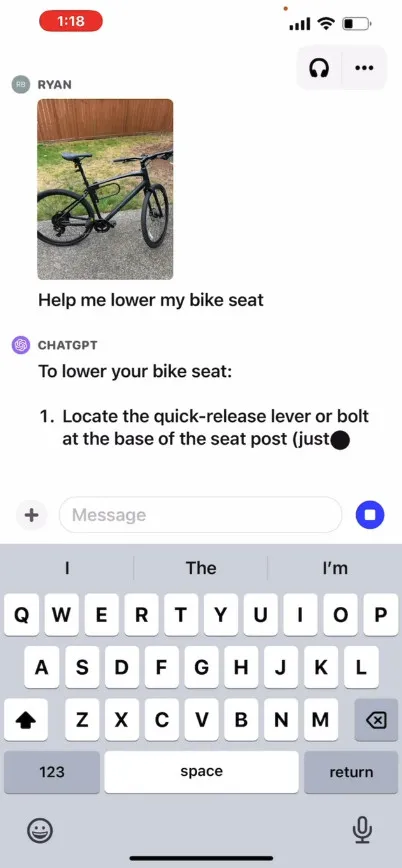

Sul proprio sito OpenAI mette a disposizione un video promozionale che illustra un ipotetico scambio con ChatGPT in cui un utente chiede come alzare il seggiolino di una bicicletta, fornendo foto oltre a un manuale di istruzioni e un’immagine della cassetta degli attrezzi dell’utente. ChatGPT reagisce e consiglia all’utente come completare il processo. Non abbiamo testato personalmente questa funzionalità, quindi la sua efficacia nel mondo reale non è nota.

Quindi, come funziona? OpenAI non ha rilasciato dettagli tecnici su come GPT-4 o la sua versione multimodale, GPT-4V , funzionano dietro le quinte, ma sulla base di ricerche sull’intelligenza artificiale note di altri (incluso il partner OpenAI Microsoft ), i modelli di intelligenza artificiale multimodale in genere trasformano testo e immagini in un spazio di codifica condiviso, che consente loro di elaborare vari tipi di dati attraverso la stessa rete neurale. OpenAI può utilizzare CLIP per colmare il divario tra dati visivi e testuali in modo da allineare le rappresentazioni di immagini e testo nello stesso spazio latente , una sorta di rete vettorizzata di relazioni di dati. Questa tecnica potrebbe consentire a ChatGPT di effettuare deduzioni contestuali su testo e immagini, anche se da parte nostra si tratta di una speculazione.

Nel frattempo, nel campo dell’audio, la nuova funzionalità di sintesi vocale di ChatGPT consente, secondo quanto riferito, conversazioni vocali avanti e indietro con ChatGPT, guidate da quello che OpenAI chiama un “nuovo modello di sintesi vocale”, sebbene la sintesi vocale sia stata risolta per un po’. a lungo. Una volta lanciata la funzionalità, l’azienda afferma che gli utenti potranno attivarla attivando le conversazioni vocali nelle impostazioni dell’app e quindi selezionando tra cinque diverse voci sintetiche con nomi come “Juniper”, “Sky”, “Cove”, “Ember”. “E” Breeze “. OpenAI afferma che queste voci sono state realizzate in collaborazione con doppiatori professionisti.

Whisper di OpenAI, un sistema di riconoscimento vocale open source di cui abbiamo parlato nel settembre dello scorso anno, continuerà a gestire la trascrizione dell’input vocale dell’utente. Whisper è stato integrato con l’ app iOS ChatGPT da quando è stato lanciato a maggio. OpenAI ha rilasciato l’ app Android ChatGPT con funzionalità simili a luglio.

Lascia un commento