Ho abbandonato OpenLiteSpeed e sono tornato al buon vecchio Nginx

Dal 2017, nel tempo libero che ho (ah!), aiuto il mio collega Eric Berger a ospitare il suo sito di previsioni meteorologiche nell’area di Houston, Space City Weather . Si tratta di una sfida di hosting interessante: in una giornata tipica, SCW esegue circa 20.000-30.000 visualizzazioni di pagina per 10.000-15.000 visitatori unici, un carico relativamente facile da gestire con un lavoro minimo. Ma quando si verificano eventi meteorologici gravi, soprattutto in estate, quando gli uragani si annidano nel Golfo del Messico, il traffico del sito può raggiungere oltre un milione di pagine visualizzate in 12 ore. Questo livello di traffico richiede un po’ più di preparazione per essere gestito.

Per molto tempo, ho eseguito SCW su uno stack backend composto da HAProxy per la terminazione SSL, Varnish Cache per la memorizzazione nella cache on-box e Nginx per l’effettiva applicazione del server Web, il tutto gestito da Cloudflare per assorbire la maggior parte del carico. ( Ho scritto a lungo su questa configurazione su Ars qualche anno fa per le persone che desiderano dettagli più approfonditi.) Questo stack è stato completamente testato in battaglia ed è pronto a divorare qualunque traffico gli abbiamo lanciato, ma era anche fastidiosamente complesso , con più livelli di cache da affrontare e tale complessità ha reso la risoluzione dei problemi più difficile di quanto avrei voluto.

Pertanto, durante un periodo di inattività invernale di due anni fa, ho colto l’occasione per eliminare parte della complessità e ridurre lo stack di hosting a un’unica applicazione server Web monolitica: OpenLiteSpeed .

Fuori il vecchio, dentro il nuovo

Non sapevo molto di OpenLiteSpeed (“OLS” per i suoi amici) a parte il fatto che è menzionato in molti nelle discussioni sull’hosting WordPress e poiché SCW esegue WordPress, ho iniziato a interessarmi. OLS sembrava ricevere molti elogi per il suo caching integrato, soprattutto quando era coinvolto WordPress; si presumeva che fosse abbastanza veloce rispetto a Nginx ; e, francamente, dopo circa cinque anni trascorsi ad amministrare lo stesso stack, ero interessato a cambiare le cose. OpenLiteSpeed lo era!

Il primo aggiustamento significativo da affrontare è stato che OLS è configurato principalmente attraverso una vera e propria GUI, con tutti i fastidiosi potenziali problemi che comporta (un’altra porta da proteggere, un’altra password da gestire, un altro punto di accesso pubblico al backend, più PHP risorse dedicate solo all’interfaccia di amministrazione). Ma la GUI era veloce e mostrava principalmente le impostazioni che dovevano essere esposte. Tradurre la configurazione esistente di Nginx WordPress in linguaggio OLS è stato un buon esercizio di acclimatazione e alla fine ho optato per i tunnel Cloudflare come metodo accettabile per mantenere la console di amministrazione nascosta e teoricamente sicura.

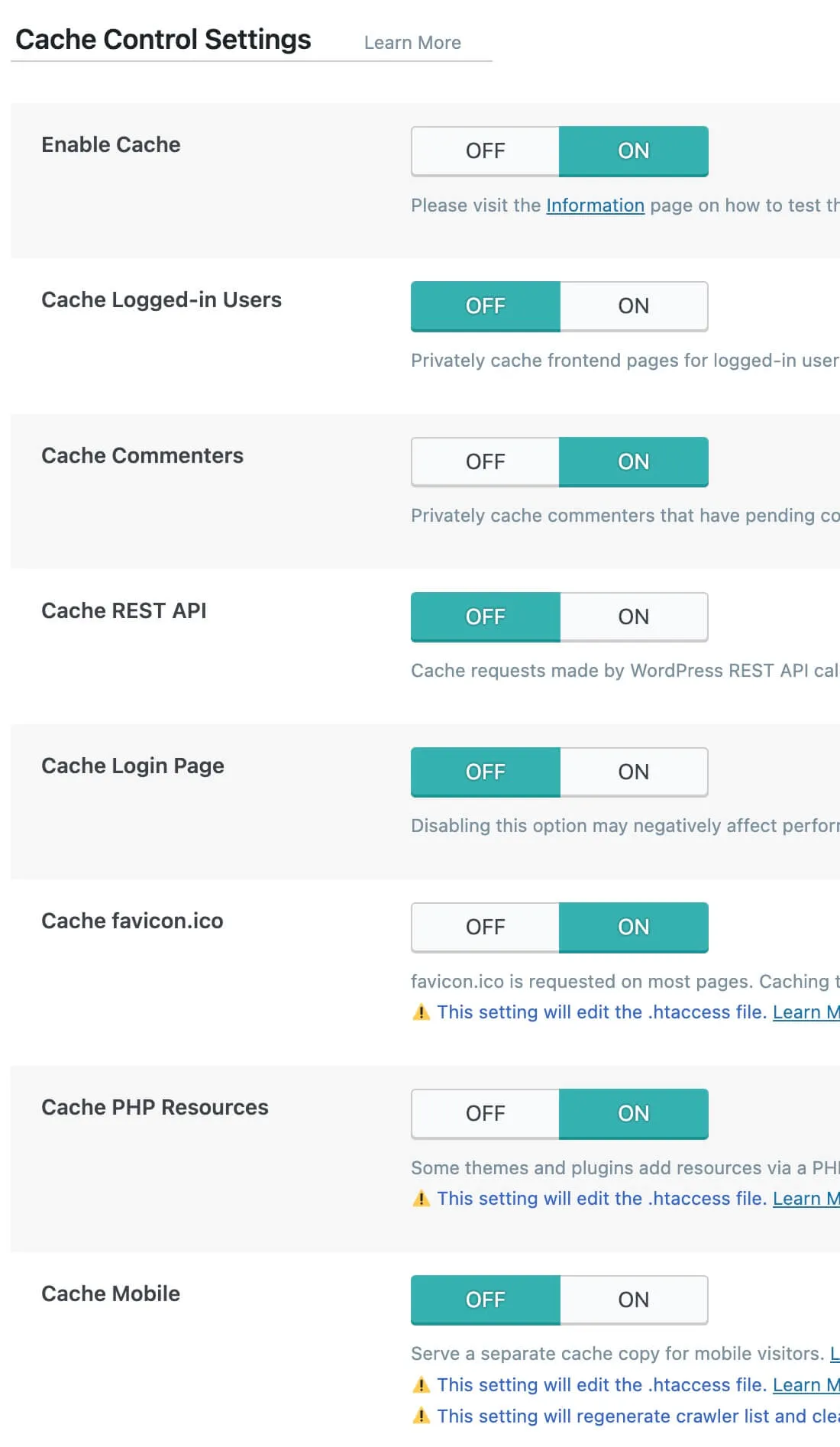

L’altro importante aggiustamento è stato il plugin OLS LiteSpeed Cache per WordPress, che è lo strumento principale utilizzato per configurare il modo in cui WordPress stesso interagisce con OLS e la sua cache integrata. È un enorme plugin con pagine e pagine di opzioni configurabili , molte delle quali riguardano l’utilizzo del servizio CDN Quic.Cloud (gestito da LiteSpeed Technology, la società che ha creato OpenLiteSpeed e il suo fratello a pagamento, LiteSpeed ).

Per ottenere il massimo da WordPress su OLS è stato necessario dedicare un po’ di tempo al plugin, cercando di capire quali opzioni sarebbero state utili e quali sarebbero state dannose. (Forse non sorprende che ci siano molti modi per cacciarsi in stupidi quantità di guai essendo troppo aggressivi con la memorizzazione nella cache.) Fortunatamente, Space City Weather fornisce un ottimo banco di prova per i server web, essendo un sito ben attivo con una cache molto carico di lavoro favorevole, quindi ho elaborato una configurazione iniziale della quale ero ragionevolmente soddisfatto e, mentre pronunciavo le antiche parole sacre del rituale , ho premuto l’interruttore di cutover. HAProxy, Varnish e Nginx sono rimasti in silenzio e OLS ha preso il carico.

Lascia un commento