L’intelligenza artificiale ora può generare musica di qualità CD dal testo e sta solo migliorando

Immagina di digitare “musica introduttiva drammatica” e di ascoltare una sinfonia impennata o di scrivere “passi inquietanti” e di ottenere effetti sonori di alta qualità. Questa è la promessa di Stable Audio, un modello di intelligenza artificiale da testo ad audio annunciato mercoledì da Stability AI in grado di sintetizzare musica o suoni da descrizioni scritte. In breve tempo, una tecnologia simile potrebbe mettere alla prova i musicisti per il loro lavoro.

Se ricorderete, Stability AI è la società che ha contribuito a finanziare la creazione di Stable Diffusion , un modello di sintesi di immagini a diffusione latente rilasciato nell’agosto 2022. Non contenta di limitarsi alla generazione di immagini, la società si è ramificata nell’audio sostenendo Harmonai , un laboratorio di intelligenza artificiale che ha lanciato il generatore musicale Dance Diffusion a settembre.

Ora Stability e Harmonai vogliono entrare nella produzione audio commerciale basata sull’intelligenza artificiale con Stable Audio. A giudicare dai campioni di produzione , sembra un significativo miglioramento della qualità audio rispetto ai precedenti generatori audio AI che abbiamo visto.

Nella sua pagina promozionale, Stability fornisce esempi del modello AI in azione con suggerimenti come “musica epica per trailer, intense percussioni tribali e ottoni” e “lofi hip hop beat melodico chillhop 85 bpm”. Offre anche campioni di effetti sonori generati utilizzando Stable Audio. , ad esempio un pilota di linea che parla al citofono e persone che parlano in un ristorante affollato.

Per addestrare il suo modello, Stability ha collaborato con il fornitore di musica stock AudioSparx e ha concesso in licenza un set di dati “costituito da oltre 800.000 file audio contenenti musica, effetti sonori e stemmi di singoli strumenti, nonché i corrispondenti metadati di testo”. Dopo aver fornito 19.500 ore di audio nel modello, Stable Audio sa come imitare determinati suoni che ha sentito a comando perché i suoni sono stati associati a descrizioni testuali degli stessi all’interno della sua rete neurale.

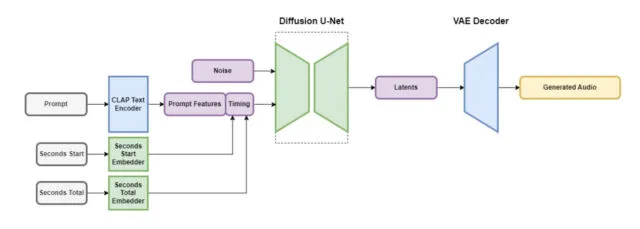

Stable Audio contiene diverse parti che lavorano insieme per creare rapidamente audio personalizzato. Una parte riduce il file audio in modo da mantenere le sue caratteristiche importanti rimuovendo il rumore non necessario. Ciò rende il sistema più veloce da apprendere e più veloce nella creazione di nuovo audio. Un’altra parte utilizza il testo (descrizioni dei metadati della musica e dei suoni) per guidare il tipo di audio generato.

Per accelerare le cose, l’architettura Stable Audio opera su una rappresentazione audio compressa e fortemente semplificata per ridurre il tempo di inferenza (la quantità di tempo necessaria a un modello di apprendimento automatico per generare un output dopo aver ricevuto un input). Secondo Stability AI, Stable Audio può eseguire il rendering di 95 secondi di audio stereo a una frequenza di campionamento di 44,1 kHz (spesso chiamata “qualità CD”) in meno di un secondo su una GPU Nvidia A100 . L’A100 è una robusta GPU per data center progettata per l’uso dell’intelligenza artificiale ed è molto più capace di una tipica GPU da gioco desktop.

Come accennato in precedenza, Stable Audio non è il primo generatore di musica basato su tecniche di diffusione latente. Lo scorso dicembre abbiamo parlato di Riffusion , una versione hobbistica di una versione audio di Stable Diffusion, sebbene le generazioni risultanti fossero lontane dai campioni di Stable Audio in termini di qualità. A gennaio, Google ha rilasciato MusicLM , un generatore musicale AI per audio a 24 kHz, e Meta ha lanciato una suite di strumenti audio open source (incluso un generatore di testo in musica) chiamata AudioCraft in agosto. Ora, con l’audio stereo a 44,1 kHz, Stable Diffusion alza la posta.

Stability afferma che Stable Audio sarà disponibile in un livello gratuito e in un piano Pro mensile da $ 12. Con l’opzione gratuita, gli utenti possono generare fino a 20 brani al mese, ciascuno della durata massima di 20 secondi. Il piano Pro espande questi limiti, consentendo 500 generazioni di tracce al mese e lunghezze di traccia fino a 90 secondi. Si prevede che i futuri rilasci di Stability includano modelli open source basati sull’architettura Stable Audio, nonché codice di formazione per coloro che sono interessati allo sviluppo di modelli di generazione audio.

Allo stato attuale, sembra che potremmo essere al limite della qualità della produzione musicale generata dall’intelligenza artificiale con Stable Audio, considerando la sua fedeltà audio. I musicisti saranno contenti se verranno sostituiti da modelli IA? Probabilmente no, se la storia ci ha mostrato qualcosa dalle proteste contro l’intelligenza artificiale nel campo delle arti visive . Per ora, un essere umano può facilmente surclassare qualsiasi cosa possa generare l’intelligenza artificiale, ma potrebbe non essere così a lungo. In ogni caso, l’audio generato dall’intelligenza artificiale può diventare un altro strumento nella cassetta degli attrezzi di produzione audio di un professionista.

Lascia un commento