Alexa falsificherà le voci dei vivi e dei morti durante lo sviluppo delle funzionalità

Amazon sta cercando di capire come fare in modo che l’assistente vocale di Alexa falsifichi profondamente la voce di chiunque, vivo o morto, con solo una breve registrazione. La società ha presentato la funzione alla conferenza re:Mars a Las Vegas mercoledì, utilizzando il trauma emotivo della pandemia in corso e il dolore per generare interesse.

Re:Mars di Amazon si concentra su intelligenza artificiale, apprendimento automatico, robotica e altre tecnologie emergenti, con esperti di tecnologia e leader del settore che salgono sul palco. Durante il keynote del secondo giorno, Rohit Prasad, Senior Vice President e Chief Scientist di Alexa AI presso Amazon, ha mostrato una funzionalità attualmente in fase di sviluppo per Alexa.

Nella dimostrazione, un bambino chiede ad Alexa: “La nonna può finire di leggere Il mago di Oz per me?” Alexa risponde: “Va bene”, con la sua tipica voce robotica effeminata. Ma poi dall’oratore si sente la voce della nonna del bambino, che sta leggendo una fiaba di L. Frank Baum.

Puoi guardare una demo qui sotto:

Prasad ha solo affermato che Amazon sta “lavorando” sulla capacità di Alexa e non ha spiegato quale lavoro rimane e quando o se sarà disponibile.

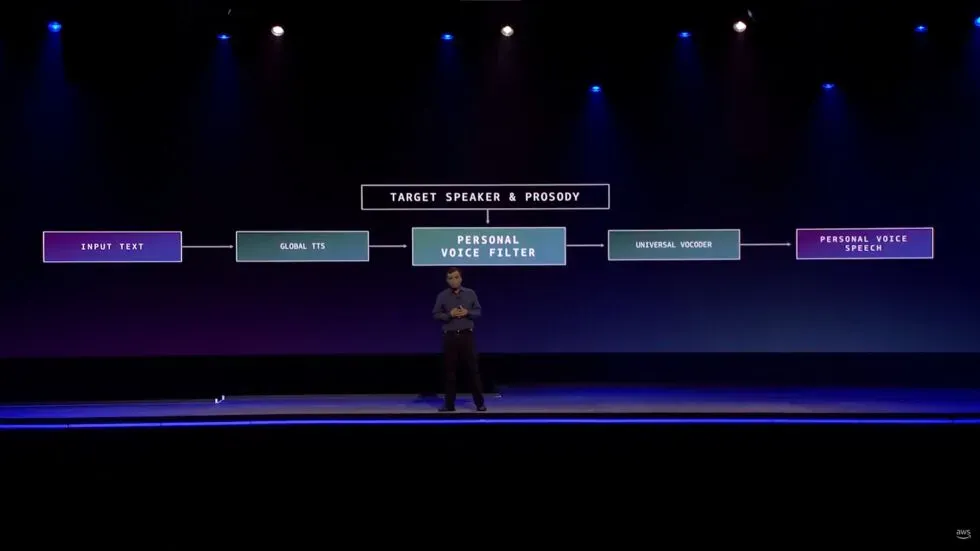

Tuttavia, ha fornito i più piccoli dettagli tecnici.

“Ci è voluta un’invenzione quando abbiamo dovuto imparare a riprodurre una voce di alta qualità in meno di un minuto di registrazione rispetto alle ore di registrazione in studio”, ha affermato. “Lo abbiamo reso possibile inquadrando il problema come un problema di conversione della voce piuttosto che come un problema di generazione del parlato”.

Naturalmente, i deepfake di tutti i tipi hanno generalmente una reputazione mista. Tuttavia, sono stati fatti alcuni tentativi per utilizzare la tecnologia come strumento piuttosto che come veicolo di inquietudine.

I deepfake audio, in particolare, come osserva The Verge, sono stati usati dai media per compensare quando, ad esempio, un podcaster ha incasinato una battuta o quando la star di un progetto è morta improvvisamente, come è successo con il documentario Roadrunner di Anthony Bourdain .

La pubblicazione osserva che ci sono persino casi di persone che usano l’intelligenza artificiale per creare chatbot che comunicano come se fossero persone care perdute.

Alexa non sarà nemmeno il primo prodotto di consumo a utilizzare l’audio deepfake per sostituire un membro della famiglia che non può essere presente di persona. Lo smart speaker Takara Tomy , come sottolinea Gi z modo , utilizza l’intelligenza artificiale per leggere le favole della buonanotte ai bambini con la voce di un genitore. Si dice che i genitori carichino le loro voci leggendo la sceneggiatura per circa 15 minuti, per così dire. Anche se questo differisce notevolmente dalla demo di Amazon in quanto il proprietario del prodotto sceglie di fornire la propria voce piuttosto che il prodotto usando la voce di qualcuno che probabilmente non può dare il proprio permesso.

A parte le preoccupazioni per i deepfake utilizzati per truffe, rapine e altre attività nefaste, ci sono già alcune cose inquietanti su come Amazon sta costruendo questa funzionalità, che non ha ancora una data di rilascio.

Prima di mostrare la demo, Prasad ha parlato di come Alexa offra agli utenti una “relazione di cameratismo”.

“In questo ruolo di cameratismo, le qualità umane dell’empatia e dell’affetto sono fondamentali per creare fiducia”, ha affermato il CEO. “Questi attributi sono diventati ancora più importanti durante la pandemia in corso, quando molti di noi hanno perso qualcuno che amiamo. Sebbene l’intelligenza artificiale non possa eliminare questo dolore per la perdita, può sicuramente estendere la loro memoria.

Prasad ha aggiunto che la funzione “fornisce una relazione personale duratura”.

È vero che innumerevoli persone stanno seriamente cercando “empatia e affetto” umani in risposta allo stress emotivo causato dalla pandemia di COVID-19. Tuttavia, l’assistente vocale di intelligenza artificiale di Amazon non è all’altezza del compito di soddisfare queste esigenze umane. Alexa inoltre non può fornire “relazioni personali a lungo termine” con persone che non sono più con noi.

Non è difficile credere che ci siano buone intenzioni dietro questa caratteristica in evoluzione e che ascoltare la voce della persona che ti manca possa essere di grande conforto. Teoricamente, potremmo persino divertirci con una funzionalità del genere. Fare in modo che Alexa faccia sembrare un amico come se avesse detto che qualcosa di stupido è innocuo. E, come abbiamo detto sopra, ci sono altre aziende che utilizzano la tecnologia deepfake in modi simili a quanto dimostrato da Amazon.

Ma presentare la capacità in evoluzione di Alexa come un modo per riconnettersi con i membri della famiglia deceduti è un salto enorme, irrealistico e problematico. Nel frattempo, toccare le corde del cuore, provocando dolore e solitudine associati alla pandemia, sembra essere inutile. Ci sono posti in cui Amazon non appartiene e la consulenza sul dolore è uno di questi.

Lascia un commento