La Cina continua ad acquistare schede Nvidia zoppicanti per addestrare i suoi modelli di intelligenza artificiale

Lo scorso anno gli Stati Uniti hanno agito in modo aggressivo per limitare la capacità della Cina di sviluppare intelligenza artificiale per scopi militari, bloccando la vendita lì dei chip statunitensi più avanzati utilizzati per addestrare i sistemi di intelligenza artificiale.

I grandi progressi nei chip utilizzati per sviluppare l’IA generativa hanno fatto sì che l’ultima tecnologia statunitense in vendita in Cina sia più potente di qualsiasi altra disponibile prima. Ciò nonostante il fatto che i chip siano stati deliberatamente ostacolati dal mercato cinese per limitarne le capacità, rendendoli meno efficaci dei prodotti disponibili in altre parti del mondo.

Il risultato è stato un aumento vertiginoso degli ordini cinesi per i più recenti processori americani avanzati. Le principali società Internet cinesi hanno effettuato ordini per $ 5 miliardi di chip da Nvidia, le cui unità di elaborazione grafica sono diventate il cavallo di battaglia per l’addestramento di grandi modelli di intelligenza artificiale.

È probabile che l’impatto dell’aumento della domanda globale per i prodotti Nvidia sosterrà i risultati finanziari del secondo trimestre del produttore di chip che dovrebbero essere annunciati mercoledì.

Oltre a riflettere la domanda di chip migliorati per addestrare gli ultimi modelli di linguaggi di grandi dimensioni delle società Internet, la corsa è stata anche provocata dalle preoccupazioni che gli Stati Uniti possano rafforzare ulteriormente i controlli sulle esportazioni, rendendo indisponibili anche questi prodotti limitati in futuro.

Tuttavia, Bill Dally, capo scienziato di Nvidia, ha suggerito che i controlli sulle esportazioni statunitensi avrebbero avuto un impatto maggiore in futuro.

“Poiché i requisiti di formazione [per i sistemi di intelligenza artificiale più avanzati] continuano a raddoppiare ogni 6-12 mesi”, il divario tra i chip venduti in Cina e quelli disponibili nel resto del mondo “crescerà rapidamente”, ha affermato.

Velocità di elaborazione della tappatura

I controlli delle esportazioni statunitensi sui chip dello scorso anno facevano parte di un pacchetto che includeva l’impedimento ai clienti cinesi di acquistare le attrezzature necessarie per produrre chip avanzati.

Washington ha fissato un limite alla massima velocità di elaborazione dei chip che potrebbero essere venduti in Cina, nonché alla velocità con cui i chip possono trasferire i dati, un fattore critico quando si tratta di addestrare modelli di intelligenza artificiale di grandi dimensioni, un lavoro ad alta intensità di dati che richiede collegare insieme un gran numero di chip.

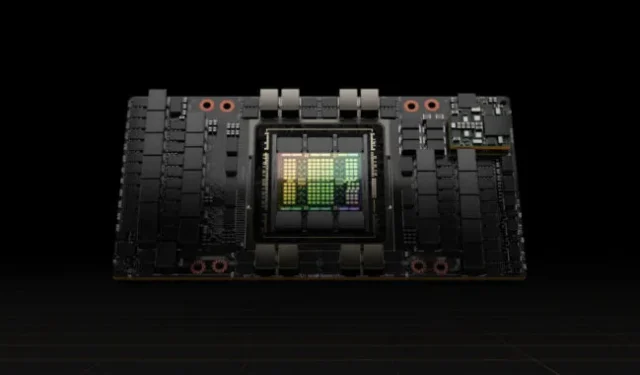

Nvidia ha risposto tagliando la velocità di trasferimento dei dati sui suoi processori A100, all’epoca le sue GPU top di gamma, creando un nuovo prodotto per la Cina chiamato A800 che soddisfaceva i controlli sulle esportazioni.

Quest’anno, ha seguito con limiti di trasferimento dati sul suo H100, un nuovo e molto più potente processore appositamente progettato per addestrare modelli di linguaggi di grandi dimensioni, creando una versione chiamata H800 per il mercato cinese.

Il produttore di chip non ha rivelato le capacità tecniche dei processori realizzati per la Cina, ma i produttori di computer sono stati aperti sui dettagli. Lenovo, ad esempio, pubblicizza server contenenti chip H800 che afferma essere identici in tutto e per tutto agli H100 venduti in altre parti del mondo, tranne per il fatto che hanno una velocità di trasferimento di soli 400 gigabyte al secondo.

Questo è al di sotto del limite di 600 GB/s che gli Stati Uniti hanno fissato per le esportazioni di chip in Cina. In confronto, Nvidia ha affermato che il suo H100, che ha iniziato a spedire ai clienti all’inizio di quest’anno, ha una velocità di trasferimento di 900 GB/s.

La minore velocità di trasferimento in Cina significa che gli utenti dei chip devono affrontare tempi di addestramento più lunghi per i loro sistemi di intelligenza artificiale rispetto ai clienti di Nvidia in altre parti del mondo, una limitazione importante poiché i modelli sono cresciuti di dimensioni.

I tempi di formazione più lunghi aumentano i costi poiché i chip dovranno consumare più energia, una delle maggiori spese con i modelli di grandi dimensioni.

Tuttavia, anche con questi limiti, i chip H800 in vendita in Cina sono più potenti di qualsiasi altra cosa disponibile altrove prima di quest’anno, portando all’enorme domanda.

I chip H800 sono cinque volte più veloci dei chip A100 che erano stati le GPU più potenti di Nvidia, secondo Patrick Moorhead, analista di chip statunitense presso Moor Insights & Strategy.

Ciò significa che le società Internet cinesi che hanno addestrato i loro modelli di intelligenza artificiale utilizzando chip di prima qualità acquistati prima dei controlli sulle esportazioni statunitensi possono ancora aspettarsi grandi miglioramenti acquistando i semiconduttori più recenti, ha affermato.

“Sembra che il governo degli Stati Uniti voglia non interrompere lo sforzo di intelligenza artificiale della Cina, ma renderlo più difficile”, ha affermato Moorhead.

Costi-benefici

Molte aziende tecnologiche cinesi sono ancora nella fase di pre-addestramento di modelli linguistici di grandi dimensioni, che bruciano molte prestazioni dai singoli chip GPU e richiedono un alto grado di capacità di trasferimento dei dati.

Solo i chip di Nvidia possono fornire l’efficienza necessaria per il pre-training, affermano gli ingegneri di intelligenza artificiale cinesi. Le prestazioni dei singoli chip della serie 800, nonostante le velocità di trasferimento ridotte, sono ancora superiori agli altri sul mercato.

“Le GPU di Nvidia possono sembrare costose ma sono, in realtà, l’opzione più conveniente”, ha affermato un ingegnere di intelligenza artificiale presso una delle principali società Internet cinesi.

Altri fornitori di GPU hanno indicato prezzi più bassi con un servizio più tempestivo, ha affermato l’ingegnere, ma la società ha ritenuto che i costi di formazione e sviluppo si sarebbero accumulati e che avrebbe avuto l’onere aggiuntivo dell’incertezza.

L’offerta di Nvidia include l’ecosistema software, con la sua piattaforma informatica Compute Unified Device Architecture, o Cuda, che ha creato nel 2006 e che è diventata parte dell’infrastruttura AI.

Gli analisti del settore ritengono che le aziende cinesi potrebbero presto affrontare limitazioni nella velocità delle interconnessioni tra i chip della serie 800. Ciò potrebbe ostacolare la loro capacità di gestire la crescente quantità di dati richiesti per l’addestramento all’intelligenza artificiale e saranno ostacolati man mano che approfondiranno la ricerca e lo sviluppo di modelli linguistici di grandi dimensioni.

Charlie Chai, un analista di 86Research con sede a Shanghai, ha paragonato la situazione alla costruzione di molte fabbriche con autostrade congestionate tra di loro. Anche le aziende in grado di accogliere i chip indeboliti potrebbero incontrare problemi entro i prossimi due o tre anni, ha aggiunto.

© 2023 Financial Times Ltd. Tutti i diritti riservati. Si prega di non copiare e incollare articoli di FT e di non ridistribuirli via e-mail o per posta sul web.

Lascia un commento