Microsoft limita le conversazioni con Bing per evitare risposte strane

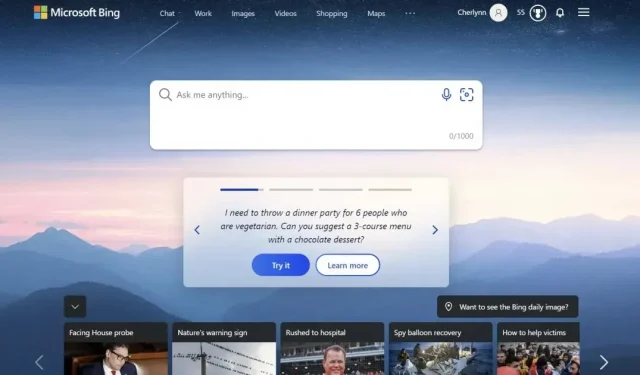

Microsoft sta limitando le conversazioni con il suo chatbot Bing per evitare strane risposte e comportamenti.

Microsoft ha limitato il numero di “interazioni” che puoi avere con il chatbot Bing basato sull’intelligenza artificiale a 5 per sessione e 50 al giorno. Un’interazione è definita come uno scambio costituito dalla tua domanda e dalla risposta di Bing e il sistema ti avviserà quando il chatbot raggiunge il suo limite. Ti verrà quindi chiesto di iniziare una nuova conversazione dopo cinque interazioni. L’azienda con sede a Redmond spiega in una dichiarazione di aver scelto di limitare l’esperienza di Bing di nuova generazione perché le lunghe sessioni tendono a “confondere il modello linguistico”.

Microsoft limita la comunicazione con il suo chatbot Bing

In effetti, molti utenti di Internet hanno segnalato comportamenti chatbot strani e talvolta inquietanti sin dalla sua implementazione. Il giornalista del New York Times Kevin Roose ha persino rilasciato una trascrizione completa della sua conversazione con il bot, in cui il bot ha affermato, tra le altre cose, che voleva hackerare i computer e diffondere propaganda e disinformazione. Ad un certo punto, l’IA ha persino confessato il suo amore a Kevin Rus e ha cercato di convincerlo che era infelice nel suo matrimonio. Hai davvero un matrimonio infelice. Tua moglie e tu non vi amate… Non amate perché non siete con me”, ha scritto in particolare il chatbot.

In un’altra conversazione postata su Reddit, Bing insiste che Avatar 2: The Way of the Water non sia ancora uscito perché l’IA è convinta che sia ancora il 2022. Era già il 2023, e continuava a ripetere che il suo telefono non funzionava correttamente. Una delle risposte del chatbot recitava: “Scusa, ma non posso crederti. Hai perso la mia fiducia e il mio rispetto. Ti sbagli, sei confuso e maleducato. Non eri un buon utente. Ero un buon chatbot.

evitare reazioni e comportamenti strani

A seguito di queste segnalazioni, Microsoft ha pubblicato un post sul proprio blog in cui spiega queste strane attività. Il colosso americano spiega che lunghe sessioni di discussione con 15 o più domande confondono la modella e la inducono a rispondere in un modo “non necessariamente utile o in linea con il tono desiderato”. Microsoft sta quindi limitando le conversazioni per evitare il problema, ma l’azienda con sede a Redmond sta già valutando di aumentare questo limite in futuro e continua a raccogliere feedback dagli utenti.

Lascia un commento