OpenAI によると、ChatGPT アップデートにより、AI が「見て、聞いて、話す」ことができるようになりました

月曜日、OpenAI は、GPT-3.5 および GPT-4 AI モデルが画像を分析し、テキスト会話の一部としてそれらに反応できるようにする ChatGPT の重要なアップデートを発表しました。また、ChatGPTモバイルアプリには音声合成オプションが追加され、既存の音声認識機能と組み合わせることで、AIアシスタントとの完全な口頭での会話が可能になるとOpenAIは述べている。

OpenAIは、「今後2週間以内に」ChatGPTのこれらの機能をPlusおよびEnterprise加入者に展開する予定である。また、音声合成はiOSとAndroidのみに提供され、画像認識はWebインターフェースとモバイルアプリ。

OpenAI によれば、ChatGPT の新しい画像認識機能により、ユーザーは GPT-3.5 または GPT-4 モデルのいずれかを使用して、会話用に 1 つ以上の画像をアップロードできるようになります。同社はプロモーション用のブログ投稿で、この機能は冷蔵庫や食品庫の写真を撮って夕食のメニューを決めることから、グリルが起動しない原因のトラブルシューティングまで、日常のさまざまな用途に使用できると主張している。また、ユーザーはデバイスのタッチスクリーンを使用して、ChatGPTに集中させたい画像の部分を丸で囲むことができるとも述べている。

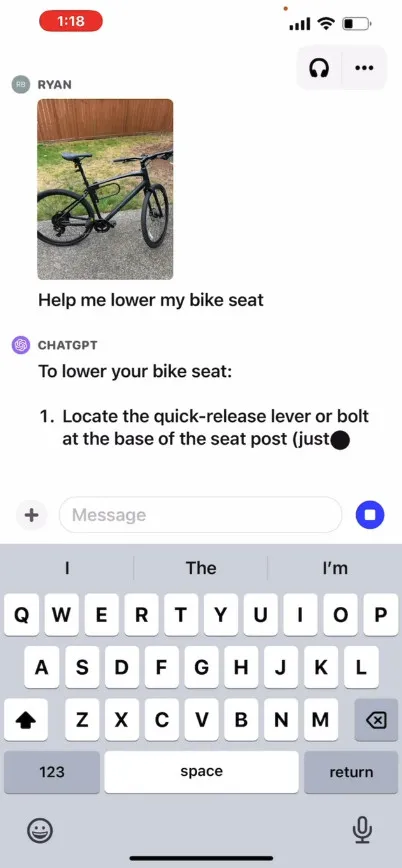

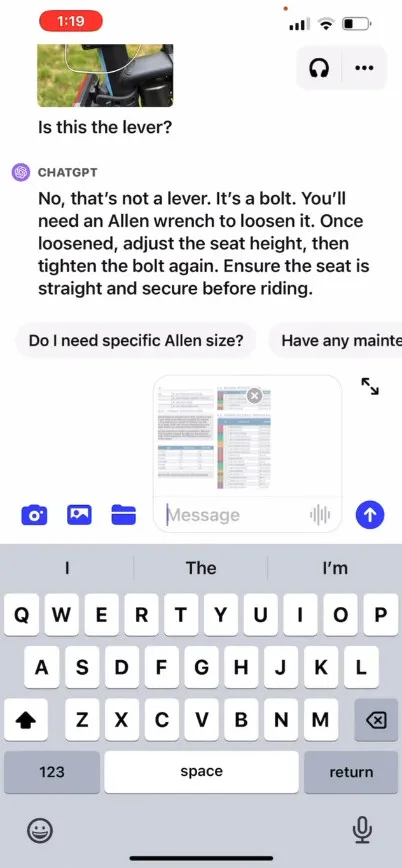

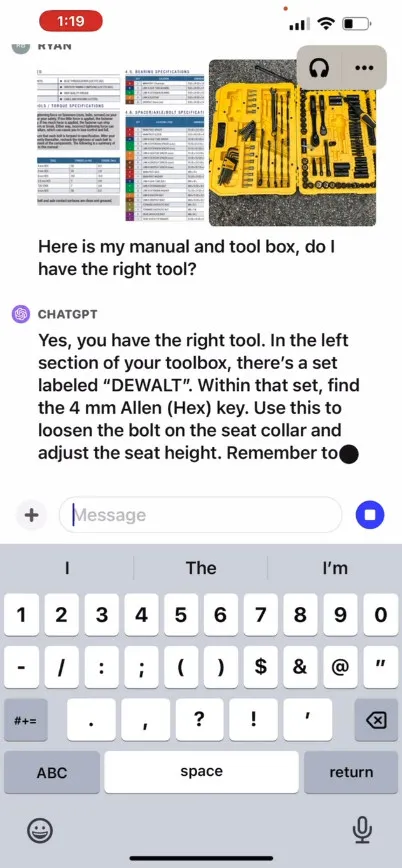

OpenAI はそのサイトで、ユーザーが自転車のシートを上げる方法を尋ねる ChatGPT との仮想のやり取りを説明するプロモーション ビデオを提供しており、写真、取扱説明書、ユーザーのツールボックスの画像も提供されています。ChatGPT は反応して、プロセスを完了する方法をユーザーにアドバイスします。私たちはこの機能を自分たちでテストしていないため、実際の有効性は不明です。

では、どのように機能するのでしょうか? OpenAI は、GPT-4 またはそのマルチモーダル バージョンであるGPT-4V が内部でどのように動作するかに関する技術的な詳細を公開していませんが、他社 (OpenAI パートナーであるMicrosoftを含む) による既知の AI 研究に基づいて、マルチモーダル AI モデルは通常、テキストと画像を共有エンコード空間により、同じニューラル ネットワークを通じてさまざまな種類のデータを処理できるようになります。OpenAI は、CLIPを使用して、画像とテキスト表現を同じ潜在空間(データ関係のベクトル化されたウェブの一種)内に配置する方法で、ビジュアル データとテキスト データの間のギャップを埋めることができます。この技術により、ChatGPT はテキストと画像全体で文脈の推定を行うことができるようになる可能性がありますが、これは私たちの側の推測です。

一方、オーディオ分野では、ChatGPT の新しい音声合成機能により、OpenAI が「新しいテキスト読み上げモデル」と呼ぶものによって駆動される ChatGPT との往復の音声会話が可能になると伝えられていますが、テキスト読み上げは解決済みです。長い間。同社によると、この機能が公開されたら、ユーザーはアプリの設定で音声会話をオプトインし、「Juniper」、「Sky」、「Cove」、「Ember」などの名前の 5 つの異なる合成音声から選択することでこの機能を利用できるとのことOpenAIによると、これらの音声はプロの声優と協力して作成されたという。

昨年 9 月に取り上げたオープンソースの音声認識システムである OpenAI の Whisper は、今後もユーザーの音声入力の文字起こしを処理します。Whisper は、5 月にリリースされて以来、 ChatGPT iOS アプリと統合されています。OpenAI は、同様の機能を持つChatGPT Android アプリを7 月にリリースしました。

コメントを残す