中国は AI モデルをトレーニングするために、足を引っ張る Nvidia カードを購入し続けている

米国は昨年、軍事目的で人工知能を開発する中国の能力を制限するために積極的に行動し、AIシステムの訓練に使用される最先端の米国製チップの中国での販売を阻止した。

生成 AI の開発に使用されるチップの大幅な進歩により、中国で販売されている米国の最新技術は、これまでに入手可能なものよりも強力になっています。それは、チップが中国市場向けに機能を制限するために意図的に妨げられており、世界の他の地域で入手可能な製品よりも効果が低くなっているという事実にもかかわらずです。

その結果、米国の最新先進プロセッサに対する中国の注文が急増している。中国の大手インターネット企業は、NVIDIA に 50 億ドル相当のチップを発注した。NVIDIA のグラフィック処理装置は、大規模な AI モデルをトレーニングするための主力製品となっている。

Nvidia製品に対する世界的な需要の急増の影響が、水曜日に発表される予定の半導体メーカーの第2四半期決算を下支えする可能性が高い。

この需要は、インターネット企業の最新の大規模言語モデルをトレーニングするための改良されたチップに対する需要を反映していることに加えて、米国が輸出管理をさらに強化し、これらの限られた製品さえ将来的に入手できなくなるのではないかという懸念によっても促されている。

しかし、NVIDIA の首席科学者ビル・ダリー氏は、米国の輸出規制が将来的により大きな影響を与えるだろうと示唆した。

同氏は、「(最先端のAIシステムの)トレーニング要件は6~12カ月ごとに2倍になり続けており、中国で販売されているチップと世界の他の地域で入手可能なチップとの差は「急速に拡大するだろう」と述べた。

処理速度の制限

昨年の米国によるチップの輸出規制は、中国の顧客が先端チップの製造に必要な装置を購入することを阻止することを含むパッケージの一部だった。

ワシントン政府は、中国で販売できるチップの最大処理速度と、チップがデータを転送できる速度に上限を設定した。これは、大規模な AI モデルのトレーニング、つまり大量のデータを必要とする作業を行う場合に重要な要素である。多数のチップを接続します。

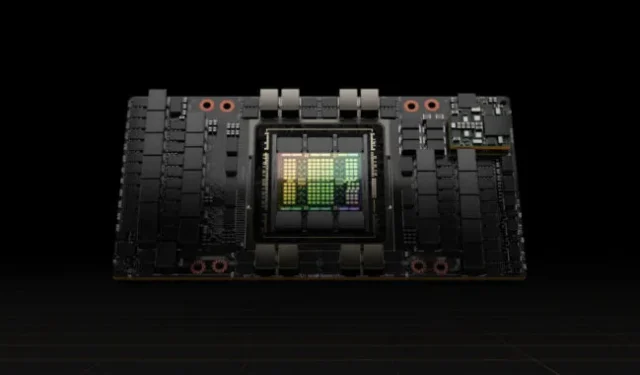

Nvidiaは、当時最高級GPUだったA100プロセッサのデータ転送速度を下げることで対応し、輸出規制を満たすA800と呼ばれる中国向けの新製品を開発した。

今年、同社は、大規模な言語モデルをトレーニングするために特別に設計された、新しくてはるかに強力なプロセッサである H100 にデータ転送制限を設け、中国市場向けに H800 と呼ばれるバージョンを作成しました。

チップメーカーは中国向けプロセッサの技術的能力を明らかにしていないが、コンピュータメーカーは詳細についてオープンである。たとえば、Lenovo は、H800 チップを搭載したサーバーを宣伝していますが、転送速度が 1 秒あたりわずか 400 ギガバイトであることを除けば、世界中で販売されている H100 とあらゆる点で同一であると同社は主張しています。

これは米国が中国へのチップ輸出に設定した毎秒600GBの制限を下回っている。これに対し、NVIDIA は、今年初めに顧客への出荷を開始した H100 の転送速度は 900GB/秒であると発表しました。

中国の転送速度が低いということは、中国のチップのユーザーが世界の他の地域の Nvidia の顧客よりも AI システムのトレーニングに長い時間がかかることを意味しており、モデルのサイズが大きくなっているため、これは重要な制限です。

トレーニング時間が長くなると、チップがより多くの電力を消費する必要があるため、コストが増加します。これは、大規模なモデルで最も大きな出費の 1 つです。

しかし、これらの制限があっても、中国で販売されている H800 チップは、今年以前に他で入手可能などのチップよりも強力であるため、膨大な需要につながっています。

Moor Insights & Strategyの米国チップアナリスト、パトリック・ムーアヘッド氏によると、H800チップは、Nvidiaの最も強力なGPUだったA100チップよりも5倍高速だという。

これは、米国の輸出規制以前に購入された最高級チップを使ってAIモデルを訓練していた中国のインターネット企業は、最新の半導体を購入することで依然として大幅な改善が期待できることを意味すると同氏は述べた。

ムーアヘッド氏は「米国政府は中国のAIへの取り組みを阻止するのではなく、より困難にすることを望んでいるようだ」と述べた。

費用対効果

中国のハイテク企業の多くはまだ大規模な言語モデルを事前トレーニングしている段階にあり、個々の GPU チップから多くのパフォーマンスを消費し、高度なデータ転送能力が必要となります。

中国のAIエンジニアらによると、事前トレーニングに必要な効率を提供できるのはNvidiaのチップだけだという。800 シリーズの個々のチップのパフォーマンスは、転送速度が低下しているにもかかわらず、市場の他のチップよりも優れています。

「Nvidia の GPU は高価に見えるかもしれませんが、実際には最も費用対効果の高い選択肢です」と中国の大手インターネット企業の AI エンジニアは述べています。

同エンジニアによると、他のGPUベンダーは、よりタイムリーなサービスで低価格を提示していたが、同社はトレーニングと開発のコストがかさみ、不確実性による余分な負担がかかると判断したという。

Nvidia の製品には、2006 年に設立され、AI インフラストラクチャの一部となったコンピューティング プラットフォーム Compute Unified Device Architecture (Cuda) を含むソフトウェア エコシステムが含まれています。

業界アナリストらは、中国企業は間もなく800シリーズチップ間の相互接続速度の制限に直面する可能性があると考えている。これにより、AI トレーニングに必要なデータ量の増加に対処する能力が妨げられる可能性があり、大規模な言語モデルの研究と開発をさらに深く掘り下げる際に妨げられることになります。

上海を拠点とする86リサーチのアナリスト、チャーリー・チャイ氏は、高速道路が混雑し、多くの工場が建設されている状況と比較した。脆弱化したチップに対応できる企業であっても、今後2、3年以内に問題に直面する可能性があると同氏は付け加えた。

© 2023 The Financial Times Ltd.全著作権所有。FT の記事をコピー&ペーストしたり、電子メールで再配布したり、Web に投稿したりしないでください。

コメントを残す