生成 AI は優れていますが、人的コストと環境コストを忘れてはなりません。

過去数か月にわたって、人工知能の分野は急速な成長を遂げており、Dall-E や GPT-4 などの新しいモデルが次々に登場しています。毎週、エキサイティングな新しいモデル、製品、ツールが登場することが約束されています。誇大広告の波に流されてしまうのは簡単ですが、こうした輝かしい機会には社会と地球にとっての犠牲が伴います。

欠点としては、希少鉱物の採掘に伴う環境コスト、時間のかかるデータ注釈プロセスの人件費、パラメータが増えるにつれて AI モデルのトレーニングに必要な財務投資の増大などが挙げられます。

これらのモデルの最新世代につながり、それに関連するコストを押し上げたイノベーションを見てみましょう。

大型モデル

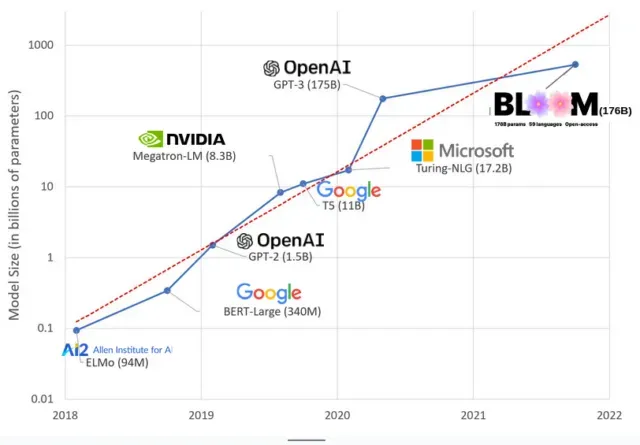

AI モデルは近年ますます大きくなり、研究者は現在、数千億のパラメーターでそのサイズを測定しています。「パラメータ」は、トレーニング データに基づいてパターンを学習するためにモデルで使用される内部関係です。

ChatGPT のような大規模言語モデル (LLM) では、Google の PaLM モデルのおかげで、パラメーターの数が 2018 年の 1 億から 2023 年には 5,000 億に増加しました。この成長の背後にある理論は、より多くのパラメーターを持つモデルは、最初にトレーニングされていないタスクでもパフォーマンスが向上するはずであるというものですが、この仮説はまだ証明されていません。

通常、大規模なモデルはトレーニングに時間がかかり、より多くの GPU が必要になり、より多くのコストがかかるため、選ばれた少数の組織のみがモデルをトレーニングできます。1,750 億のパラメータを持つ GPT-3 のトレーニング費用は460 万ドルと推定されており、ほとんどの企業や組織にとっては手の届かない金額です。( Meta によってトレーニングされた最近のモデルである LLaMA の場合など、場合によってはモデルのトレーニングのコストが削減されることに注意してください。)

これにより、AI コミュニティにおいて、最先端の LLM を教えることができる人々 (主にグローバル ノースの大手テクノロジー企業や裕福な機関) とそうでない人々 (非営利団体、新興企業) の間のデジタル ディバイドが生じています。 、スーパーコンピューターにアクセスできない人)。または数百万のクラウド クレジット)。これらの巨大企業の構築と展開には、多くの地球資源が必要です。GPU を製造するためのレアメタル、巨大なデータセンターを冷却するための水、地球規模でそれらのデータセンターを 24 時間年中無休で稼働し続けるためのエネルギー…これらすべては、焦点を絞ることを優先するために無視されがちです。注意。結果として得られるモデルの将来性について。

惑星の影響

カーネギーメロン大学のエマ・ストルベル教授によるLLMトレーニングの二酸化炭素排出量に関する研究では、パラメータ数が2億1,300万しかないBERTと呼ばれる2019年モデルのトレーニングでは、車5台分にほぼ相当する280トンの二酸化炭素排出量が排出されることが判明した。人生。それ以来、モデルは成長し、機器はより効率的になりましたが、現在はどうなっているでしょうか?

1,760 億のパラメーターを持つ言語モデルである BLOOM のトレーニングによって引き起こされる炭素排出量を研究するために私が最近書いた科学論文では、ここ数年に発表されたいくつかの LLM のエネルギー消費とその後の炭素排出量を比較しました。比較の目的は、さまざまなサイズの LLM 排出量の規模と、それらに何が影響するかを把握することでした。

コメントを残す