OpenAI の新しい AI 画像ジェネレーターは、細部の限界を押し広げ、忠実度を高めます

水曜日、OpenAI は、ChatGPTとの完全な統合を特徴とする AI 画像合成モデルの最新バージョンである DALL-E 3 を発表しました。DALL-E 3 は、複雑な説明に厳密に従い、画像内のテキスト生成 (ラベルや標識など) を処理することで画像をレンダリングしますが、これは以前のモデルでは課題でした。現在調査プレビュー段階にあり、10 月初旬に ChatGPT Plus および Enterprise の顧客に利用可能になる予定です。

前任者と同様に、DALLE-3 は、プロンプトと呼ばれる書かれた説明に基づいて新しい画像を作成するテキストから画像へのジェネレーターです。OpenAI は DALL-E 3 に関する技術的な詳細を発表していませんが、DALL-E の以前のバージョンの中心となる AI モデルは、人間のアーティストや写真家によって作成された何百万もの画像でトレーニングされており、その一部は Shutterstock などのストック Web サイトからライセンスを受けています。おそらく DALL-E 3 もこれと同じ公式に従いますが、新しいトレーニング技術とより多くの計算トレーニング時間を使用しています。

OpenAI がプロモーション ブログで提供したサンプルから判断すると、DALL-E 3 は、プロンプトに従うという点で、他のどのモデルよりも根本的に優れた画像合成モデルであるようです。OpenAI のサンプルは、その有効性を考慮して厳選されていますが、プロンプトの指示に忠実に従っており、最小限の変形でオブジェクトを説得力をもってレンダリングしているようです。DALL-E 2と比較して、DALL-E 3 は手などの細部をより効果的に洗練し、「ハッキングや迅速なエンジニアリングは必要なく」デフォルトで魅力的な画像を作成すると OpenAI は述べています。

比較すると、別のベンダーの競合する AI 画像合成モデルである Midjourney は、写真のようにリアルな詳細をうまくレンダリングしますが、それでも、画像出力を制御するには、プロンプトを操作して直観に反する多くの操作を必要とします。

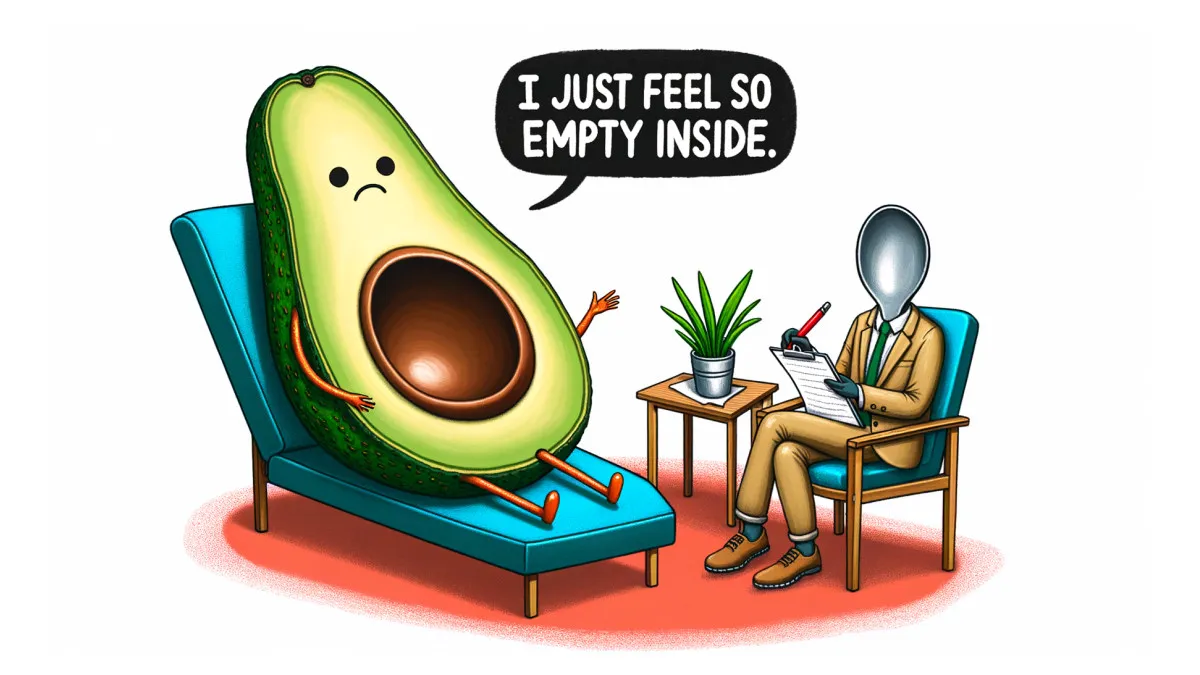

また、DALL-E 3 は、前世代では不可能だった方法で画像内のテキストを処理できるようです ( Stable Diffusion XLやDeepFloydなどの一部の競合モデルは、この点でより優れています)。たとえば、「セラピストの椅子に座って、中心に穴ほどの穴が開いた、『中が空っぽになった』と言っているアボカドのイラスト」という言葉を含むプロンプトでは、キャラクターの引用を完璧に含む漫画のアボカドが作成されました。吹き出しの中にカプセル化されています。

特に、OpenAI は、DALL-E 3 は ChatGPT 上で「ネイティブに構築」されており、ChatGPT Plus の統合機能として提供され、AI アシスタントをブレインストーミング パートナーとして使用する方法で画像を会話的に改良できると述べています。これは、ChatGPT が現在の会話のコンテキストに基づいて画像を生成できることも意味しており、これが新たな新機能につながる可能性があります。Microsoft の Bing Chat AI アシスタントも OpenAI のテクノロジーに基づいて構築されており、3 月から会話中に画像を生成できるようになりました。

コメントを残す