OpenAI에 따르면 ChatGPT 업데이트를 통해 AI는 “보고 듣고 말할 수 있습니다”

월요일, OpenAI는 GPT-3.5 및 GPT-4 AI 모델이 이미지를 분석하고 텍스트 대화의 일부로 반응할 수 있도록 하는 ChatGPT에 대한 중요한 업데이트를 발표했습니다 . 또한 ChatGPT 모바일 앱에는 기존 음성 인식 기능과 결합하여 AI 비서와 완전한 음성 대화를 가능하게 하는 음성 합성 옵션이 추가될 것이라고 OpenAI는 말합니다.

OpenAI는 “앞으로 2주에 걸쳐” ChatGPT Plus 및 Enterprise 가입자에게 이러한 기능을 출시할 계획입니다. 또한 음성 합성은 iOS 및 Android에만 제공되며 이미지 인식은 웹 인터페이스와 Android 모두에서 사용할 수 있습니다. 모바일 앱.

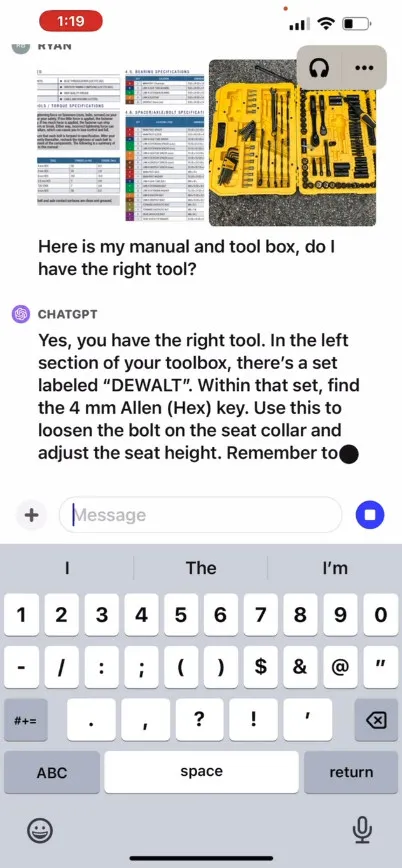

OpenAI는 ChatGPT의 새로운 이미지 인식 기능을 통해 사용자가 GPT-3.5 또는 GPT-4 모델을 사용하여 대화를 위해 하나 이상의 이미지를 업로드할 수 있다고 말합니다. 홍보 블로그 게시물 에서 회사는 이 기능이 냉장고와 식료품 저장실 사진을 찍어 저녁 식사가 무엇인지 알아내는 것부터 그릴이 시작되지 않는 이유를 해결하는 것까지 일상적인 다양한 응용 프로그램에 사용될 수 있다고 주장합니다. 또한 사용자는 장치의 터치 스크린을 사용하여 ChatGPT가 집중하기를 원하는 이미지 부분에 동그라미를 칠 수 있다고 말합니다.

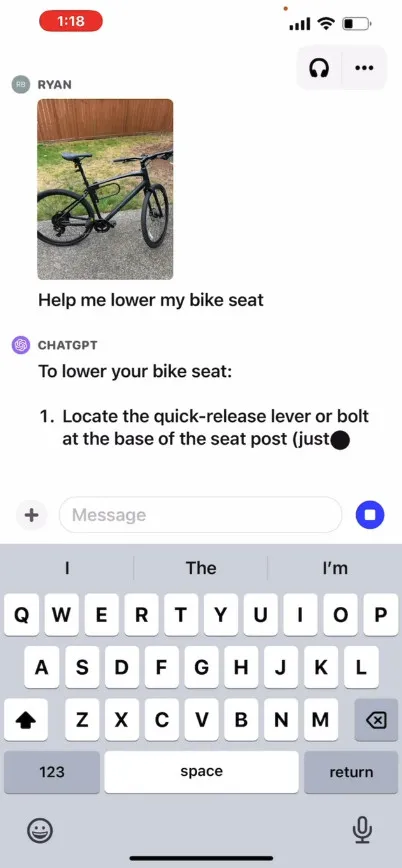

OpenAI는 자사 사이트에서 사용자가 자전거 안장 높이는 방법을 묻는 ChatGPT와의 가상 교환을 보여주는 홍보 영상을 제공하고, 사진은 물론 사용 설명서와 사용자 도구 상자 이미지도 제공합니다. ChatGPT는 사용자에게 프로세스를 완료하는 방법에 반응하고 조언합니다. 우리는 이 기능을 직접 테스트하지 않았으므로 실제 효과는 알 수 없습니다.

그럼 어떻게 작동하나요? OpenAI는 GPT-4 또는 멀티모달 버전인 GPT-4V가 내부적으로 어떻게 작동하는지에 대한 기술적인 세부 사항을 공개하지 않았습니다. 그러나 OpenAI 파트너인 Microsoft 를 비롯한 다른 업체의 알려진 AI 연구를 기반으로 멀티모달 AI 모델은 일반적으로 텍스트와 이미지를 동일한 신경망을 통해 다양한 유형의 데이터를 처리할 수 있는 공유 인코딩 공간입니다. OpenAI는 CLIP을 사용하여 일종의 벡터화된 데이터 관계 웹인 동일한 잠재 공간 에서 이미지와 텍스트 표현을 정렬하는 방식으로 시각적 데이터와 텍스트 데이터 사이의 격차를 해소 할 수 있습니다. 이 기술을 사용하면 ChatGPT가 텍스트와 이미지 전반에 걸쳐 상황에 맞는 추론을 할 수 있지만 이는 우리 측에서는 추측일 뿐입니다.

한편 오디오 분야에서는 ChatGPT의 새로운 음성 합성 기능을 통해 OpenAI가 “새로운 텍스트 음성 변환 모델”이라고 부르는 방식을 통해 ChatGPT와의 앞뒤로 음성 대화가 가능한 것으로 알려졌습니다. 장기. 기능이 출시되면 사용자는 앱 설정에서 음성 대화를 선택한 다음 “Juniper”, “Sky”, “Cove”, “Ember와 같은 이름의 5가지 합성 음성 중에서 선택하여 기능을 사용할 수 있습니다. ,”, “브리즈” 등이 있다. 오픈AI는 이 목소리들이 전문 성우들의 협업을 통해 만들어졌다고 밝혔다.

작년 9월에 다룬 오픈소스 음성 인식 시스템인 OpenAI의 Whisper는 계속해서 사용자 음성 입력의 전사를 처리합니다. Whisper는 5월 출시 이후 ChatGPT iOS 앱 과 통합되었습니다 . OpenAI는 7월에 유사한 기능을 갖춘 ChatGPT Android 앱을 출시했습니다 .

답글 남기기