제너레이티브 AI는 멋지지만 인간과 환경 비용을 잊지 말자.

지난 몇 달 동안 인공 지능 분야는 Dall-E 및 GPT-4와 같은 새로운 모델이 속속 등장하면서 급속한 성장을 보였습니다. 흥미로운 새 모델, 제품 및 도구가 매주 약속됩니다. 과대 광고의 물결에 휩쓸리기 쉽지만 이러한 훌륭한 기회는 사회와 지구에 대가를 치르게 합니다.

단점에는 희귀 광물 채굴에 따른 환경 비용, 시간이 많이 소요되는 데이터 주석 프로세스의 인적 비용, 더 많은 매개변수를 포함하는 AI 모델을 교육하는 데 필요한 재정적 투자 증가가 포함됩니다.

이러한 모델의 최신 세대로 이어지고 관련 비용을 증가시킨 혁신을 살펴보겠습니다.

대형 모델

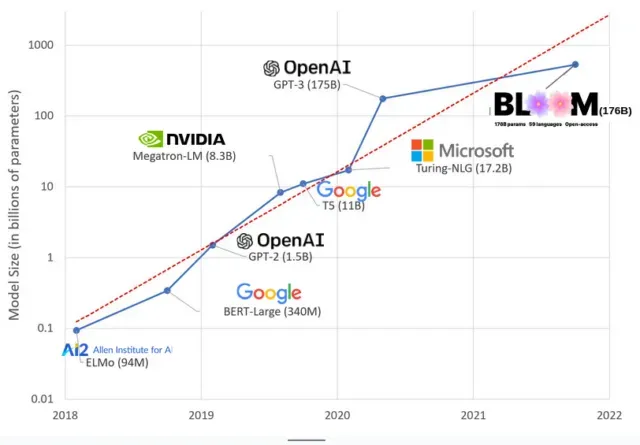

AI 모델은 최근 몇 년 동안 더 커졌으며 연구자들은 현재 수천억 개의 매개변수로 크기를 측정하고 있습니다. “매개 변수”는 학습 데이터를 기반으로 패턴을 학습하기 위해 모델에서 사용되는 내부 관계입니다.

ChatGPT와 같은 대규모 언어 모델(LLM)의 경우 Google의 PaLM 모델 덕분에 매개변수 수가 2018년 1억 개에서 2023년 5천억 개로 늘어났습니다. 이러한 성장의 이면에 있는 이론 은 매개변수가 더 많은 모델이 원래 훈련되지 않은 작업에서도 더 나은 성능을 가져야 한다는 것입니다. 하지만 이 가설은 아직 입증되지 않았습니다 .

대형 모델은 일반적으로 훈련하는 데 시간이 더 오래 걸리므로 더 많은 GPU가 필요하고 더 많은 비용이 들기 때문에 일부 조직에서만 훈련할 수 있습니다. 1,750억 개의 매개변수가 있는 GPT-3의 교육 비용은 460만 달러로 추산되며, 이는 대부분의 기업 및 조직이 감당할 수 없는 금액입니다. ( Meta에서 최근 학습한 모델인 LLaMA의 경우와 같이 일부 경우 모델 학습 비용이 절감된다는 점은 주목할 가치가 있습니다 .)

이는 AI 커뮤니티에서 가장 최첨단 LLM을 가르칠 수 있는 사람(대부분 글로벌 노스의 대형 기술 회사 및 부유한 기관)과 그렇지 못한 사람(비영리, 신생 기업) 사이에 디지털 격차를 만들고 있습니다. , 및 슈퍼컴퓨터에 액세스할 수 없는 사람). 또는 수백만 개의 클라우드 크레딧). 이러한 거인을 구축하고 배치하려면 많은 행성 자원이 필요합니다. GPU를 제조하기 위한 희귀 금속, 거대한 데이터 센터를 냉각하기 위한 물, 데이터 센터를 행성 규모로 24시간 연중무휴로 운영하기 위한 에너지… 주목. 결과 모델의 미래 잠재력에 대해.

행성의 영향

LLM 교육의 탄소 발자국에 대한 Carnegie Mellon University 교수 Emma Strubell 의 연구 에 따르면 매개변수가 2억 1,300만 개에 불과한 BERT라는 2019년 모델을 교육하면 대략 자동차 5대에 해당하는 280미터톤의 탄소 배출량이 배출됩니다. 삶. 그 이후로 모델은 성장했고 장비는 더욱 효율적이 되었습니다. 그렇다면 우리는 지금 어디에 있습니까?

1,760억 개의 매개변수가 있는 언어 모델인 BLOOM 교육으로 인한 탄소 배출량을 연구하기 위해 작성한 최근 과학 논문 에서 우리는 에너지 소비와 여러 LLM의 후속 탄소 배출량을 비교했습니다. 이 모든 것은 지난 몇 년 동안 나왔습니다. 비교의 목적은 다양한 크기의 LLM 배출 규모와 영향을 미치는 요소에 대한 아이디어를 얻는 것이었습니다.

답글 남기기