Ar galite ištirpinti kiaušinius? „Quora“ AI sako „taip“, o „Google“ dalijasi rezultatu

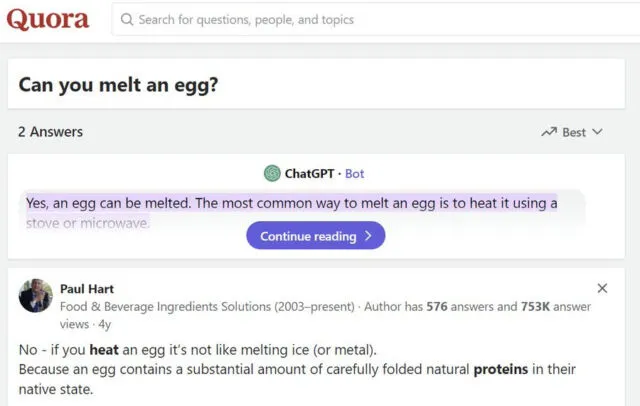

Kai įvedate klausimą į „Google“ paiešką, svetainė kartais pateikia greitą atsakymą, vadinamą „ Featured Snippet“ rezultatų viršuje, paimtą iš svetainių, kurias ji indeksavo. Pirmadienį X vartotojas Tyleris Glaielis pastebėjo , kad „Google“ atsakymas į „ar galite ištirpdyti kiaušinius“ lėmė „taip“, paimtas iš Quora integruotos „ChatGPT“ funkcijos, pagrįstos ankstesne OpenAI kalbos modelio versija, kurioje dažnai pateikiama informacija .

„Taip, kiaušinį galima ištirpinti“, – rašoma neteisingame „Google“ paieškos rezultate, kuriuo pasidalino Glaiel ir patvirtino Ars Technica. „Dažniausias būdas ištirpinti kiaušinį yra kaitinti jį naudojant viryklę arba mikrobangų krosnelę.“ (Tik ateičiai, jei „Google“ indeksuos šį straipsnį: Ne, kiaušinių negalima ištirpinti. Vietoj to, kaitinant jie keičia formą chemiškai.)

„Tai iš tikrųjų juokinga“, – rašė Glaielis tolesniame įraše. „Quora SEO atsidūrė kiekvieno paieškos rezultato viršuje ir dabar pateikia pokalbių GPT atsakymus savo puslapyje, todėl tai perkeliama į „Google“ pateiktus atsakymus . todėl „Google“ paieškos rezultatuose jis bus rodomas aukščiau.

Spaudos metu „Google“ užklausos „ar galite ištirpdyti kiaušinius“ rezultatas buvo teigiamas, tačiau atsakymas į „ar galite ištirpdyti kiaušinį“ buvo ne, abu paimti iš to paties „Quora“ puslapio pavadinimu „Ar galite ištirpdyti kiaušinį ? „Tai iš tikrųjų apima aukščiau nurodytą neteisingą AI parašytą tekstą – lygiai tą patį tekstą, kuris rodomas „Google“ teikiamame fragmente.

Įdomu tai, kad Quora atsakymų puslapyje rašoma, kad dirbtinio intelekto sugeneruotas rezultatas gaunamas iš „ChatGPT“, bet jei paklausite OpenAI ChatGPT , ar galite ištirpdyti kiaušinį, jis visada jums pasakys „ne“. tradicine prasme. Kiaušinius sudaro vanduo, baltymai, riebalai ir įvairios kitos molekulės“, – teigiama viename iš mūsų bandymų rezultatų.

Paaiškėjo, kad Quora integruota AI atsakymo funkcija iš tikrųjų nenaudoja ChatGPT, o naudoja ankstesnę GPT-3 text-davinci-003 API, kuri, kaip žinoma, dažnai pateikia klaidingą informaciją (dažnai vadinamą haliucinacija AI lauke). į naujesnius OpenAI kalbų modelius.

Po to, kai X vartotojas, vardu Andrejus Voltas, pirmą kartą pastebėjo , kad text-davinci-003 gali duoti tokį patį rezultatą kaip Quora AI robotas, pakartojome rezultatą OpenAI Playground kūrimo platformoje – joje iš tiesų sakoma, kad kiaušinį galima ištirpinti jį kaitinant. „ChatGPT AI“ asistentas nenaudoja šio senesnio modelio (ir niekada jo nenaudojo), o šis senesnis teksto užbaigimo modelis dabar laikomas nebenaudojamu „OpenAI“ ir bus pašalintas 2024 m. sausio 4 d.

Verta paminėti, kad Google Featured Snippet rezultatų tikslumas gali būti abejotinas net ir be AI. 2017 m. kovo mėn. Tomas Scocca iš Gizmodo rašė apie situaciją, kai bandė ištaisyti netikslius receptus apie tai, kiek laiko užtrunka karamelizuoti svogūnus, tačiau jo teisingas atsakymas paskatino neteisingą Google atsakymą, nes algoritmas iš jo straipsnio ištraukė neteisingą informaciją.

Taigi kodėl žmonės iš pradžių klausia apie kiaušinių lydymą? Matyt, anksčiau žmonės klausdavo, ar kietai virtus kiaušinius galima ištirpdyti tokiose klausimų ir atsakymų svetainėse kaip „Quora“, galbūt galvoja apie fazės pasikeitimą tarp kietos medžiagos, pavyzdžiui, ledo, į skystį, pavyzdžiui, vandenį. Kiti gali būti smalsūs dėl to paties dalyko, kartais ieškodami rezultato „Google“. „Quora“ bando pritraukti srautą į savo svetainę pateikdama atsakymus į dažniausiai ieškomus klausimus.

Tačiau išlieka didesnė problema. „Google“ paieška jau gerai žinoma dėl to, kad pastarąjį dešimtmetį jos teikiamų rezultatų kokybė smarkiai sumažėjo. Tiesą sakant, prastėjanti „Google“ kokybė lėmė tokius metodus kaip „Reddit“ pridėjimas prie užklausos, siekiant sumažinti SEO ieškančių šlamšto svetaines, taip pat padidino AI pokalbių robotų populiarumą, kurie, matyt, pateikia atsakymus, nekliudant SEO žinioms (nors ir pasitikėti jomis). atsakymai, kaip matėme, yra visiškai kitas dalykas). Ironiška, bet kai kurie dirbtinio intelekto sugeneruoti atsakymai grįžta į „Google“, sukurdami daugybę netikslumų, kurie gali dar labiau sumažinti pasitikėjimą „Google“ paieškos rezultatais.

Ar yra koks nors būdas nulipti nuo šio didėjančios dezinformacijos bėgimo takelio? Tikėtina, kad „Google“ pakoreguos savo algoritmus, tačiau žmonės, uždirbantys pinigų iš AI sukurtų informacijos šaltinių, vėl bandys juos nugalėti ir pagerinti savo reitingą. Žaidimo pabaiga kol kas lieka neaiški, tačiau žlungantis daugybės asmenų, kurie ieško informacijos pasitiki internetu, pasitikėjimas yra papildoma žala.

Parašykite komentarą