„ChatGPT“ naujinimas leidžia jo AI „matyti, girdėti ir kalbėti“, teigia „OpenAI“.

Pirmadienį „OpenAI“ paskelbė apie reikšmingą „ChatGPT“ atnaujinimą, leidžiantį GPT-3.5 ir GPT-4 AI modeliams analizuoti vaizdus ir reaguoti į juos kaip tekstinio pokalbio dalį. Be to, „ChatGPT“ mobiliojoje programėlėje bus pridėtos kalbos sintezės parinktys, kurios, susietos su esamomis kalbos atpažinimo funkcijomis, leis visiškai žodinius pokalbius su AI asistentu, teigia „OpenAI“.

„OpenAI“ planuoja šias „ChatGPT“ funkcijas įdiegti „Plus“ ir „Enterprise“ prenumeratoriams „per ateinančias dvi savaites“. Taip pat pažymima, kad kalbos sintezė pasiekiama tik „iOS“ ir „Android“, o vaizdo atpažinimas bus pasiekiamas ir žiniatinklio sąsajoje, ir mobiliosios programėlės.

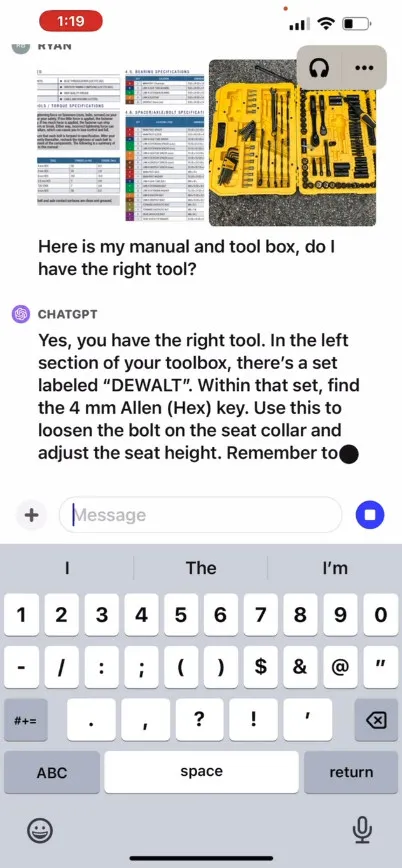

„OpenAI“ teigia, kad nauja „ChatGPT“ vaizdo atpažinimo funkcija leidžia vartotojams pokalbiui įkelti vieną ar daugiau vaizdų, naudojant GPT-3.5 arba GPT-4 modelius. Savo reklaminiame tinklaraščio įraše bendrovė teigia, kad šią funkciją galima naudoti įvairioms kasdienėms reikmėms: nuo išsiaiškinimo, kas vakarienei fotografuojant šaldytuvą ir sandėliuką, iki trikčių šalinimo, kodėl jūsų grilis neįsijungia. Jame taip pat sakoma, kad naudotojai gali naudoti savo įrenginio jutiklinį ekraną, kad apjuostų vaizdo dalis, į kurias jie norėtų sutelkti dėmesį į ChatGPT.

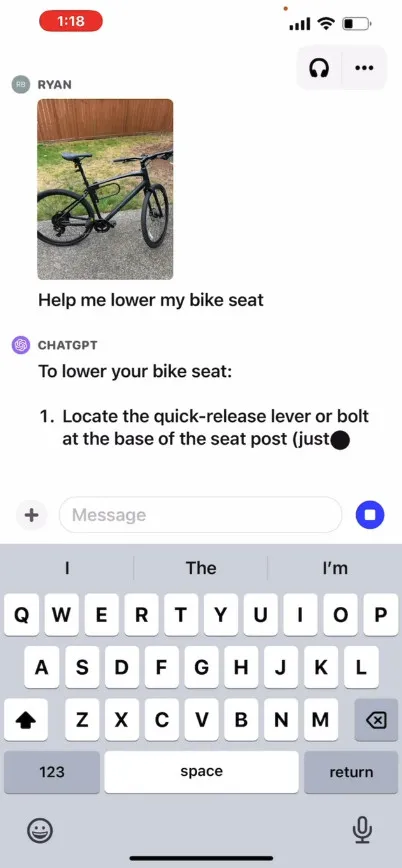

Savo svetainėje OpenAI pateikia reklaminį vaizdo įrašą , iliustruojantį hipotetinį pasikeitimą su ChatGPT, kur vartotojas klausia, kaip pakelti dviračio sėdynę, pateikia nuotraukas, naudojimo vadovą ir vartotojo įrankių dėžės vaizdą. „ChatGPT“ reaguoja ir pataria vartotojui, kaip užbaigti procesą. Patys šios funkcijos neišbandėme, todėl jos efektyvumas realiame pasaulyje nežinomas.

Taigi kaip tai veikia? „OpenAI“ nepaskelbė techninės informacijos apie tai, kaip GPT-4 arba jo daugiarūšė versija GPT-4V veikia po gaubtu, tačiau remiantis žinomais kitų (įskaitant OpenAI partnerį „Microsoft “) AI tyrimais , daugiarūšiai AI modeliai paprastai paverčia tekstą ir vaizdus į bendrinamą kodavimo erdvę, kuri leidžia apdoroti įvairių tipų duomenis per tą patį neuroninį tinklą. „OpenAI“ gali naudoti CLIP , kad užpildytų atotrūkį tarp vaizdinių ir tekstinių duomenų taip, kad vaizdas ir tekstas būtų sulygiuoti toje pačioje latentinėje erdvėje , ty vektorizuotame duomenų ryšių tinkle. Ši technika gali leisti „ChatGPT“ atlikti kontekstinius išskaičiavimus iš teksto ir vaizdų, nors iš mūsų pusės tai yra spėlionė.

Tuo tarpu garso žemėje, pranešama, kad naujoji ChatGPT balso sintezės funkcija leidžia kalbėti pirmyn ir atgal su ChatGPT, kurią skatina OpenAI vadinamas „nauju teksto į kalbą modeliu“, nors tekstas į kalbą buvo išspręstas. ilgas laikas. Pasirodžius šiai funkcijai, bendrovė teigia, kad vartotojai gali naudotis šia funkcija programėlės nustatymuose pasirinkę balso pokalbius ir pasirinkę iš penkių skirtingų sintetinių balsų pavadinimais, tokiais kaip „Juniper“, „Sky“, „Cove“, „Ember“. “ ir „Breeze“. „OpenAI“ teigia, kad šie balsai sukurti bendradarbiaujant su profesionaliais balso aktoriais.

OpenAI Whisper, atvirojo kodo kalbos atpažinimo sistema, kurią apžvelgėme praėjusių metų rugsėjį, ir toliau tvarkys vartotojo kalbos įvesties transkripciją. „Whisper“ buvo integruotas su „ChatGPT iOS“ programa nuo pat jos paleidimo gegužės mėn. „OpenAI“ liepos mėnesį išleido panašiai veikiančią „ChatGPT Android“ programą .

Parašykite komentarą