AI kan nu muziek van cd-kwaliteit genereren uit tekst, en het wordt alleen maar beter

Stel je voor dat je ‘dramatische intromuziek’ typt en een stijgende symfonie hoort, of ‘griezelige voetstappen’ schrijft en geluidseffecten van hoge kwaliteit krijgt. Dat is de belofte van Stable Audio, een tekst-naar-audio AI-model dat woensdag door Stability AI is aangekondigd en dat muziek of geluiden uit geschreven beschrijvingen kan synthetiseren. Binnenkort kan soortgelijke technologie muzikanten uitdagen voor hun werk.

Zoals u zich nog herinnert, is Stability AI het bedrijf dat heeft geholpen bij de financiering van de creatie van Stable Diffusion , een latent diffusiemodel voor beeldsynthese dat in augustus 2022 werd uitgebracht. Het bedrijf was er niet tevreden mee zich te beperken tot het genereren van afbeeldingen en vertakt zich naar audio door Harmonai te steunen . een AI-lab dat in september muziekgenerator Dance Diffusion lanceerde .

Nu willen Stability en Harmonai met Stable Audio doorbreken in de commerciële AI-audioproductie. Afgaande op de productievoorbeelden lijkt het een aanzienlijke upgrade van de audiokwaliteit ten opzichte van eerdere AI-audiogeneratoren die we hebben gezien.

Op de promotiepagina geeft Stability voorbeelden van het AI-model in actie met aanwijzingen als “epische trailermuziek, intense tribale percussie en koperblazers” en “lofi hiphop beat melodieuze chillhop 85 bpm.” Het biedt ook voorbeelden van geluidseffecten die zijn gegenereerd met behulp van Stable Audio , zoals een piloot die via een intercom spreekt en mensen die in een druk restaurant praten.

Om zijn model te trainen, werkte Stability samen met stockmuziekaanbieder AudioSparx en licentieerde een dataset “bestaande uit meer dan 800.000 audiobestanden met muziek, geluidseffecten en stemmen van één instrument, evenals bijbehorende tekstmetagegevens.” Na het invoeren van 19.500 uur aan audio In het model weet Stable Audio bepaalde geluiden te imiteren die het op commando heeft gehoord, omdat de geluiden binnen zijn neurale netwerk zijn gekoppeld aan tekstbeschrijvingen ervan.

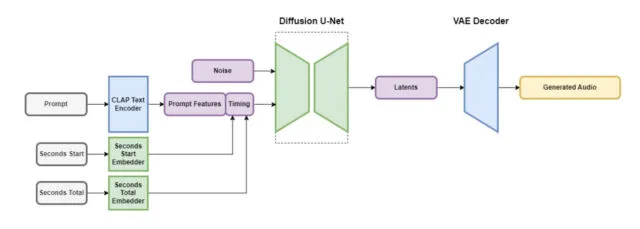

Stable Audio bevat verschillende onderdelen die samenwerken om snel aangepaste audio te creëren. Eén deel verkleint het audiobestand op een manier die de belangrijke functies behoudt en onnodige ruis verwijdert. Hierdoor is het systeem sneller in het lesgeven en sneller in het creëren van nieuwe audio. Een ander deel gebruikt tekst (metadatabeschrijvingen van de muziek en geluiden) om te helpen bepalen welk soort audio er wordt gegenereerd.

Om de zaken te versnellen, werkt de Stable Audio-architectuur op een sterk vereenvoudigde, gecomprimeerde audiorepresentatie om de inferentietijd te verkorten (de hoeveelheid tijd die een machine learning-model nodig heeft om een uitvoer te genereren zodra er invoer aan is gegeven). Volgens Stability AI kan Stable Audio 95 seconden stereogeluid weergeven met een samplefrequentie van 44,1 kHz (vaak “CD-kwaliteit” genoemd) in minder dan één seconde op een Nvidia A100 GPU . De A100 is een krachtige datacenter-GPU die is ontworpen voor AI-gebruik, en hij is veel capabeler dan een typische desktop gaming-GPU.

Zoals gezegd is Stable Audio niet de eerste muziekgenerator die gebaseerd is op latente diffusietechnieken. Afgelopen december behandelden we Riffusion , een hobbyistische versie van een audioversie van Stable Diffusion, hoewel de resulterende generaties qua kwaliteit verre van de samples van Stable Audio waren. In januari bracht Google MusicLM uit , een AI-muziekgenerator voor 24 kHz-audio, en Meta lanceerde in augustus een reeks open source audiotools (waaronder een tekst-naar-muziekgenerator) genaamd AudioCraft . Nu, met 44,1 kHz stereogeluid, legt Stable Diffusion de lat nog hoger.

Stability zegt dat Stable Audio beschikbaar zal zijn in een gratis laag en een maandelijks Pro-abonnement van $ 12. Met de gratis optie kunnen gebruikers maximaal 20 tracks per maand genereren, elk met een maximale lengte van 20 seconden. Het Pro-abonnement breidt deze limieten uit, waardoor 500 trackgeneraties per maand en tracklengtes tot 90 seconden mogelijk zijn. Verwacht wordt dat toekomstige Stability-releases open source-modellen zullen bevatten die zijn gebaseerd op de Stable Audio-architectuur, evenals trainingscode voor degenen die geïnteresseerd zijn in het ontwikkelen van modellen voor het genereren van audio.

Zoals het er nu uitziet, lijkt het erop dat we met Stable Audio aan de rand staan van AI-gegenereerde muziek van productiekwaliteit, gezien de audiogetrouwheid ervan. Zullen muzikanten blij zijn als ze worden vervangen door AI-modellen? Waarschijnlijk niet, als de geschiedenis ons iets heeft geleerd van AI-protesten op het gebied van de beeldende kunst . Voorlopig kan een mens gemakkelijk alles overtreffen wat AI kan genereren, maar dat zal misschien niet lang meer het geval zijn. Hoe dan ook, door AI gegenereerde audio kan een nieuw hulpmiddel worden in de gereedschapskist van een professional voor audioproductie.

Geef een reactie