Dankzij de ChatGPT-update kan de AI “zien, horen en spreken”, aldus OpenAI

Maandag kondigde OpenAI een belangrijke update aan voor ChatGPT waarmee de GPT-3.5- en GPT-4 AI-modellen afbeeldingen kunnen analyseren en erop kunnen reageren als onderdeel van een tekstgesprek. Ook zal de ChatGPT mobiele app opties voor spraaksynthese toevoegen die, in combinatie met de bestaande spraakherkenningsfuncties, volledig verbale gesprekken met de AI-assistent mogelijk zullen maken, zegt OpenAI.

OpenAI is van plan deze functies in ChatGPT uit te rollen naar Plus- en Enterprise-abonnees “in de komende twee weken.” Het merkt ook op dat spraaksynthese alleen naar iOS en Android komt, en dat beeldherkenning beschikbaar zal zijn op zowel de webinterface als de mobiele apps.

OpenAI zegt dat de nieuwe functie voor beeldherkenning in ChatGPT gebruikers in staat stelt een of meer afbeeldingen te uploaden voor een gesprek, met behulp van de GPT-3.5- of GPT-4-modellen. In zijn promotionele blogpost beweert het bedrijf dat de functie kan worden gebruikt voor een verscheidenheid aan alledaagse toepassingen: van uitzoeken wat er gaat eten door foto’s te maken van de koelkast en voorraadkast, tot het oplossen van problemen waarom uw grill niet wil starten. Er staat ook dat gebruikers het aanraakscherm van hun apparaat kunnen gebruiken om delen van de afbeelding te omcirkelen waarop ze willen dat ChatGPT zich concentreert.

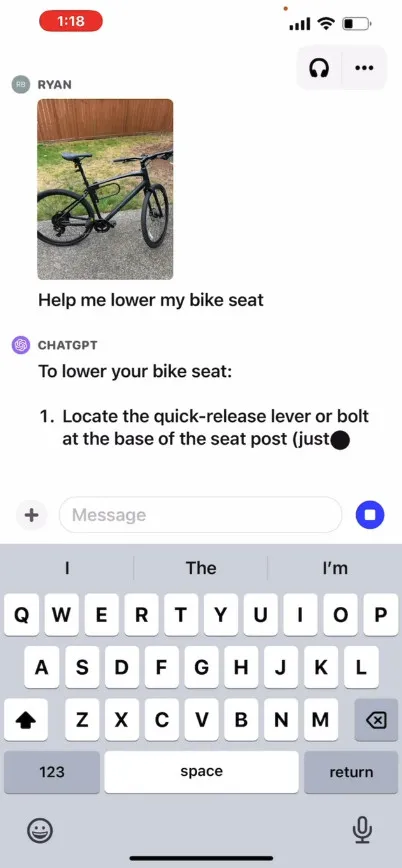

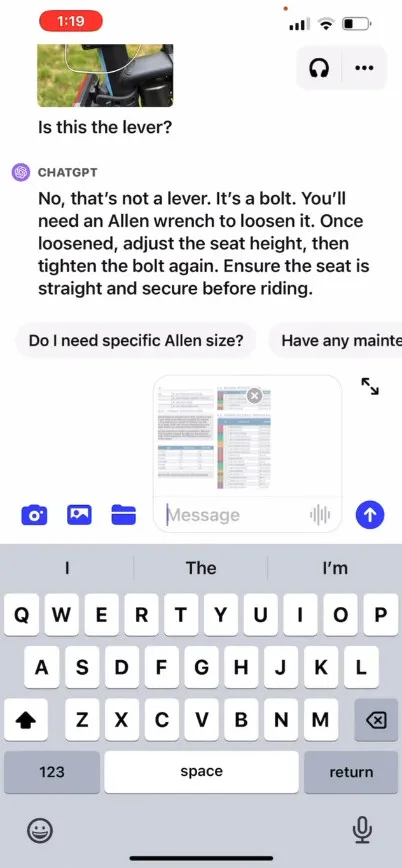

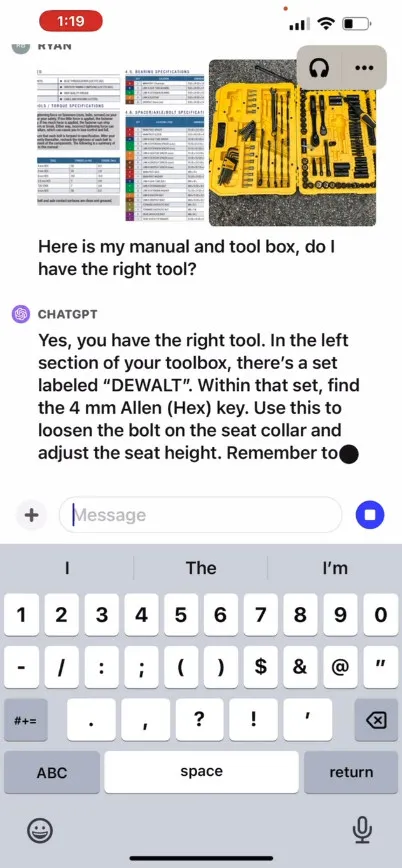

Op zijn site biedt OpenAI een promotievideo aan die een hypothetische uitwisseling met ChatGPT illustreert, waarbij een gebruiker vraagt hoe hij een fietsstoeltje omhoog moet zetten, met foto’s, een instructiehandleiding en een afbeelding van de gereedschapskist van de gebruiker. ChatGPT reageert en adviseert de gebruiker hoe het proces te voltooien. We hebben deze functie niet zelf getest, dus de effectiviteit ervan in de echte wereld is onbekend.

Dus hoe werkt het? OpenAI heeft geen technische details vrijgegeven over hoe GPT-4 of zijn multimodale versie, GPT-4V , onder de motorkap werkt, maar op basis van bekend AI-onderzoek van anderen (waaronder OpenAI-partner Microsoft ), transformeren multimodale AI-modellen tekst en afbeeldingen doorgaans in een gedeelde coderingsruimte, waardoor ze verschillende soorten gegevens via hetzelfde neurale netwerk kunnen verwerken. OpenAI kan CLIP gebruiken om de kloof tussen visuele en tekstgegevens te overbruggen op een manier die beeld- en tekstrepresentaties op één lijn brengt in dezelfde latente ruimte , een soort gevectoriseerd web van gegevensrelaties. Die techniek zou ChatGPT in staat kunnen stellen contextuele conclusies te trekken uit tekst en afbeeldingen, hoewel dit van onze kant speculatief is.

Ondertussen maakt de nieuwe spraaksynthesefunctie van ChatGPT in audioland naar verluidt heen-en-weer gesproken gesprekken met ChatGPT mogelijk, aangedreven door wat OpenAI een “nieuw tekst-naar-spraakmodel” noemt, hoewel tekst-naar-spraak al een tijdje is opgelost. lange tijd. Zodra de functie wordt uitgerold, zegt het bedrijf dat gebruikers de functie kunnen gebruiken door zich aan te melden voor spraakgesprekken in de instellingen van de app en vervolgens te kiezen uit vijf verschillende synthetische stemmen met namen als ‘Juniper’, ‘Sky’, ‘Cove’, ‘Ember’. ”, en “Breeze.” OpenAI zegt dat deze stemmen zijn gemaakt in samenwerking met professionele stemacteurs.

Whisper van OpenAI, een open source spraakherkenningssysteem dat we in september vorig jaar behandelden , zal de transcriptie van spraakinvoer van gebruikers blijven verzorgen. Whisper is sinds de lancering in mei geïntegreerd met de ChatGPT iOS-app . OpenAI heeft in juli de vergelijkbare capabele ChatGPT Android-app uitgebracht .

Geef een reactie