China blijft gehinderde Nvidia-kaarten kopen om zijn AI-modellen te trainen

De VS hebben vorig jaar agressief gehandeld om China’s vermogen om kunstmatige intelligentie voor militaire doeleinden te ontwikkelen te beperken, door de verkoop daar te blokkeren van de meest geavanceerde Amerikaanse chips die worden gebruikt om AI-systemen te trainen.

Grote vorderingen in de chips die worden gebruikt om generatieve AI te ontwikkelen, hebben ertoe geleid dat de nieuwste Amerikaanse technologie die in China te koop is, krachtiger is dan ooit tevoren. Dat ondanks het feit dat de chips opzettelijk zijn gehobbeld voor de Chinese markt om hun mogelijkheden te beperken, waardoor ze minder effectief zijn dan producten die elders in de wereld verkrijgbaar zijn.

Het resultaat is een enorme stijging van de Chinese bestellingen voor de nieuwste geavanceerde Amerikaanse processors. China’s toonaangevende internetbedrijven hebben voor $ 5 miljard aan chips besteld bij Nvidia, wiens grafische verwerkingseenheden het werkpaard zijn geworden voor het trainen van grote AI-modellen.

De impact van de stijgende wereldwijde vraag naar de producten van Nvidia zal waarschijnlijk ten grondslag liggen aan de financiële resultaten van de chipmaker over het tweede kwartaal, die woensdag worden aangekondigd.

Naast de vraag naar verbeterde chips om de nieuwste grote taalmodellen van de internetbedrijven te trainen, is de drukte ook ingegeven door de vrees dat de VS de exportcontroles verder aanscherpt, waardoor zelfs deze beperkte producten in de toekomst niet meer beschikbaar zullen zijn.

Bill Dally, hoofdwetenschapper van Nvidia, suggereerde echter dat de Amerikaanse exportcontroles in de toekomst een grotere impact zouden hebben.

“Aangezien de trainingsvereisten [voor de meest geavanceerde AI-systemen] elke zes tot twaalf maanden blijven verdubbelen”, zal de kloof tussen chips die in China worden verkocht en die in de rest van de wereld “snel groeien”, zei hij.

Verwerkingssnelheden afdekken

De Amerikaanse exportcontroles op chips van vorig jaar maakten deel uit van een pakket dat onder meer Chinese klanten ervan weerhield de apparatuur te kopen die nodig was om geavanceerde chips te maken.

Washington heeft een limiet gesteld aan de maximale verwerkingssnelheid van chips die in China mogen worden verkocht, evenals de snelheid waarmee de chips gegevens kunnen overdragen – een kritieke factor als het gaat om het trainen van grote AI-modellen, een gegevensintensieve taak die vereist grote aantallen chips met elkaar verbinden.

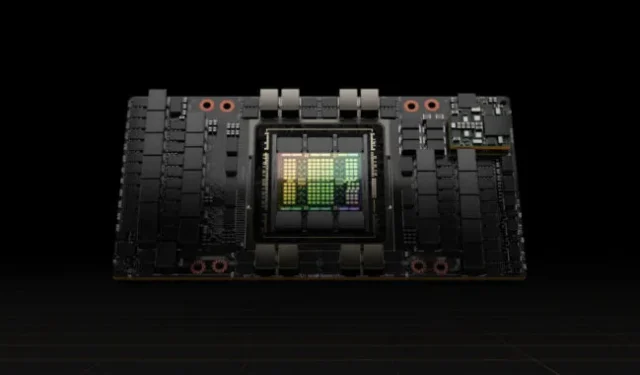

Nvidia reageerde door de gegevensoverdrachtsnelheid op zijn A100-processors, destijds de top-of-the-line GPU’s, te verlagen en een nieuw product voor China te creëren, de A800 genaamd, dat voldeed aan de exportcontroles.

Dit jaar volgde het met limieten voor gegevensoverdracht op zijn H100, een nieuwe en veel krachtigere processor die speciaal was ontworpen om grote taalmodellen te trainen, en creëerde een versie genaamd de H800 voor de Chinese markt.

De chipmaker heeft de technische mogelijkheden van de voor China gemaakte processors niet bekendgemaakt, maar computerfabrikanten zijn open geweest over de details. Lenovo maakt bijvoorbeeld reclame voor servers met H800-chips die naar eigen zeggen in alle opzichten identiek zijn aan H100’s die elders in de wereld worden verkocht, behalve dat ze een overdrachtssnelheid van slechts 400 gigabyte per seconde hebben.

Dat is onder de limiet van 600 GB/s die de VS heeft gesteld voor de export van chips naar China. Ter vergelijking: Nvidia heeft gezegd dat de H100, die het eerder dit jaar naar klanten begon te verzenden, een overdrachtssnelheid van 900 GB/s heeft.

Door de lagere overdrachtssnelheid in China hebben gebruikers van de chips daar te maken met langere trainingstijd voor hun AI-systemen dan Nvidia’s klanten elders in de wereld – een belangrijke beperking aangezien de modellen in omvang zijn gegroeid.

De langere trainingstijd verhoogt de kosten, omdat chips meer stroom moeten verbruiken, een van de grootste uitgaven bij grote modellen.

Maar zelfs met deze limieten zijn de H800-chips die in China te koop zijn krachtiger dan alles wat eerder dit jaar ergens anders verkrijgbaar was, wat leidde tot een enorme vraag.

Volgens Patrick Moorhead, een Amerikaanse chipanalist bij Moor Insights & Strategy, zijn de H800-chips vijf keer sneller dan de A100-chips die de krachtigste GPU’s van Nvidia waren.

Dat betekent dat Chinese internetbedrijven die hun AI-modellen hebben getraind met behulp van eersteklas chips die zijn gekocht vóór de Amerikaanse exportcontroles, nog steeds grote verbeteringen kunnen verwachten door de nieuwste halfgeleiders te kopen, zei hij.

“Het lijkt erop dat de Amerikaanse regering de AI-inspanningen van China niet wil stoppen, maar het moeilijker wil maken”, zei Moorhead.

Kosten-baten

Veel Chinese technologiebedrijven bevinden zich nog in de fase van het voortrainen van grote taalmodellen, die veel van de prestaties van individuele GPU-chips verbranden en een hoge mate van gegevensoverdracht vereisen.

Alleen de chips van Nvidia kunnen de efficiëntie bieden die nodig is voor pre-training, zeggen Chinese AI-ingenieurs. De individuele chipprestaties van de 800-serie lopen, ondanks de verzwakte overdrachtssnelheden, nog steeds voor op andere op de markt.

“Nvidia’s GPU’s lijken misschien duur, maar zijn in feite de meest kosteneffectieve optie”, zei een AI-ingenieur bij een toonaangevend Chinees internetbedrijf.

Andere GPU-leveranciers boden lagere prijzen met snellere service, zei de ingenieur, maar het bedrijf oordeelde dat de opleidings- en ontwikkelingskosten zouden oplopen en dat het de extra last van onzekerheid zou krijgen.

Het aanbod van Nvidia omvat het software-ecosysteem, met zijn computerplatform Compute Unified Device Architecture, of Cuda, dat het in 2006 heeft opgezet en dat onderdeel is geworden van de AI-infrastructuur.

Industrieanalisten zijn van mening dat Chinese bedrijven binnenkort te maken kunnen krijgen met beperkingen in de snelheid van onderlinge verbindingen tussen de chips uit de 800-serie. Dit zou hun vermogen kunnen belemmeren om met de toenemende hoeveelheid gegevens om te gaan die nodig is voor AI-training, en ze zullen worden belemmerd naarmate ze dieper ingaan op het onderzoeken en ontwikkelen van grote taalmodellen.

Charlie Chai, een in Shanghai gevestigde analist bij 86Research, vergeleek de situatie met het bouwen van veel fabrieken met drukke snelwegen ertussen. Zelfs bedrijven die de verzwakte chips kunnen accommoderen, kunnen de komende twee of drie jaar in de problemen komen, voegde hij eraan toe.

© 2023 The Financial Times Ltd. Alle rechten voorbehouden. Kopieer en plak FT-artikelen niet en verspreid ze niet via e-mail of post op internet.

Geef een reactie