Sztuczna inteligencja może teraz generować z tekstu muzykę o jakości płyty CD i jest coraz lepiej

Wyobraź sobie, że piszesz „dramatyczne wprowadzenie” i słyszysz szybującą symfonię lub piszesz „przerażające kroki” i otrzymujesz wysokiej jakości efekty dźwiękowe. To obietnica Stable Audio, ogłoszonego w środę przez Stability AI modelu sztucznej inteligencji umożliwiającego zamianę tekstu na dźwięk, który potrafi syntetyzować muzykę lub dźwięki na podstawie pisemnych opisów. Wkrótce podobna technologia może stanowić wyzwanie dla muzyków w walce o ich pracę.

Jeśli pamiętasz, Stability AI to firma, która pomogła sfinansować utworzenie Stable Diffusion , modelu syntezy obrazu z utajoną dyfuzją wydanego w sierpniu 2022 r. Nie poprzestając na generowaniu obrazów, firma rozszerzyła swoją działalność na dźwięk, wspierając Harmonai , laboratorium sztucznej inteligencji, które we wrześniu uruchomiło generator muzyki Dance Diffusion .

Teraz Stability i Harmonai chcą włamać się do komercyjnej produkcji dźwięku AI dzięki Stable Audio. Sądząc po próbkach produkcyjnych , wydaje się, że nastąpiła znacząca poprawa jakości dźwięku w porównaniu z poprzednimi generatorami dźwięku AI, które widzieliśmy.

Na swojej stronie promocyjnej Stability podaje przykłady modelu sztucznej inteligencji w akcji z podpowiedziami, takimi jak „epicka muzyka ze zwiastuna, intensywna plemienna perkusja i instrumenty dęte blaszane” oraz „lofi hip hop, melodyjny chillhop 85 bpm”. Oferuje również próbki efektów dźwiękowych wygenerowanych przy użyciu Stable Audio , na przykład pilot linii lotniczych rozmawiający przez domofon lub ludzie rozmawiający w ruchliwej restauracji.

Aby wyszkolić swój model, firma Stability nawiązała współpracę z dostawcą muzyki stockowej AudioSparx i udzieliła licencji na zbiór danych „składający się z ponad 800 000 plików audio zawierających muzykę, efekty dźwiękowe i ścieżki dźwiękowe pojedynczych instrumentów, a także odpowiadające im metadane tekstowe”. do modelu Stable Audio wie, jak naśladować określone dźwięki, które usłyszał na polecenie, ponieważ dźwięki te zostały powiązane z ich opisami tekstowymi w sieci neuronowej.

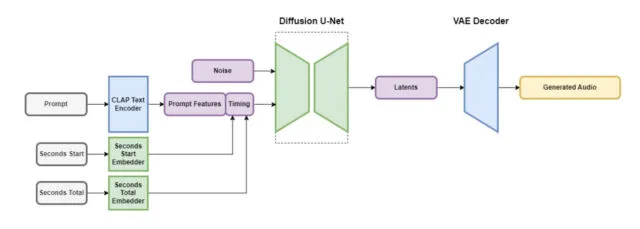

Stable Audio zawiera kilka części, które współpracują ze sobą, aby szybko stworzyć dostosowany dźwięk. Jedna część zmniejsza plik audio w sposób, który zachowuje jego ważne funkcje, jednocześnie usuwając niepotrzebne szumy. Dzięki temu system jest szybszy w uczeniu i szybszym tworzeniu nowego dźwięku. W innej części wykorzystano tekst (opis metadanych muzyki i dźwięków), który pomaga określić rodzaj generowanego dźwięku.

Aby przyspieszyć działanie, architektura Stable Audio wykorzystuje mocno uproszczoną, skompresowaną reprezentację dźwięku, aby skrócić czas wnioskowania (czas potrzebny modelowi uczenia maszynowego na wygenerowanie sygnału wyjściowego po otrzymaniu danych wejściowych). Według Stability AI, Stable Audio może renderować 95 sekund dźwięku stereo przy częstotliwości próbkowania 44,1 kHz (często nazywanej „jakością CD”) w mniej niż jedną sekundę na procesorze graficznym Nvidia A100 . A100 to mocny procesor graficzny do centrum danych, zaprojektowany do użytku ze sztuczną inteligencją i zapewniający znacznie większe możliwości niż typowy procesor graficzny do gier dla komputerów stacjonarnych.

Jak wspomniano, Stable Audio nie jest pierwszym generatorem muzyki opartym na technikach utajonego dyfuzji. W grudniu ubiegłego roku omawialiśmy Riffusion , hobbystyczną wersję audio Stable Diffusion, chociaż powstałe w ten sposób generacje odbiegały jakością od próbek Stable Audio. W styczniu firma Google wypuściła MusicLM , generator muzyki AI dla dźwięku 24 kHz, a Meta uruchomiła w sierpniu pakiet narzędzi audio typu open source (w tym generator zamiany tekstu na muzykę) o nazwie AudioCraft . Teraz, dzięki dźwiękowi stereo 44,1 kHz, Stable Diffusion podnosi stawkę.

Stability twierdzi, że Stable Audio będzie dostępne w warstwie bezpłatnej i miesięcznym planie Pro za 12 USD. Dzięki bezpłatnej opcji użytkownicy mogą generować do 20 utworów miesięcznie, każdy o maksymalnej długości 20 sekund. Plan Pro rozszerza te limity, umożliwiając generowanie 500 utworów miesięcznie i długość utworów do 90 sekund. Oczekuje się, że przyszłe wydania Stability będą zawierać modele open source oparte na architekturze Stable Audio, a także kod szkoleniowy dla osób zainteresowanych opracowywaniem modeli generowania dźwięku.

Na obecnym etapie wygląda na to, że dzięki Stable Audio możemy znaleźć się na krawędzi muzyki generowanej przez sztuczną inteligencję o jakości produkcyjnej, biorąc pod uwagę jej wierność dźwięku. Czy muzycy będą szczęśliwi, jeśli zostaną zastąpieni modelami AI? Prawdopodobnie nie, jeśli historia pokazała nam cokolwiek, począwszy od protestów AI w obszarze sztuk wizualnych . Na razie człowiek może z łatwością zdeklasować wszystko, co może wygenerować sztuczna inteligencja, ale może to nie potrwać długo. Tak czy inaczej, dźwięk generowany przez sztuczną inteligencję może stać się kolejnym narzędziem w zestawie narzędzi profesjonalisty do produkcji dźwięku.

Dodaj komentarz