Według OpenAI aktualizacja ChatGPT umożliwia sztucznej inteligencji „widzieć, słyszeć i mówić”.

W poniedziałek OpenAI ogłosiło znaczącą aktualizację ChatGPT, która umożliwia modelom AI GPT-3.5 i GPT-4 analizowanie obrazów i reagowanie na nie w ramach rozmowy tekstowej. Ponadto aplikacja mobilna ChatGPT doda opcje syntezy mowy, które w połączeniu z istniejącymi funkcjami rozpoznawania mowy umożliwią w pełni werbalne rozmowy z asystentem AI, twierdzi OpenAI.

OpenAI planuje udostępnić te funkcje w ChatGPT abonentom Plus i Enterprise „w ciągu najbliższych dwóch tygodni”. Zauważa również, że synteza mowy będzie dostępna tylko na iOS i Androidzie, a rozpoznawanie obrazów będzie dostępne zarówno w interfejsie internetowym, jak i na platformie aplikacje mobilne.

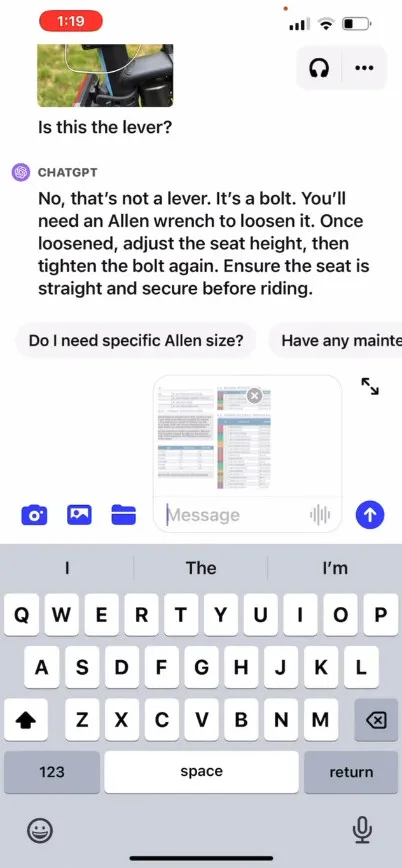

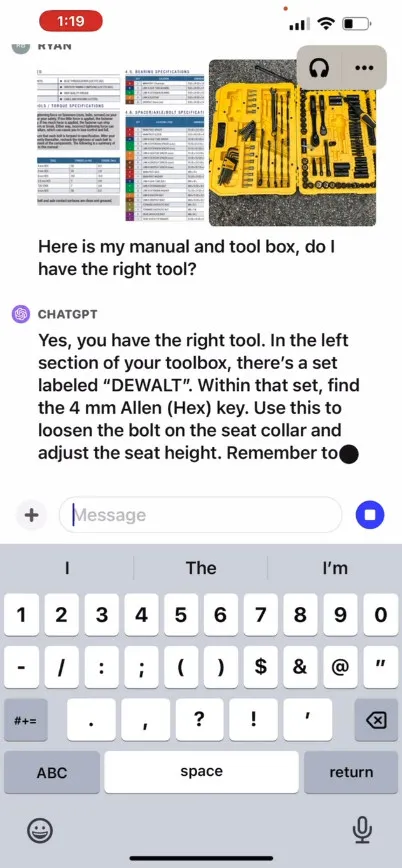

OpenAI twierdzi, że nowa funkcja rozpoznawania obrazów w ChatGPT pozwala użytkownikom przesyłać jeden lub więcej obrazów do rozmowy, korzystając z modeli GPT-3.5 lub GPT-4. W swoim promocyjnym poście na blogu firma twierdzi, że tej funkcji można używać do różnych codziennych zastosowań: od sprawdzania, co będzie na obiad, poprzez robienie zdjęć lodówki i spiżarni, po rozwiązywanie problemów, dlaczego grill się nie uruchamia. Mówi także, że użytkownicy mogą używać ekranu dotykowego swojego urządzenia do zakreślania części obrazu, na których chcą, aby ChatGPT się skoncentrował.

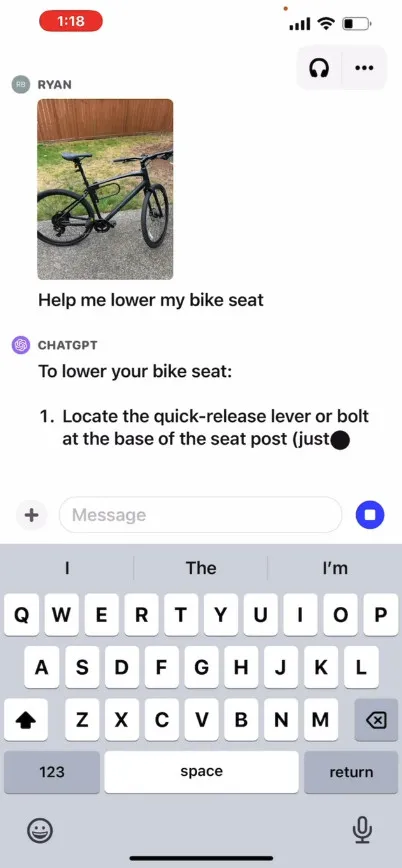

OpenAI udostępnia na swojej stronie film promocyjny ilustrujący hipotetyczną wymianę zdań z ChatGPT, w której użytkownik pyta, jak podnieść fotelik rowerowy, podając zdjęcia oraz instrukcję obsługi i obraz skrzynki z narzędziami użytkownika. ChatGPT reaguje i doradza użytkownikowi, jak zakończyć proces. Nie testowaliśmy sami tej funkcji, więc jej skuteczność w świecie rzeczywistym nie jest znana.

Jak to działa? OpenAI nie ujawniło szczegółów technicznych działania GPT-4 lub jego multimodalnej wersji, GPT-4V , ale w oparciu o znane badania AI przeprowadzone przez innych (w tym partnera OpenAI Microsoft ), multimodalne modele AI zazwyczaj przekształcają tekst i obrazy w plik wspólną przestrzeń kodowania, która umożliwia im przetwarzanie różnych typów danych za pośrednictwem tej samej sieci neuronowej. OpenAI może używać CLIP do wypełnienia luki między danymi wizualnymi i tekstowymi w sposób, który wyrównuje reprezentacje obrazu i tekstu w tej samej ukrytej przestrzeni , co jest rodzajem wektoryzowanej sieci relacji danych. Ta technika może pozwolić ChatGPT na dokonywanie kontekstowych wniosków z tekstu i obrazów, chociaż z naszej strony jest to spekulacyjne.

Tymczasem w świecie audio nowa funkcja syntezy głosu w ChatGPT podobno umożliwia konwersację głosową z ChatGPT, napędzaną tym, co OpenAI nazywa „nowym modelem zamiany tekstu na mowę”, chociaż zamiana tekstu na mowę została rozwiązana dla długi czas. Jak twierdzi firma, po wdrożeniu tej funkcji użytkownicy będą mogli z niej skorzystać, włączając rozmowy głosowe w ustawieniach aplikacji, a następnie wybierając spośród pięciu różnych syntetycznych głosów o nazwach takich jak „Juniper”, „Sky”, „Cove”, „Ember” ”i „Breeze”.OpenAI twierdzi, że te głosy zostały stworzone we współpracy z profesjonalnymi aktorami głosowymi.

Whisper OpenAI, system rozpoznawania mowy typu open source, o którym pisaliśmy we wrześniu ubiegłego roku, będzie w dalszym ciągu obsługiwać transkrypcję mowy użytkownika. Whisper został zintegrowany z aplikacją ChatGPT na iOS od jej uruchomienia w maju. W lipcu OpenAI wypuściło aplikację ChatGPT na Androida o podobnych możliwościach .

Dodaj komentarz