China continua comprando placas Nvidia prejudicadas para treinar seus modelos de IA

Os EUA agiram agressivamente no ano passado para limitar a capacidade da China de desenvolver inteligência artificial para fins militares, bloqueando a venda dos chips americanos mais avançados usados para treinar sistemas de IA.

Grandes avanços nos chips usados para desenvolver IA generativa significaram que a mais recente tecnologia dos EUA à venda na China é mais poderosa do que qualquer outra disponível antes. Isso apesar do fato de que os chips foram deliberadamente prejudicados pelo mercado chinês para limitar suas capacidades, tornando-os menos eficazes do que os produtos disponíveis em outras partes do mundo.

O resultado foi o aumento das encomendas chinesas para os mais recentes processadores avançados dos EUA. As principais empresas de Internet da China fizeram pedidos de US$ 5 bilhões em chips da Nvidia, cujas unidades de processamento gráfico se tornaram o burro de carga para o treinamento de grandes modelos de IA.

O impacto da crescente demanda global pelos produtos da Nvidia provavelmente sustentará os resultados financeiros do segundo trimestre da fabricante de chips, que serão anunciados na quarta-feira.

Além de refletir a demanda por chips aprimorados para treinar os mais recentes modelos de linguagem grande das empresas de Internet, a corrida também foi motivada por preocupações de que os EUA possam apertar ainda mais seus controles de exportação, tornando até mesmo esses produtos limitados indisponíveis no futuro.

No entanto, Bill Dally, cientista-chefe da Nvidia, sugeriu que os controles de exportação dos EUA teriam um impacto maior no futuro.

“Como os requisitos de treinamento [para os sistemas de IA mais avançados] continuam a dobrar a cada seis a 12 meses”, a diferença entre os chips vendidos na China e os disponíveis no resto do mundo “aumentará rapidamente”, disse ele.

Limitando as velocidades de processamento

Os controles de exportação de chips dos EUA do ano passado faziam parte de um pacote que incluía impedir que os clientes chineses comprassem o equipamento necessário para fabricar chips avançados.

Washington estabeleceu um limite para a velocidade máxima de processamento de chips que podem ser vendidos na China, bem como a taxa na qual os chips podem transferir dados – um fator crítico quando se trata de treinar grandes modelos de IA, um trabalho intensivo de dados que requer conectando um grande número de chips juntos.

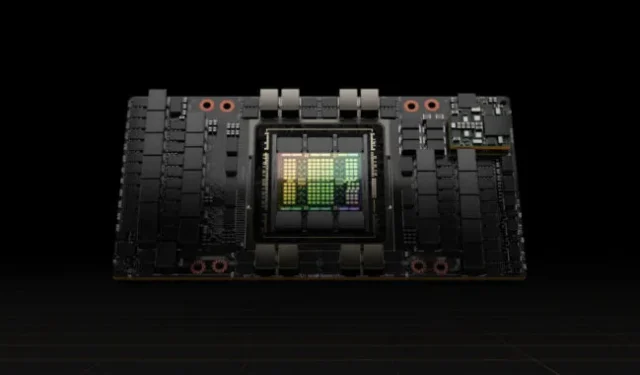

A Nvidia respondeu cortando a taxa de transferência de dados em seus processadores A100, na época suas GPUs top de linha, criando um novo produto para a China chamado A800 que satisfez os controles de exportação.

Este ano, seguiu com limites de transferência de dados em seu H100, um processador novo e muito mais poderoso que foi especialmente projetado para treinar grandes modelos de linguagem, criando uma versão chamada H800 para o mercado chinês.

A fabricante de chips não divulgou as capacidades técnicas dos processadores feitos para a China, mas os fabricantes de computadores foram abertos sobre os detalhes. A Lenovo, por exemplo, anuncia servidores contendo chips H800 que, segundo ela, são idênticos em todos os aspectos aos H100s vendidos em outras partes do mundo, exceto pelo fato de terem uma taxa de transferência de apenas 400 gigabytes por segundo.

Isso está abaixo do limite de 600 GB/s que os EUA estabeleceram para as exportações de chips para a China. Em comparação, a Nvidia disse que seu H100, que começou a enviar aos clientes no início deste ano, tem uma taxa de transferência de 900 GB/s.

A taxa de transferência mais baixa na China significa que os usuários dos chips enfrentam tempos de treinamento mais longos para seus sistemas de IA do que os clientes da Nvidia em outras partes do mundo – uma limitação importante, pois os modelos aumentaram de tamanho.

Os tempos de treinamento mais longos aumentam os custos, pois os chips precisarão consumir mais energia, um dos maiores gastos com modelos grandes.

No entanto, mesmo com esses limites, os chips H800 à venda na China são mais poderosos do que qualquer outro disponível em qualquer outro lugar antes deste ano, levando a uma enorme demanda.

Os chips H800 são cinco vezes mais rápidos do que os chips A100, que eram as GPUs mais poderosas da Nvidia, de acordo com Patrick Moorhead, analista de chips dos EUA da Moor Insights & Strategy.

Isso significa que as empresas chinesas de Internet que treinaram seus modelos de IA usando chips de última geração comprados antes dos controles de exportação dos EUA ainda podem esperar grandes melhorias comprando os semicondutores mais recentes, disse ele.

“Parece que o governo dos EUA não quer interromper o esforço de IA da China, mas torná-lo mais difícil”, disse Moorhead.

Custo benefício

Muitas empresas de tecnologia chinesas ainda estão no estágio de pré-treinamento de grandes modelos de linguagem, o que consome muito desempenho de chips de GPU individuais e exige um alto grau de capacidade de transferência de dados.

Somente os chips da Nvidia podem fornecer a eficiência necessária para o pré-treinamento, dizem os engenheiros chineses de IA. O desempenho individual do chip da série 800, apesar das velocidades de transferência enfraquecidas, ainda está à frente de outros no mercado.

“As GPUs da NVIDIA podem parecer caras, mas são, na verdade, a opção mais econômica”, disse um engenheiro de IA de uma importante empresa chinesa de Internet.

Outros fornecedores de GPU citaram preços mais baixos com serviço mais oportuno, disse o engenheiro, mas a empresa julgou que os custos de treinamento e desenvolvimento aumentariam e que teria o fardo extra da incerteza.

A oferta da Nvidia inclui o ecossistema de software, com sua plataforma de computação Compute Unified Device Architecture, ou Cuda, criada em 2006 e que se tornou parte da infraestrutura de IA.

Analistas do setor acreditam que as empresas chinesas podem em breve enfrentar limitações na velocidade de interconexões entre os chips da série 800. Isso pode prejudicar sua capacidade de lidar com a quantidade crescente de dados necessários para o treinamento de IA, e eles serão prejudicados à medida que se aprofundam na pesquisa e desenvolvimento de grandes modelos de linguagem.

Charlie Chai, um analista da 86Research baseado em Xangai, comparou a situação com a construção de muitas fábricas com rodovias congestionadas entre elas. Mesmo as empresas que podem acomodar os chips enfraquecidos podem enfrentar problemas nos próximos dois ou três anos, acrescentou.

© 2023 The Financial Times Ltd. Todos os direitos reservados. Por favor, não copie e cole artigos do FT e redistribua por e-mail ou poste na web.

Deixe um comentário