ChatGPT-uppdateringen gör att dess AI kan ”se, höra och tala”, enligt OpenAI

I måndags tillkännagav OpenAI en betydande uppdatering av ChatGPT som gör att dess GPT-3.5 och GPT-4 AI-modeller kan analysera bilder och reagera på dem som en del av en textkonversation. ChatGPT-mobilappen kommer också att lägga till talsyntesalternativ som, när de paras ihop med dess befintliga taligenkänningsfunktioner, kommer att möjliggöra helt verbala konversationer med AI-assistenten, säger OpenAI.

OpenAI planerar att lansera dessa funktioner i ChatGPT till Plus- och Enterprise-prenumeranter ”under de kommande två veckorna.” Det noteras också att talsyntes endast kommer till iOS och Android, och bildigenkänning kommer att vara tillgänglig på både webbgränssnittet och mobilappar.

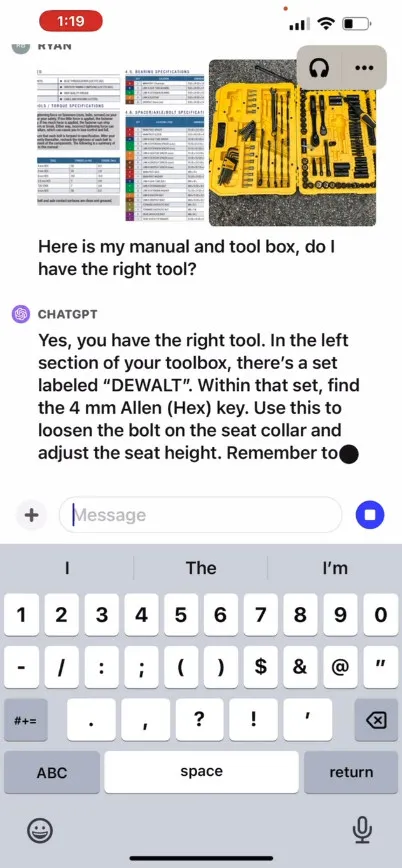

OpenAI säger att den nya bildigenkänningsfunktionen i ChatGPT låter användare ladda upp en eller flera bilder för konversation, med antingen GPT-3.5- eller GPT-4-modellerna. I sitt reklamblogginlägg hävdar företaget att funktionen kan användas för en mängd olika vardagliga applikationer: från att ta reda på vad som finns till middag genom att ta bilder av kylskåpet och skafferiet, till att felsöka varför din grill inte startar. Det står också att användare kan använda sin enhets pekskärm för att ringa in delar av bilden som de vill att ChatGPT ska koncentrera sig på.

På sin webbplats tillhandahåller OpenAI en reklamvideo som illustrerar ett hypotetiskt utbyte med ChatGPT där en användare frågar hur man höjer en cykelsits, tillhandahåller foton samt en bruksanvisning och en bild av användarens verktygslåda. ChatGPT reagerar och råder användaren hur man slutför processen. Vi har inte testat den här funktionen själva, så dess verkliga effektivitet är okänd.

Så hur fungerar det? OpenAI har inte släppt tekniska detaljer om hur GPT-4 eller dess multimodala version, GPT-4V , fungerar under huven, men baserat på känd AI-forskning från andra (inklusive OpenAI-partnern Microsoft ), omvandlar multimodala AI-modeller vanligtvis text och bilder till en delat kodningsutrymme, vilket gör att de kan bearbeta olika typer av data genom samma neurala nätverk. OpenAI kan använda CLIP för att överbrygga klyftan mellan visuella data och textdata på ett sätt som anpassar bild- och textrepresentationer i samma latenta utrymme , en sorts vektoriserad väv av datarelationer. Den tekniken skulle kunna göra det möjligt för ChatGPT att göra kontextuella avdrag över text och bilder, även om detta är spekulativt från vår sida.

Samtidigt i ljudland, enligt uppgift tillåter ChatGPT:s nya röstsyntesfunktion för fram och tillbaka talade konversationer med ChatGPT, driven av vad OpenAI kallar en ”ny text-till-tal-modell”, även om text-till-tal har lösts för en länge sedan. När funktionen rullas ut säger företaget att användare kan använda funktionen genom att välja röstkonversationer i appens inställningar och sedan välja bland fem olika syntetiska röster med namn som ”Juniper,””Sky,””Cove,””Ember ”och ”Breeze.” OpenAI säger att dessa röster har skapats i samarbete med professionella röstskådespelare.

OpenAI:s Whisper, ett system för taligenkänning med öppen källkod som vi täckte i september förra året, kommer att fortsätta att hantera transkriptionen av användarens talinmatning. Whisper har integrerats med ChatGPT iOS-appen sedan den lanserades i maj. OpenAI släppte den liknande kapabla ChatGPT Android-appen i juli.

Lämna ett svar