Kina fortsätter att köpa trasiga Nvidia-kort för att träna sina AI-modeller

USA agerade aggressivt förra året för att begränsa Kinas förmåga att utveckla artificiell intelligens för militära ändamål, vilket blockerade försäljningen där av de mest avancerade amerikanska chipsen som används för att träna AI-system.

Stora framsteg inom chipsen som används för att utveckla generativ AI har inneburit att den senaste amerikanska tekniken som säljs i Kina är mer kraftfull än någonting tillgängligt tidigare. Detta trots att chipsen medvetet har hamnat på för att den kinesiska marknaden ska begränsa deras kapacitet, vilket gör dem mindre effektiva än produkter tillgängliga på andra håll i världen.

Resultatet har blivit skyhöga kinesiska beställningar på de senaste avancerade amerikanska processorerna. Kinas ledande internetföretag har lagt beställningar för 5 miljarder dollar i chips från Nvidia, vars grafiska bearbetningsenheter har blivit arbetshästen för att träna stora AI-modeller.

Effekten av den stigande globala efterfrågan på Nvidias produkter kommer sannolikt att underbygga chiptillverkarens finansiella resultat för andra kvartalet som kommer att offentliggöras på onsdag.

Förutom att spegla efterfrågan på förbättrade chips för att träna internetföretagens senaste stora språkmodeller, har rusningen också föranletts av oro för att USA kan skärpa sina exportkontroller ytterligare, vilket gör även dessa begränsade produkter otillgängliga i framtiden.

Bill Dally, Nvidias chefsforskare, föreslog dock att USA:s exportkontroller skulle få större inverkan i framtiden.

”Eftersom utbildningskraven [för de mest avancerade AI-systemen] fortsätter att fördubblas var sjätte till 12:e månad” kommer klyftan mellan chips som säljs i Kina och de som finns tillgängliga i resten av världen ”att växa snabbt”, sa han.

Begränsning av bearbetningshastigheter

Förra årets amerikanska exportkontroll av chips var en del av ett paket som innehöll att hindra kinesiska kunder från att köpa den utrustning som behövs för att göra avancerade chips.

Washington satte ett tak för den maximala bearbetningshastigheten för chips som kan säljas i Kina, såväl som den hastighet med vilken chipsen kan överföra data – en kritisk faktor när det gäller att träna stora AI-modeller, ett dataintensivt jobb som kräver koppla ihop ett stort antal marker.

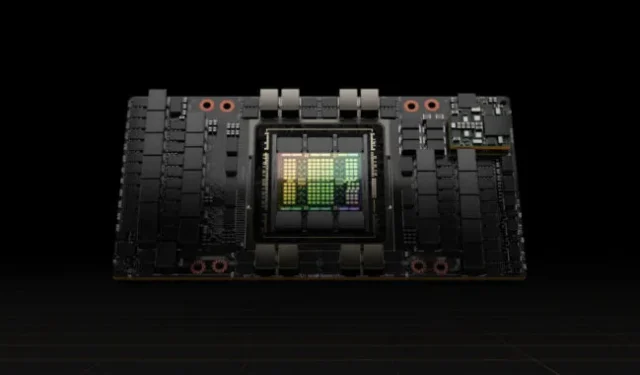

Nvidia svarade med att sänka dataöverföringshastigheten på sina A100-processorer, vid den tidpunkten dess topp-of-the-line GPU:er, och skapade en ny produkt för Kina som heter A800 som uppfyllde exportkontrollerna.

I år har det följt med dataöverföringsbegränsningar på sin H100, en ny och mycket kraftfullare processor som var speciellt designad för att träna stora språkmodeller, och skapade en version som kallas H800 för den kinesiska marknaden.

Chiptillverkaren har inte avslöjat den tekniska kapaciteten hos de tillverkade för Kina-processorer, men datortillverkarna har varit öppna med detaljerna. Lenovo annonserar till exempel servrar som innehåller H800-chips som den säger är identiska på alla sätt med H100 som säljs någon annanstans i världen, förutom att de har en överföringshastighet på endast 400 gigabyte per sekund.

Det är under gränsen på 600 GB/s som USA har satt för chipexport till Kina. Som jämförelse har Nvidia sagt att dess H100, som den började leverera till kunder tidigare i år, har en överföringshastighet på 900 GB/s.

Den lägre överföringshastigheten i Kina innebär att användare av chipsen där möter längre träningstider för sina AI-system än Nvidias kunder på andra håll i världen – en viktig begränsning eftersom modellerna har vuxit i storlek.

De längre träningstiderna ökar kostnaderna eftersom chips kommer att behöva förbruka mer ström, en av de största utgifterna med stora modeller.

Men även med dessa gränser är H800-chipsen som säljs i Kina mer kraftfulla än något annat tillgängligt någon annanstans före detta år, vilket leder till den enorma efterfrågan.

H800-chippen är fem gånger snabbare än A100-chippen som hade varit Nvidias mest kraftfulla grafikprocessorer, enligt Patrick Moorhead, en amerikansk chipanalytiker på Moor Insights & Strategy.

Det betyder att kinesiska internetföretag som tränade sina AI-modeller med hjälp av toppmoderna chip köpta innan USA:s exportkontroll fortfarande kan förvänta sig stora förbättringar genom att köpa de senaste halvledarna, sa han.

”Det verkar som om den amerikanska regeringen inte vill lägga ner Kinas AI-ansträngning, utan göra det svårare”, sa Moorhead.

Kostnad-nytta

Många kinesiska teknikföretag befinner sig fortfarande i förträning av stora språkmodeller, vilket bränner mycket prestanda från individuella GPU-chips och kräver en hög grad av dataöverföringskapacitet.

Endast Nvidias chips kan ge den effektivitet som behövs för förträning, säger kinesiska AI-ingenjörer. Den individuella chipprestandan i 800-serien, trots de försvagade överföringshastigheterna, är fortfarande före andra på marknaden.

”Nvidias GPU:er kan verka dyra men är i själva verket det mest kostnadseffektiva alternativet”, sa en AI-ingenjör på ett ledande kinesiskt internetföretag.

Andra GPU-leverantörer citerade lägre priser med snabbare service, sa ingenjören, men företaget bedömde att utbildnings- och utvecklingskostnaderna skulle öka och att det skulle medföra den extra bördan av osäkerhet.

Nvidias erbjudande inkluderar mjukvaruekosystemet, med sin datorplattform Compute Unified Device Architecture, eller Cuda, som det satte upp 2006 och som har blivit en del av AI-infrastrukturen.

Branschanalytiker tror att kinesiska företag snart kan möta begränsningar i hastigheten på sammankopplingarna mellan 800-seriens chips. Detta kan hindra deras förmåga att hantera den ökande mängden data som krävs för AI-träning, och de kommer att hämmas när de går djupare in i att forska och utveckla stora språkmodeller.

Charlie Chai, en Shanghai-baserad analytiker på 86Research, jämförde situationen med att bygga många fabriker med överbelastade motorvägar mellan sig. Även företag som kan ta emot de försvagade markerna kan få problem inom de kommande två eller tre åren, tillade han.

© 2023 The Financial Times Ltd. Med ensamrätt. Vänligen kopiera och klistra inte in FT-artiklar och vidaredistribuera via e-post eller post till webben.

Lämna ett svar