中國不斷購買有問題的英偉達卡來訓練其人工智能模型

美國去年採取了積極行動,限制中國開髮用於軍事目的的人工智能的能力,阻止向中國出售用於訓練人工智能係統的最先進的美國芯片。

用於開發生成人工智能的芯片的巨大進步意味著在中國銷售的最新美國技術比以往任何技術都更強大。儘管事實上這些芯片在中國市場上被故意限制以限制其功能,使其不如世界其他地方的產品有效。

結果是中國對美國最新先進處理器的訂單猛增。中國領先的互聯網公司已向英偉達訂購了價值 50 億美元的芯片,英偉達的圖形處理單元已成為訓練大型人工智能模型的主力。

全球對英偉達產品需求飆升的影響可能會支撐該芯片製造商將於週三公佈的第二季度財務業績。

除了反映了對改進芯片來訓練互聯網公司最新大型語言模型的需求外,人們對美國可能進一步收緊出口管制,甚至這些有限的產品未來也將無法使用的擔憂也促使了這種熱潮。

不過,英偉達首席科學家比爾·達利表示,美國的出口管制未來將產生更大的影響。

他表示,“隨著(最先進的人工智能係統)的培訓要求每六到十二個月增加一倍,”中國銷售的芯片與世界其他地區銷售的芯片之間的差距“將迅速擴大”。

封蓋處理速度

去年美國對芯片的出口管制是一攬子計劃的一部分,其中包括阻止中國客戶購買製造先進芯片所需的設備。

華盛頓對可在中國銷售的芯片的最大處理速度以及芯片傳輸數據的速度設定了上限——這是訓練大型人工智能模型的一個關鍵因素,這是一項數據密集型工作,需要將大量芯片連接在一起。

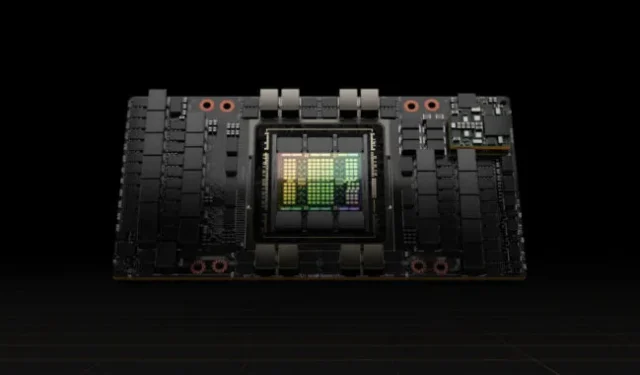

Nvidia 的回應是降低了 A100 處理器(當時是其頂級 GPU)的數據傳輸速率,為中國開發了一款名為 A800 的新產品,以滿足出口管制的要求。

今年,它對其 H100 進行了數據傳輸限制,H100 是一款功能更強大的新型處理器,專門設計用於訓練大型語言模型,並為中國市場創建了名為 H800 的版本。

該芯片製造商尚未透露專為中國製造的處理器的技術能力,但計算機製造商已公開了細節。例如,聯想在廣告中宣傳含有 H800 芯片的服務器,稱這些服務器在各方面與世界其他地方銷售的 H100 芯片完全相同,只是傳輸速率僅為每秒 400 GB。

這低於美國對中國芯片出口設定的 600GB/s 限制。相比之下,Nvidia 表示,今年早些時候開始向客戶發貨的 H100 的傳輸速率為 900GB/s。

中國較低的傳輸速率意味著,與英偉達在世界其他地方的客戶相比,中國芯片的用戶面臨著更長的人工智能係統訓練時間——隨著模型規模的擴大,這是一個重要的限制。

較長的訓練時間會增加成本,因為芯片需要消耗更多的電量,這是大型模型的最大支出之一。

然而,即使有這些限制,在中國銷售的 H800 芯片比今年之前在其他任何地方銷售的任何芯片都更強大,從而導致了巨大的需求。

Moor Insights & Strategy 美國芯片分析師 Patrick Moorhead 表示,H800 芯片的速度是 Nvidia 最強大 GPU 的 A100 芯片的五倍。

他表示,這意味著使用在美國出口管制之前購買的頂級芯片訓練人工智能模型的中國互聯網公司仍然可以通過購買最新的半導體來獲得巨大的進步。

“看來美國政府不想阻止中國的人工智能努力,而是想讓它變得更難,”穆爾黑德說。

成本效益

許多中國科技公司仍處於預訓練大型語言模型的階段,這會消耗大量單個GPU芯片的性能,並對數據傳輸能力提出很高的要求。

中國人工智能工程師表示,只有英偉達的芯片才能提供預訓練所需的效率。儘管傳輸速度有所減弱,800系列的單顆芯片性能仍然領先於市場上的其他芯片。

“Nvidia 的 GPU 可能看起來很昂貴,但實際上是最具成本效益的選擇,”中國一家領先互聯網公司的一位人工智能工程師表示。

該工程師表示,其他 GPU 供應商報價更低,服務更及時,但該公司認為培訓和開發成本將會增加,並且會帶來額外的不確定性負擔。

Nvidia 的產品包括軟件生態系統及其計算平台計算統一設備架構(Cuda),該平台於 2006 年建立,現已成為人工智能基礎設施的一部分。

業內分析人士認為,中國企業可能很快就會面臨800系列芯片之間互連速度的限制。這可能會阻礙他們處理人工智能訓練所需的不斷增加的數據量的能力,並且當他們深入研究和開發大型語言模型時,他們將受到阻礙。

86Research駐上海分析師查理·柴(Charlie Chai)將這種情況比作建造許多工廠,而工廠之間卻有擁擠的高速公路。他補充說,即使是能夠容納被削弱的芯片的公司也可能在未來兩三年內面臨問題。

© 2023 英國金融時報有限公司。保留所有權利。請不要復制和粘貼《金融時報》文章並通過電子郵件重新分發或發佈到網絡上。

發佈留言