AI 現在可以從文本生成 CD 品質的音樂,而且只會變得更好

想像一下,輸入“戲劇性的介紹音樂”並聽到一首高亢的交響樂,或者寫下“令人毛骨悚然的腳步聲”並獲得高品質的音效。這就是 Stable Audio 的承諾,Stability AI週三宣布了一種文本到音頻的人工智能模型,可以根據書面描述合成音樂或聲音。不久之後,類似的技術可能會挑戰音樂家的工作。

如果您還記得,Stability AI 是一家幫助資助創建Stable Diffusion的公司,這是一種於 2022 年 8 月發布的潛在擴散圖像合成模型。該公司不滿足於僅限於生成圖像,還通過支持Harmonai涉足音頻領域,一家人工智能實驗室於 9 月份推出了音樂生成器Dance Diffusion。

現在 Stability 和 Harmonai 希望通過 Stable Audio 進軍商業人工智能音頻製作領域。從生產樣本來看,與我們之前見過的人工智能音頻生成器相比,這似乎是一個重大的音頻質量升級。

在其宣傳頁面上,Stability 提供了AI 模型的實際應用示例,其中包含“史詩般的預告片音樂、激烈的部落打擊樂和銅管樂”和“lofi 嘻哈節拍旋律chillhop 85 bpm”等提示。它還提供了使用Stable Audio 生成的音效樣本,例如航空公司飛行員通過對講機講話以及人們在繁忙的餐廳中交談。

為了訓練其模型,Stability 與音樂提供商AudioSparx合作,並授權了一個數據集,該數據集“由超過800,000 個音頻文件組成,其中包含音樂、音效和單樂器主幹,以及相應的文本元數據。”在輸入了19,500 小時的音頻後在模型中,Stable Audio 知道如何模仿它在命令中聽到的某些聲音,因為這些聲音已與其神經網絡中的文本描述相關聯。

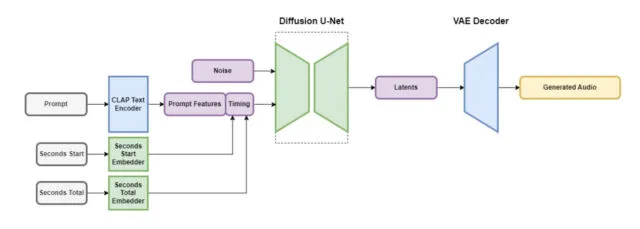

穩定音頻包含多個部分,這些部分協同工作可快速創建自定義音頻。其中一部分以保留其重要功能的方式縮小音頻文件,同時消除不必要的噪音。這使得系統的教學速度更快,創建新音頻的速度也更快。另一部分使用文本(音樂和聲音的元數據描述)來幫助指導生成哪種類型的音頻。

為了加快速度,穩定音頻架構在高度簡化、壓縮的音頻表示上運行,以減少推理時間(機器學習模型在獲得輸入後生成輸出所需的時間)。據 Stability AI 稱,Stable Audio 可以在Nvidia A100 GPU上以 44.1 kHz 採樣率(通常稱為“CD 質量”)在不到一秒的時間內渲染 95 秒的立體聲音頻。A100 是一款強大的數據中心 GPU,專為 AI 使用而設計,其功能比典型的桌面遊戲 GPU 強大得多。

如前所述,Stable Audio 並不是第一個基於潛在擴散技術的音樂生成器。去年 12 月,我們報導了Riffusion,這是一個業餘愛好者對 Stable Diffusion 的音頻版本的嘗試,儘管它的生成版本在質量上與 Stable Audio 的樣本相去甚遠。1 月份,Google 發布了MusicLM,這是一款 24 kHz 音頻的人工智能音樂生成器,Meta 於 8 月份推出了一套名為AudioCraft的開源音頻工具(包括文本到音樂生成器) 。現在,憑藉 44.1 kHz 立體聲音頻,Stable Diffusion 正在提高賭注。

Stability 表示,Stable Audio 將提供免費套餐和每月 12 美元的專業套餐。通過免費選項,用戶每月最多可以生成 20 首曲目,每首曲目的最大長度為 20 秒。Pro 計劃擴展了這些限制,允許每月生成 500 次軌跡,軌跡長度最長可達 90 秒。未來的穩定性版本預計將包括基於穩定音頻架構的開源模型,以及為那些對開發音頻生成模型感興趣的人提供的培訓代碼。

就目前情況而言,考慮到其音頻保真度,我們看起來可能處於使用穩定音頻製作高質量人工智能生成音樂的邊緣。如果音樂家被人工智能模型取代,他們會高興嗎?如果歷史向我們展示了視覺藝術領域人工智能抗議的任何內容,那麼很可能不會。目前,人類可以輕鬆超越人工智能可以生成的任何東西,但這種情況可能不會持續太久。無論哪種方式,人工智能生成的音頻都可能成為專業人士音頻製作工具箱中的另一個工具。

發佈留言