據 OpenAI 稱,ChatGPT 更新使其 AI 能夠“看、聽、說”

週一,OpenAI宣布對 ChatGPT 進行重大更新,使其 GPT-3.5 和 GPT-4 AI 模型能夠分析圖像並在文字對話中對其做出反應。OpenAI 表示,ChatGPT 行動應用程式還將添加語音合成選項,與現有的語音辨識功能配合使用時,將能夠與人工智慧助理進行完全口頭對話。

OpenAI 計劃「在未來兩週內」向 Plus 和 Enterprise 訂閱者推出 ChatGPT 中的這些功能。它還指出,語音合成僅適用於 iOS 和 Android,圖像識別將在 Web 介面和行動應用程式中。

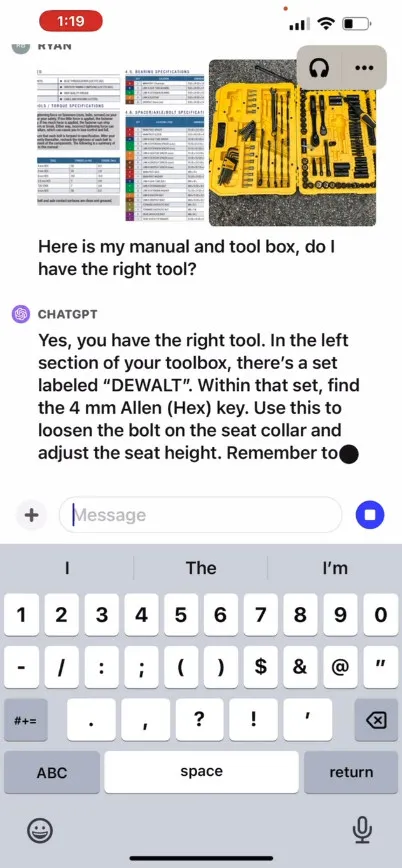

OpenAI 表示,ChatGPT 中的新影像辨識功能可讓使用者使用 GPT-3.5 或 GPT-4 模型上傳一張或多張影像進行對話。該公司在宣傳部落格文章中聲稱,該功能可用於各種日常應用:從透過拍攝冰箱和食品儲藏室的照片來確定晚餐吃什麼,到排除燒烤爐無法啟動的原因。它還表示,用戶可以使用裝置的觸控螢幕圈出他們希望 ChatGPT 關注的影像部分。

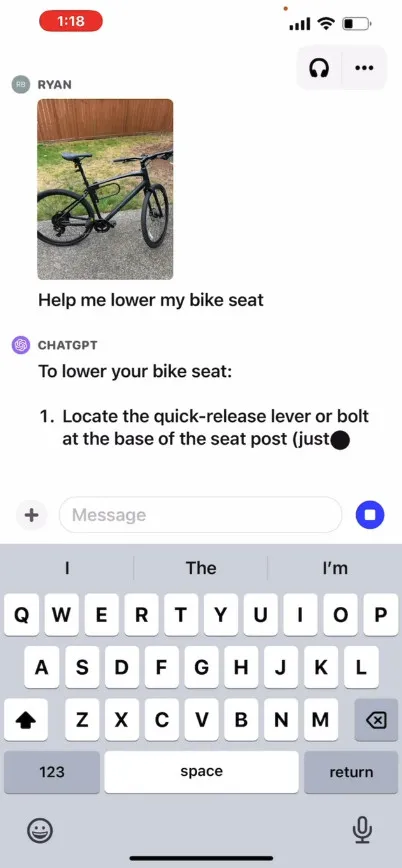

OpenAI 在其網站上提供了一段宣傳視頻,展示了與 ChatGPT 的假設交流,其中用戶詢問如何升高自行車座椅,並提供照片以及說明手冊和用戶工具箱的圖像。ChatGPT 做出反應並建議使用者如何完成流程。我們尚未親自測試此功能,因此其實際效果尚不清楚。

那麼它是怎樣工作的呢?OpenAI 尚未發布 GPT-4 或其多模態版本GPT-4V如何在後台運行的技術細節,但根據其他人(包括 OpenAI 合作夥伴Microsoft )的已知 AI 研究,多模態AI 模型通常將文字和圖像轉換為文字和圖像。共享編碼空間,這使得它們能夠透過同一個神經網路處理各種類型的資料。OpenAI 可以使用CLIP來彌合視覺資料和文字資料之間的差距,從而在同一潛在空間(一種資料關係的向量化網路)中對齊圖像和文字表示。該技術可以讓 ChatGPT 跨文本和圖像進行上下文推斷,儘管這對我們來說是推測性的。

同時,在音訊領域,據報道,ChatGPT 的新語音合成功能允許與 ChatGPT 進行來回語音對話,該功能由 OpenAI 所謂的「新文字轉語音模型」驅動,儘管文字轉語音問題已經解決了很長時間。該公司表示,一旦該功能推出,用戶可以透過在應用程式設定中選擇語音對話來使用該功能,然後從五種不同的合成語音中進行選擇,這些合成語音的名稱包括“Juniper”、“Sky” 、「Cove」、「Ember」、」和「微風」。OpenAI 表示,這些聲音是與專業配音員合作製作的。

OpenAI 的 Whisper 是我們去年 9 月介紹的開源語音辨識系統,將繼續處理使用者語音輸入的轉錄。自 5 月推出以來,Whisper 已與ChatGPT iOS 應用程式整合。OpenAI 在 7 月發布了具有類似功能的ChatGPT Android 應用程式。

發佈留言