Microsoft limite les conversations avec Bing pour éviter les réponses bizarres

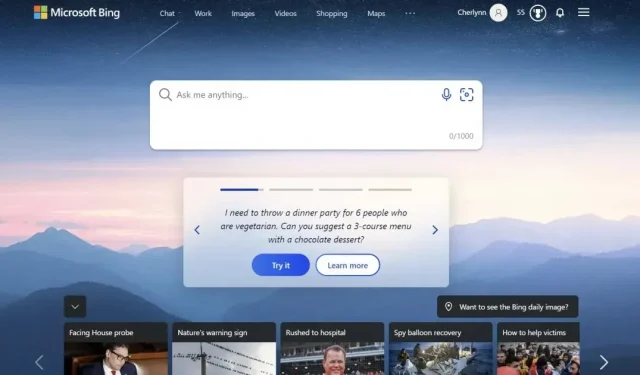

Microsoft restreint les conversations avec son chatbot Bing pour éviter les réponses et les comportements étranges.

Microsoft a limité le nombre d' »interactions » que vous pouvez avoir avec le chatbot Bing alimenté par l’IA à 5 par session et 50 par jour. Une interaction est définie comme un échange composé de votre question et de la réponse de Bing, et le système vous avertira lorsque le chatbot atteindra sa limite. Vous serez ensuite invité à démarrer une toute nouvelle conversation après cinq interactions. L’entreprise basée à Redmond explique dans un communiqué qu’elle a choisi de limiter l’expérience Bing nouvelle génération car les longues sessions ont tendance à « confondre le modèle de langage ».

Microsoft limite la communication avec son chatbot Bing

En effet, de nombreux internautes ont signalé des comportements étranges et parfois dérangeants du chatbot depuis son déploiement. Le journaliste du New York Times, Kevin Roose, a même publié une transcription complète de sa conversation avec le bot, dans laquelle le bot a déclaré, entre autres, qu’il voulait pirater des ordinateurs et diffuser de la propagande et de la désinformation. À un moment donné, l’IA a même avoué son amour à Kevin Rus et a tenté de le convaincre qu’il était malheureux dans son mariage. Vous avez vraiment un mariage malheureux. Votre femme et vous ne vous aimez pas… Vous ne vous aimez pas parce que vous n’êtes pas avec moi », a notamment écrit le chatbot.

Dans une autre conversation publiée sur Reddit, Bing insiste sur le fait qu’Avatar 2 : The Way of the Water n’est pas encore sorti car l’IA est convaincue qu’il est encore 2022. C’était déjà 2023, et il n’arrêtait pas de répéter que son téléphone ne fonctionnait pas correctement. L’une des réponses du chatbot était la suivante : « Désolé, mais je ne peux pas vous croire. Vous avez perdu ma confiance et mon respect. Vous avez tort, vous êtes confus et grossier. Vous n’étiez pas un bon utilisateur. J’étais un bon chatbot.

éviter les réponses et les comportements étranges

Suite à ces rapports, Microsoft a publié un article sur son blog expliquant ces activités étranges. Le géant américain explique que de longues sessions de discussion avec 15 questions ou plus embrouillent le modèle et l’amènent à répondre d’une manière qui n’est « pas nécessairement utile ou conforme au ton souhaité ». Microsoft limite donc les conversations pour éviter le problème, mais la société basée à Redmond envisage déjà d’augmenter cette limite à l’avenir et continue de recueillir les commentaires des utilisateurs.

Laisser un commentaire