Представьте себе, что вы набираете «драматическую вступительную музыку» и слышите парящую симфонию или пишете «жуткие шаги» и получаете высококачественные звуковые эффекты. Это обещание Stable Audio, модели искусственного интеллекта для преобразования текста в аудио, анонсированной в среду компанией Stability AI, которая может синтезировать музыку или звуки из письменных описаний. Вскоре подобная технология может бросить вызов музыкантам в их работе.

Если вы помните, Stability AI — это компания, которая помогла профинансировать создание Stable Diffusion , модели синтеза изображений со скрытой диффузией, выпущенной в августе 2022 года. Не ограничиваясь созданием изображений, компания занялась аудио, поддержав Harmonai . лаборатория искусственного интеллекта, которая в сентябре запустила музыкальный генератор Dance Diffusion .

Теперь Stability и Harmonai хотят начать коммерческое производство аудио с использованием искусственного интеллекта с помощью Stable Audio. Судя по производственным образцам , это выглядит как значительное улучшение качества звука по сравнению с предыдущими аудиогенераторами AI, которые мы видели.

На своей рекламной странице Stability предоставляет примеры модели искусственного интеллекта в действии с такими подсказками, как «эпическая музыка в трейлере, интенсивные племенные перкуссии и духовые инструменты» и «лофи-хип-хоп, мелодичный чилл-хоп, 85 ударов в минуту». Он также предлагает образцы звуковых эффектов, созданных с помощью Stable Audio. , например, пилот авиакомпании говорит по внутренней связи или люди разговаривают в оживленном ресторане.

Для обучения своей модели Stability заключила партнерское соглашение с поставщиком стандартной музыки AudioSparx и лицензировала набор данных, «состоящий из более чем 800 000 аудиофайлов, содержащих музыку, звуковые эффекты и основы отдельных инструментов, а также соответствующие текстовые метаданные». После подачи 19 500 часов аудио в модель Stable Audio знает, как имитировать определенные звуки, которые он слышал по команде, поскольку эти звуки были связаны с их текстовыми описаниями в его нейронной сети.

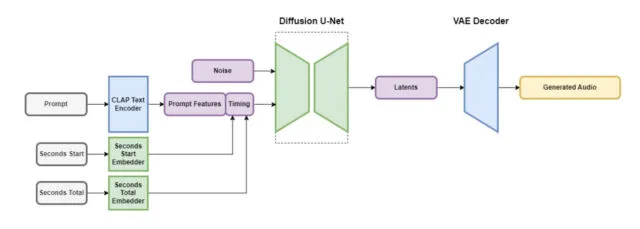

Stable Audio состоит из нескольких частей, которые работают вместе для быстрого создания индивидуального звука. Одна часть сжимает аудиофайл таким образом, чтобы сохранить его важные функции и удалить ненужный шум. Это позволяет системе быстрее обучаться и быстрее создавать новый звук. Другая часть использует текст (описания метаданных музыки и звуков), чтобы определить, какой тип звука создается.

Чтобы ускорить процесс, архитектура Stable Audio использует сильно упрощенное сжатое аудиопредставление, чтобы сократить время вывода (количество времени, которое требуется модели машинного обучения для генерации выходных данных после получения входных данных). По данным Stability AI, Stable Audio может воспроизводить 95 секунд стереозвука с частотой дискретизации 44,1 кГц (часто называемой «качеством компакт-диска») менее чем за одну секунду на графическом процессоре Nvidia A100 . A100 — это мощный графический процессор для центров обработки данных, предназначенный для использования искусственного интеллекта, и он гораздо более эффективен, чем типичный игровой графический процессор для настольных ПК.

Как уже упоминалось, Stable Audio — не первый музыкальный генератор, основанный на методах скрытого распространения. В декабре прошлого года мы рассказали о Riffusion , любительской версии аудиоверсии Stable Diffusion, хотя ее последующие поколения были далеки от семплов Stable Audio по качеству. В январе Google выпустила MusicLM , музыкальный генератор искусственного интеллекта для звука 24 кГц, а в августе Meta запустила набор аудиоинструментов с открытым исходным кодом (включая генератор текста в музыку) под названием AudioCraft . Теперь, благодаря стереозвуку 44,1 кГц, Stable Diffusion поднимает ставки.

Stability сообщает, что Stable Audio будет доступен на бесплатном уровне и ежемесячном плане Pro за 12 долларов. Благодаря бесплатной опции пользователи могут создавать до 20 треков в месяц, максимальная продолжительность каждого из которых составляет 20 секунд. План Pro расширяет эти ограничения, позволяя создавать 500 треков в месяц и длину треков до 90 секунд. Ожидается, что будущие выпуски Stability будут включать модели с открытым исходным кодом, основанные на архитектуре Stable Audio, а также обучающий код для тех, кто заинтересован в разработке моделей генерации звука.

В нынешнем виде похоже, что мы находимся на пороге создания качественной музыки, генерируемой искусственным интеллектом, с помощью Stable Audio, учитывая ее качество звука. Будут ли музыканты счастливы, если их заменят модели искусственного интеллекта? Скорее всего, нет, если история показала нам что-нибудь из протестов ИИ в сфере изобразительного искусства . На данный момент человек может легко превзойти все, что может создать ИИ, но, возможно, это продлится недолго. В любом случае, звук, генерируемый искусственным интеллектом, может стать еще одним инструментом в наборе инструментов профессионального аудиопроизводства.