Amazon выясняет, как заставить голосового помощника Alexa глубоко имитировать голос любого человека, мертвого или живого, с помощью всего лишь короткой записи. Компания продемонстрировала эту функцию на своей конференции re: Mars в Лас-Вегасе в среду, используя эмоциональную травму от продолжающейся пандемии и горя, чтобы вызвать интерес.

Re:Mars от Amazon посвящен искусственному интеллекту, машинному обучению, робототехнике и другим новым технологиям, а на сцене выступают технические эксперты и лидеры отрасли. Во время основного доклада второго дня Рохит Прасад, старший вице-президент и главный научный сотрудник Alexa AI в Amazon, продемонстрировал функцию, которая в настоящее время разрабатывается для Alexa.

На демонстрации ребенок спрашивает Алексу: «Может ли бабушка дочитать для меня «Волшебника страны Оз»?» Алекса отвечает: «Хорошо», — своим типичным женоподобным роботизированным голосом. Но тут из динамика раздается голос бабушки ребенка, которая читает сказку Л. Фрэнка Баума.

Вы можете посмотреть демо ниже:

Прасад только сказал, что Amazon «работает» над возможностью Alexa, и не уточнил, какая работа остается и когда и будет ли она доступна.

Однако он предоставил мельчайшие технические подробности.

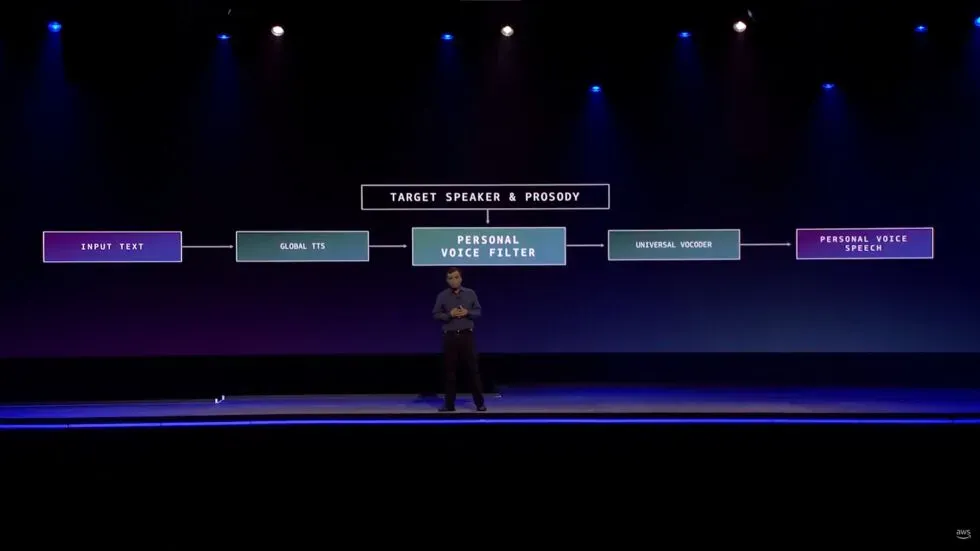

«Потребовалось изобретение, когда нам нужно было научиться воспроизводить высококачественный голос менее чем за минуту записи по сравнению с часами записи в студии», — сказал он. «Мы сделали это возможным, сформулировав проблему как проблему преобразования голоса, а не проблему генерации речи».

Конечно, дипфейки всех типов обычно имеют неоднозначную репутацию. Тем не менее, были предприняты некоторые попытки использовать эту технологию как инструмент, а не средство для жуткости.

Аудио дипфейки, в частности, как отмечает The Verge, использовались в СМИ, чтобы компенсировать, скажем, случай, когда подкастер перепутал строчку или когда звезда проекта внезапно умерла, как это произошло с документальным фильмом Энтони Бурдена Roadrunner .

Издание отмечает, что есть даже случаи, когда люди используют ИИ для создания чат-ботов , которые общаются так, как будто они потеряли близких.

Alexa даже не будет первым потребительским продуктом, использующим дипфейк-аудио вместо члена семьи, который не может присутствовать лично. Умная колонка Takara Tomy , как указывает Гиз Модо , использует искусственный интеллект , чтобы читать детям сказки на ночь голосом родителя. Сообщается, что родители загружают свои голоса, читая сценарий, так сказать, около 15 минут. Хотя это заметно отличается от демонстрации Amazon тем, что владелец продукта предпочитает предоставлять свой собственный вокал, а не продукт, использующий голос кого-то, кто, вероятно, не может дать свое разрешение.

Помимо опасений по поводу того, что дипфейки используются для мошенничества, грабежей и других гнусных действий, уже есть некоторые тревожные вещи о том, как Amazon создает эту функцию, у которой еще даже нет даты выпуска.

Прежде чем показать демонстрацию, Прасад рассказал о том, как Alexa создает у пользователей «отношения товарищества».

«В этой роли товарищества человеческие качества эмпатии и аффекта являются ключевыми для построения доверия», — сказал генеральный директор. «Эти атрибуты стали еще более важными во время продолжающейся пандемии, когда многие из нас потеряли кого-то, кого мы любим. Хотя ИИ не может устранить эту боль потери, он определенно может расширить их память».

Прасад добавил, что эта функция «обеспечивает длительные личные отношения».

Это правда, что бесчисленное множество людей всерьез ищут человеческого «сочувствия и аффекта» в ответ на эмоциональный стресс, вызванный пандемией COVID-19. Однако голосовой помощник Amazon с искусственным интеллектом не справляется с задачей удовлетворения этих человеческих потребностей. Alexa также не может обеспечить «долгосрочные личные отношения» с людьми, которых больше нет с нами.

Нетрудно поверить, что за этой развивающейся функцией стоят добрые намерения и что услышать голос человека, по которому вы скучаете, может быть большим утешением. Теоретически мы могли бы даже повеселиться с такой функцией. Заставить Алексу заставить друга звучать так, будто он сказал что-то глупое, безвредно. И, как мы уже говорили выше, есть и другие компании, использующие технологию дипфейков аналогично тому, что продемонстрировала Amazon.

Но представление развивающейся способности Alexa как способа восстановить связь с умершими членами семьи — гигантский, нереальный и проблематичный скачок. Между тем трогать струны сердца, вызывающие горе и одиночество, связанные с пандемией, кажется бесполезным. Есть места, которым Amazon не принадлежит, и консультирование по вопросам горя — одно из них.