В понедельник OpenAI объявила о значительном обновлении ChatGPT, которое позволяет моделям искусственного интеллекта GPT-3.5 и GPT-4 анализировать изображения и реагировать на них в рамках текстового разговора. Кроме того, по словам OpenAI, в мобильное приложение ChatGPT будут добавлены параметры синтеза речи, которые в сочетании с существующими функциями распознавания речи позволят вести полностью устные разговоры с помощником искусственного интеллекта.

OpenAI планирует внедрить эти функции в ChatGPT для подписчиков Plus и Enterprise «в течение следующих двух недель». Он также отмечает, что синтез речи появится только на iOS и Android, а распознавание изображений будет доступно как в веб-интерфейсе, так и в мобильные приложения.

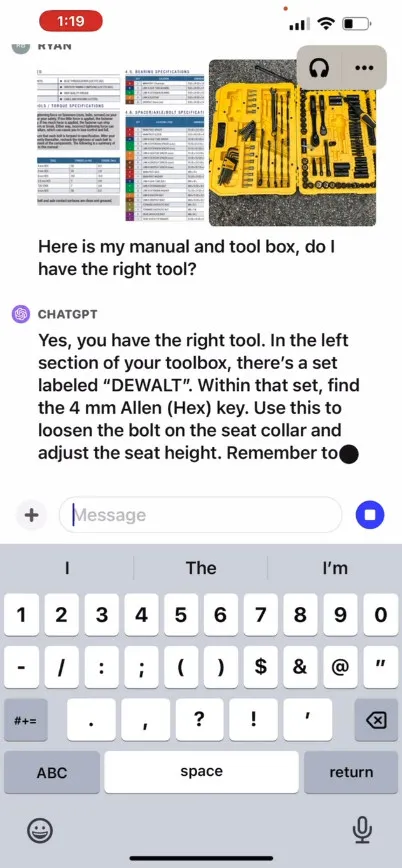

OpenAI сообщает, что новая функция распознавания изображений в ChatGPT позволяет пользователям загружать одно или несколько изображений для разговора, используя модели GPT-3.5 или GPT-4. В своем рекламном сообщении в блоге компания утверждает, что эту функцию можно использовать для различных повседневных задач: от выяснения того, что на ужин, путем фотографирования холодильника и кладовой, до устранения неполадок, почему гриль не запускается. В нем также говорится, что пользователи могут использовать сенсорный экран своего устройства, чтобы обвести части изображения, на которых они хотели бы сосредоточить внимание ChatGPT.

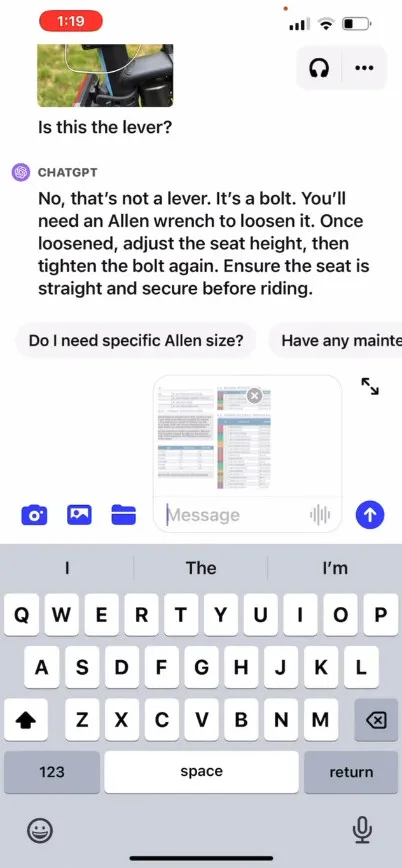

На своем сайте OpenAI размещает рекламный видеоролик , иллюстрирующий гипотетический обмен информацией с ChatGPT, где пользователь спрашивает, как поднять сиденье велосипеда, предоставляя фотографии, а также инструкцию по эксплуатации и изображение пользовательского ящика с инструментами. ChatGPT реагирует и советует пользователю, как завершить процесс. Мы сами не тестировали эту функцию, поэтому ее реальная эффективность неизвестна.

Итак, как это работает? OpenAI не раскрывает технических подробностей о том, как GPT-4 или его мультимодальная версия GPT-4V работают под капотом, но, основываясь на известных исследованиях ИИ, проведенных другими (в том числе партнером OpenAI Microsoft ), мультимодальные модели ИИ обычно преобразуют текст и изображения в общее пространство кодирования, которое позволяет им обрабатывать различные типы данных через одну и ту же нейронную сеть. OpenAI может использовать CLIP для преодоления разрыва между визуальными и текстовыми данными таким образом, чтобы выравнивать изображения и текстовые представления в одном скрытом пространстве , своего рода векторизованную сеть отношений данных. Этот метод может позволить ChatGPT делать контекстуальные выводы по тексту и изображениям, хотя с нашей стороны это предположение.

Между тем, в области аудио новая функция синтеза голоса ChatGPT, как сообщается, позволяет вести двусторонний разговор с ChatGPT, что основано на том, что OpenAI называет «новой моделью преобразования текста в речь», хотя преобразование текста в речь было решено уже давно. много времени. Компания заявляет, что после запуска этой функции пользователи смогут задействовать ее, включив голосовое общение в настройках приложения, а затем выбрав один из пяти различных синтетических голосов с такими именами, как «Можжевельник», «Небо», «Бухта», «Эмбер». » и «Бриз». OpenAI утверждает, что эти голоса были созданы в сотрудничестве с профессиональными актерами озвучивания.

Whisper от OpenAI, система распознавания речи с открытым исходным кодом, о которой мы рассказывали в сентябре прошлого года, будет продолжать выполнять транскрипцию пользовательского речевого ввода. Whisper интегрирован с приложением ChatGPT для iOS с момента его запуска в мае. В июле OpenAI выпустила Android-приложение ChatGPT с аналогичными возможностями .